这几日,OpenAI和谷歌俨然似打擂台般。就在昨天,ChatGPT搜索功能再次大升级,向全球所有用户免费开放,有网友甚至直言“谷歌正式倒闭”。再往前一日,谷歌又放出最新版视频生成模型VEO2,实测效果被许多人认为已“超越Sora”。

今天,OpenAI则专门为开发人员推出了功能更强大的模型、新的定制工具以及可提高性能、灵活性和成本效益的升级,包括:

- API 中的 OpenAI o1,支持函数调用、开发人员消息、结构化输出和视觉功能。

- 实时 API 更新,包括简单的 WebRTC 集成、GPT-4o 音频降价 60% 以及以以前音频速率的十分之一支持 GPT-4o mini。

- 偏好微调,这是一种新的模型定制技术,可根据用户和开发人员的偏好更轻松地定制模型。

- 新的 Go 和 Java SDK在 Beta 版中可用。

“对于开发者来说,这是迄今为止最有用的一天。”有网友表示。

API用户可以完全访问o1

从今天开始,o1 将在API的第5使用层向开发人员推出。o1 是OpenAI 的推理模型,旨在以更高的准确性处理复杂的多步骤任务,已经有开发人员在使用 o1-preview构建代理应用程序,以简化客户支持、优化供应链决策和预测复杂的金融趋势。

作为o1-preview的后续版本,o1 具备了更多生产就绪的关键功能,可支持现实世界中的使用案例。其中包括,函数调用可将 o1 无缝连接到外部数据和 API;结构化输出能够生成可靠遵守自定义 JSON 架构的响应;开发人员消息即指定模型要遵循的说明或上下文,如定义语气、样式和其他行为指导;视觉功能指可以对图像进行推理,以解锁视觉输入很重要的科学、制造或编码中的更多应用。

对于给定请求,o1 比 o1-preview 平均少用 60% 的推理tokens 。并且,新增的 API 参数“reasoning_effort ”允许用户控制模型在回答问题前的思考时间。

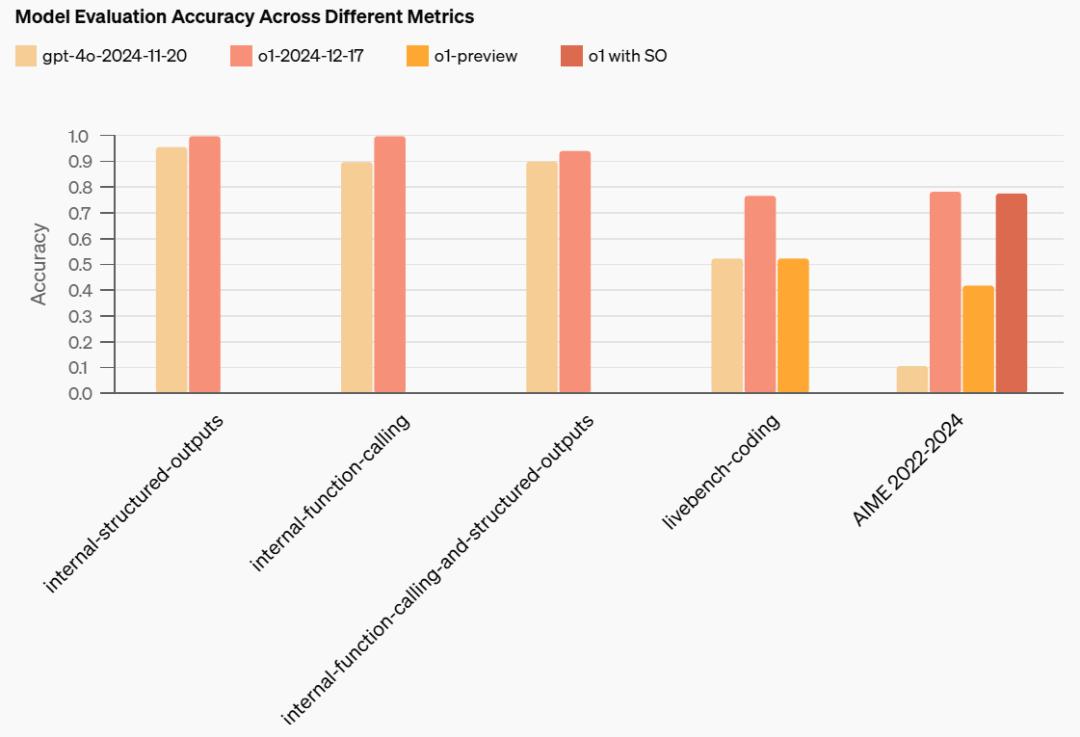

据介绍,OpenAI刚发布的 o1 是两周前在 ChatGPT 中发布模型的新后训练版本,在几项基准测试中均取得了最新成果,并提高了成本效益和性能。此外,OpenAI观察到, 其在函数调用和结构化输出测试中明显优于 o1-preview。

需要注意的是,开发人员要想访问第 5 使用层的o1,必须在 OpenAI 上花费至少 1000 美元,并且拥有自首次成功付款以来超过 30 天的帐户。

降价实时API并发布一系列更新

两个月前,OpenAI 发布了实时 API (Realtime API)的公开测试版,使开发者能够使用先进的语音到语音模型进行开发。据介绍,实时 API是语音助手、实时翻译工具、虚拟导师、交互式客户支持系统的理想选择。

但当时有很多用户对其吐槽,“通往新时代的价格太贵了”。今天,OpenAI 宣布降低实时 API的定价。

据介绍,由于提高了效率,实时 API的音频token 价格降低了 60%,为 40 美元/100 万个输入token和 80 美元/100 万个输出token。缓存音频输入成本降低了 87.5%,降至 2.50 美元/100 万输入token。

OpenAI 还将 GPT-4o mini 带入实时 API 测试版,GPT-4o mini 音频价格为 10 美元/100 万个输入token,20 美元/100 万个输出token;文本价格为 0.60 美元/100 万个输入token和 2.40 美元/100 万个输出token;缓存音频和文本的价格均为 0.30 美元/100 万个 token。

并且,OpenAI 对实时 API进行了多项更新,包括直接 WebRTC 集成以及更好地控制响应。

首先,OpenAI 将为实时 API 引入 WebRTC支持。WebRTC 是一种开放标准,可以更轻松地跨平台构建和扩展实时语音产品,无论是基于浏览器的应用程序、移动客户端、IoT 设备还是服务器到服务器的直接设置。在 12 月初,OpenAI 聘请了 WebRTC 的创建者 Justin Uberti。

据介绍,WebRTC 集成专为在现实条件下实现流畅、灵敏的交互而设计,即使在网络质量不稳定的情况下也是如此,可以处理音频编码、流媒体、噪声抑制和拥塞控制。有了 WebRTC,现在只需几行 Javascript 就能添加实时功能。

此外,OpenAI 将向实时 API 提供以下功能,以便更轻松地提供卓越的语音驱动体验:

- 并发带外响应,可在不中断用户语音交互的情况下运行内容审核或分类等后台任务。

- 自定义输入上下文,用于指定将哪些对话项目作为模型输入。例如,只对用户的最后一句话进行审核检查,或在不永久改变会话状态的情况下重新使用过去的回复。

- 受控的响应时间,可在不自动触发响应的情况下使用服务器端语音活动检测(VAD)。例如,在手动启动语音回复之前,收集必要的数据(如账户详细信息)并将其添加到模型的上下文中,从而对时间和准确性进行更多控制。

- 增加最大会话时长,从 15 分钟增加到 30 分钟。

新的模型定制技术

今天,OpenAI还向有兴趣微调 AI 模型的开发人员推出一种称为“偏好微调”的新方法,以便根据用户和开发人员的偏好轻松定制模型。并且,方法将以与监督微调相同的价格提供,明年初还将支持OpenAI的最新模型。

这种方法使用直接偏好优化(DPO) 来比较成对的模型响应,让模型学会区分首选和非首选输出。通过成对比较而不是固定目标进行学习,偏好微调对语气、风格和创造性都很重要的主观任务尤为有效。

经过OpenAI的测试,到目前为止已经看到偏好微调方法取得的可喜效果。据悉,Rogo AI正在为金融分析师打造一款人工智能助手,可将复杂查询分解为子查询。他们使用专家构建的基准Rogo-Golden发现,虽然监督微调面临着分布外查询扩展的挑战,例如在查询 “X公司的增长速度有多快 ”时缺少ARR等指标,但偏好微调解决了这些问题,将基本模型的准确率从75%提高到80%以上。

最后,除了现有的 Python、Node.js 和 .NET 官方库(在新窗口中打开)之外,OpenAI 还将在测试版中推出 Go(在新窗口中打开)和 Java(在新窗口中打开)两个新的官方 SDK。“我们的目标是让 OpenAI API 易于使用,无论用户选择哪种编程语言。”

参考链接:

https://openai.com/index/o1-and-new-tools-for-developers/