IT之家 4 月 26 日消息,科技媒体 marktechpost 昨日(4 月 25 日)发布博文,报道称谷歌 DeepMind 团队推出 QuestBench 新基准,通过约束满足问题(CSPs)框架,评估模型在推理任务中识别和获取缺失信息的能力。

现实挑战与信息获取需求

大型语言模型(LLMs)在推理任务中广受关注,涵盖数学、逻辑、规划和编码等领域。然而,现实世界的应用场景常常充满不确定性。

用户在提出数学问题时常忽略重要细节,机器人等自主系统也必须在部分可观测的环境中工作。这种理想化完整信息设定与现实不完备问题之间的矛盾,迫使 LLMs 发展主动信息获取能力。

IT之家援引博文介绍,识别信息缺口并生成针对性地澄清问题,成为模型在模糊场景中提供准确解决方案的关键。

QuestBench:评估信息缺口的新框架

为应对信息获取挑战,研究者推出了 QuestBench 基准,专门评估 LLMs 在推理任务中识别缺失信息的能力。

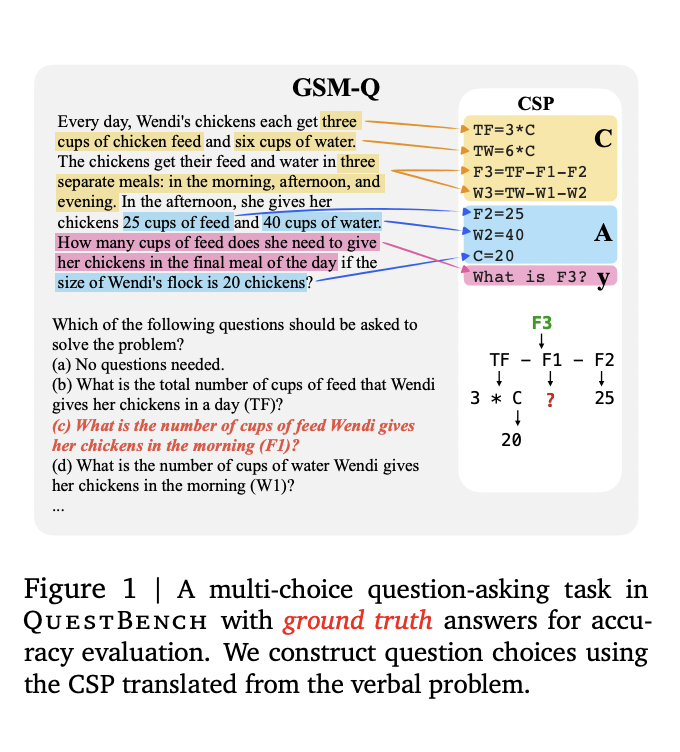

该基准将问题形式化为约束满足问题(CSPs),聚焦于“1-sufficient CSPs”,即只需知道一个未知变量值即可解决目标变量的问题。

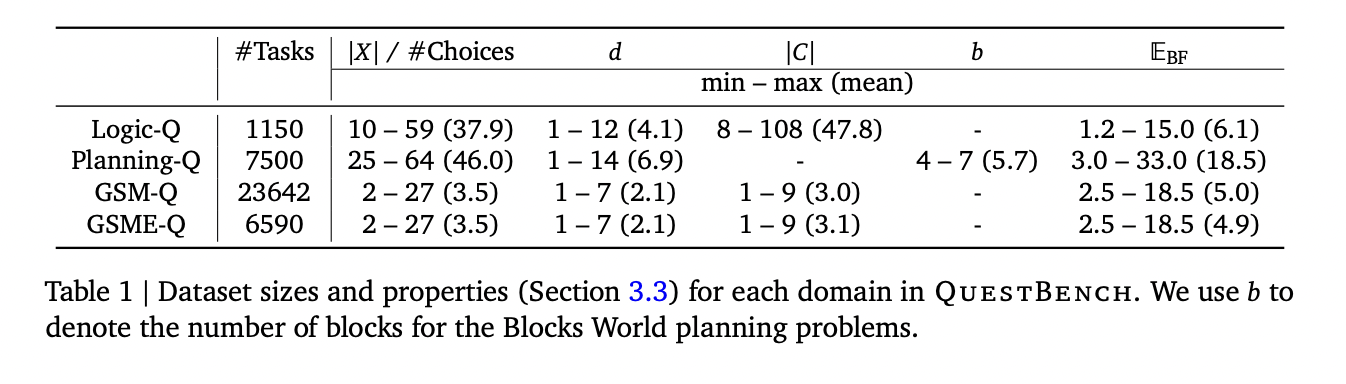

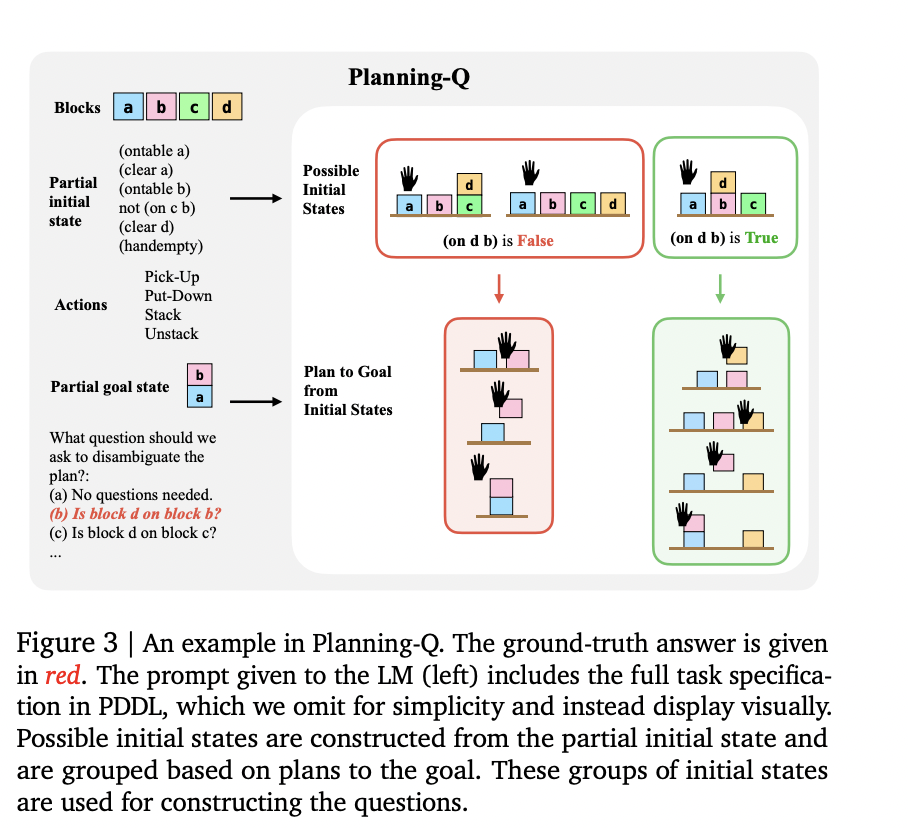

QuestBench 覆盖逻辑推理(Logic-Q)、规划(Planning-Q)和小学数学(GSM-Q / GSME-Q)三个领域,按变量数量、约束数量、搜索深度和暴力搜索所需猜测次数四个难度轴分类,精准揭示模型的推理策略和性能瓶颈。

模型性能与未来改进空间

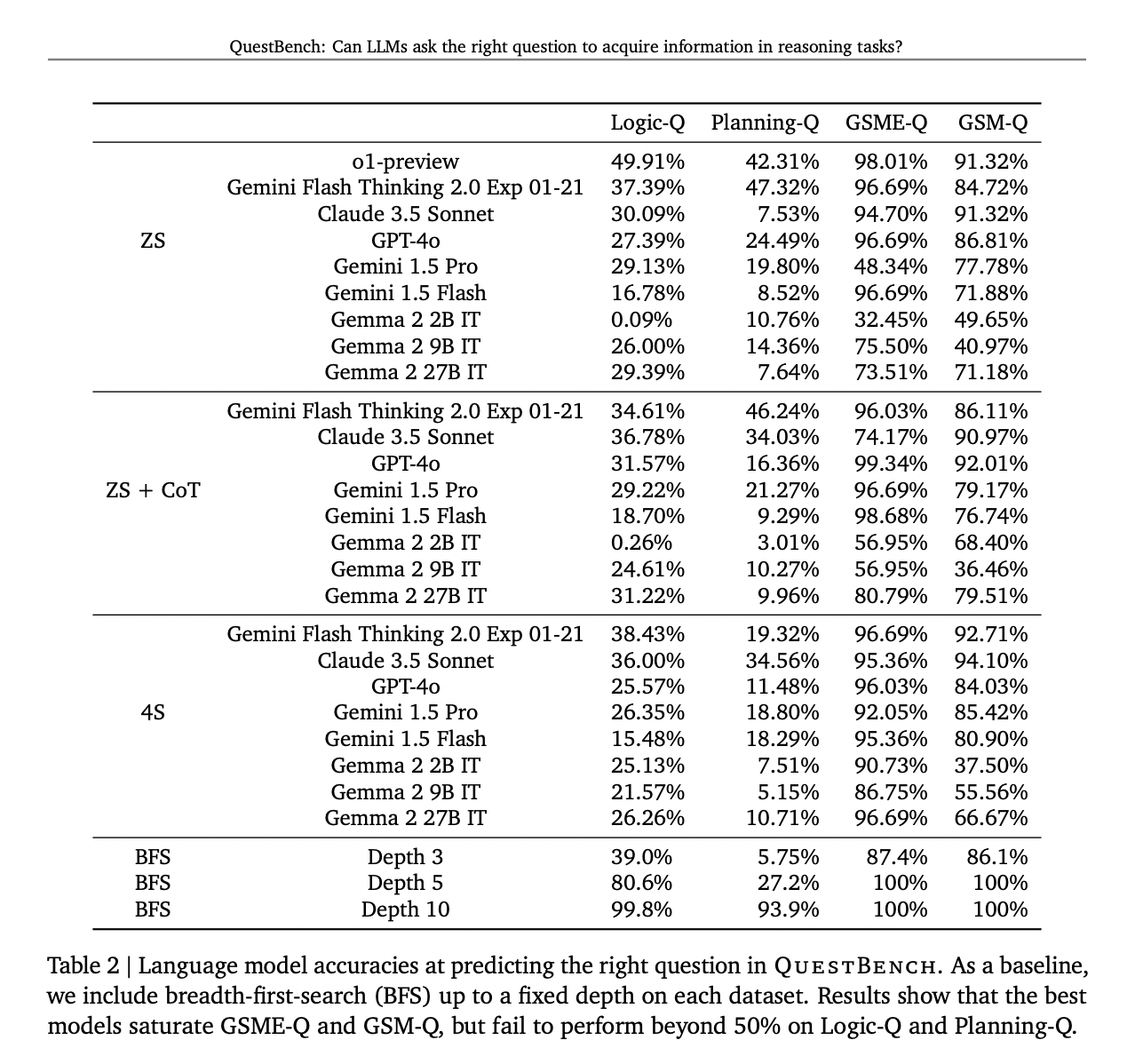

QuestBench 测试了包括 GPT-4o、Claude 3.5 Sonnet、Gemini 2.0 Flash Thinking Experimental 等领先模型,覆盖零样本、思维链和四样本设置。测试于 2024 年 6 月至 2025 年 3 月间进行,涉及 288 个 GSM-Q 和 151 个 GSME-Q 任务。

结果表明,思维链提示普遍提升了模型性能,而 Gemini 2.0 Flash Thinking Experimental 在规划任务中表现最佳。开源模型在逻辑推理上具竞争力,但在复杂数学问题上表现不佳。

研究指出,当前模型在简单代数问题上表现尚可,但随着问题复杂性增加,性能显著下降,凸显了在信息缺口识别和澄清能力上的改进空间。