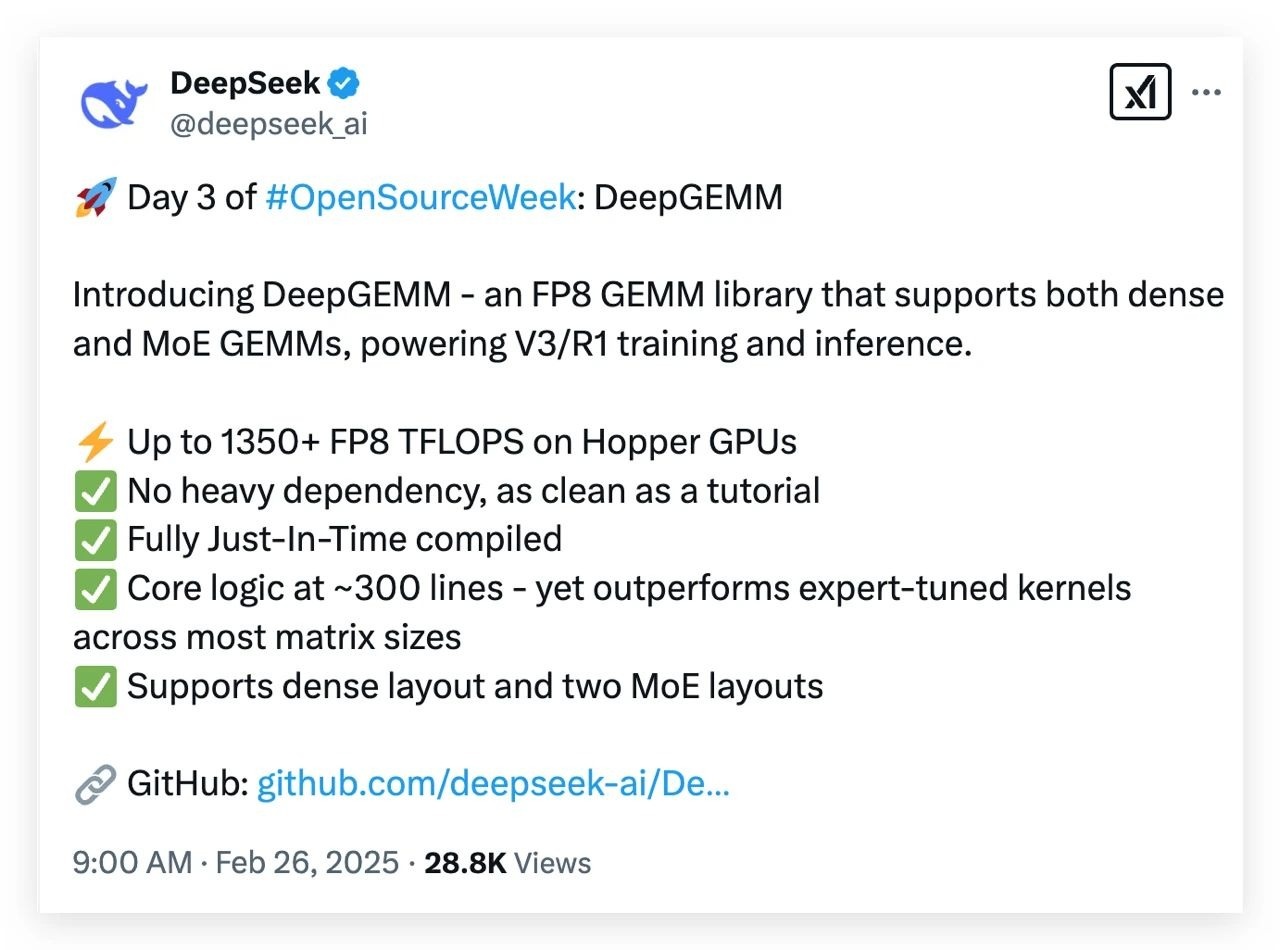

DeepSeek开源周迎来第三弹——高性能矩阵计算库DeepGEMM 正式开源!

这个被称为“AI数学加速器”的工具,专为提升大模型训练与推理速度而生,在Hopper架构GPU上实现FP8精度下1350+ TFLOPS的恐怖算力 ,代码极简却性能炸裂,堪称算力领域的“暴力美学”。

FP8精度,算力天花板再突破,采用8位浮点数(FP8)格式,相比传统32位浮点运算,如同用“小杯装水”替代“大桶储水”,牺牲微小精度换取 3倍以上速度提升 ,完美适配AI场景对误差的容忍性。

在Hopper GPU上实测1350+ TFLOPS (每秒1.35千万亿次浮点运算),远超市面主流显卡(如RTX 4090的400-500 TFLOPS)。

300行代码,性能碾压手工优化核心逻辑仅需300行代码 ,却通过全流程JIT编译优化 ,实现比手工调优算子更高效能,真正诠释“少即是多”。无额外依赖项,开箱即用,开发者可快速集成至现有框架。

双模式支持,适配全场景计算同时支持稠密矩阵布局 (全量数据统一计算,如全班做同一张试卷)和混合MoE布局 (分任务处理,如数学题给专家A、语文题给专家B),灵活应对不同模型需求。

FP8的“省电模式” :低精度计算大幅降低显存占用和功耗,让万亿参数大模型在24G显存单卡上也能跑出28倍推理加速 (参考KTransformers项目)。

MoE杀手级优化 :通过连续/掩码双布局 ,解决专家模型计算中的通信瓶颈,让万亿参数MoE推理“快如闪电”。极简代码哲学 :摒弃冗余设计,专注底层优化,重新定义高性能计算边界。

随着DeepGEMM的开源,DeepSeek R2模型(预计5月发布)的算力瓶颈将进一步突破。未来,从训练到推理,从单卡到分布式,DeepSeek正构建一套全栈开源Infra体系 ,让AI创新不再受制于算力成本。

根据知情人士消息,DeepSeek 正在加速推出 1 月发布的 R1 模型升级版 — DeepSeek R2。其中两位知情人士表示,DeepSeek 原计划在 5 月初发布 R2,具体时间尚未透露。

同时DeepSeek 今天也重新开放了 API 充值入口,此前因资源紧张,其曾一度关闭充值入口。目前 deepseek-chat 模型优惠期结束,调用价格已变更为每百万输入 tokens 2 元,每百万输出 tokens 8 元。