“公开的高质量数据即将用尽了吗?如何未雨绸缪”“不同具身智能技术路线的能力边界在哪里”“我们需要什么样的AI4S基座模型”“当前大模型是否遭遇瓶颈”……12月13日~14日,数十个人工智能领域最前沿的关键话题出现在浦江西岸,在由上海人工智能实验室发起并主办的首届“浦江AI学术年会”上,全球150余名人工智能领域专家学者就这些话题进行了深入研讨。

两年前,ChatGPT横空出世,掀起一场超强的“AI旋风”;最近,OpenAI用连续12天的发布会再次让全球进入“AI狂欢”。但不同于两年前的震惊、兴奋与困惑,今天的学界和产业界对于AGI路线有了更多的“中国思考”。

定义“智能”,什么是“智能”?

尽管人工智能这个词来源于1956年著名的达特茅斯会议,但会议的发起人麦卡锡却并不喜欢这个名字,“毕竟,我们的目标是‘真正的’智能,而非‘人工的’智能。”

2022年底,ChatGPT的出现惊艳了世人,也被认为出现了智能“涌现”,但香港大学计算与数据科学学院院长马毅对此并不认同,他认为,GPT有的只是知识,而不是智能,“智能系统一定是具有自我纠正和自我完善现有知识体制的系统”。

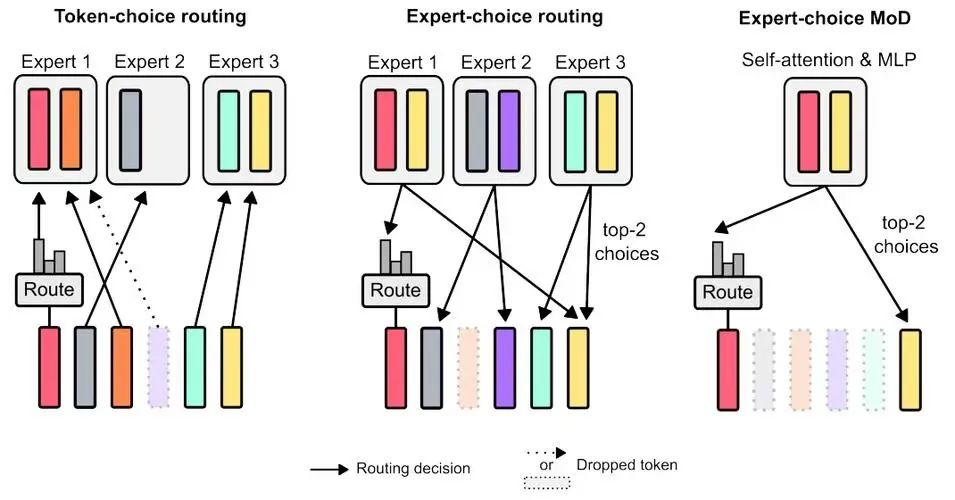

马毅最近几年一直致力于研究“白盒大模型”,“白盒”概念对应的正是基于深度学习模型的“AI黑盒说”——尽管大模型给出了令人满意的结果,但人们对其决策过程却并不了解,甚至输出结果很难预测和控制,也即出现所谓的“幻觉”。

马毅认为,现有的深度学习模型,例如 Transformer(主流大语言模型架构),本质上是“减墒”,从高维的图像、声音、语言等信号里,不断压缩、去噪,然后找到核心规律、低维结构,而白盒就是要清晰解释这个压缩过程。

Transformer

简单理解,与ChatGPT的“暴力出奇迹”不同,“白盒”反其道而行之,试图先搭建一个可解释的框架,然后在这个框架下设计出能被解释的网络和模型。由于知之而为之,大大减少了Transformer架构的试错成本,从而从根本上解决当前遇到的“数据墙”和“算力墙”问题。

稀宇科技创始人闫俊杰则认为,智能的定义可以非常广泛,黑盒模型在某些应用中足够,但白盒模型在理解人类的智能上可能有优势。尽管当前的模型和产品已取得一定进展,但未来将会有更多创新出现,不同研究机构和企业将提出各自对智能的理解,并在特定领域内超越现有水平。

新解“Scaling Law”

论坛现场,马毅的观点迅速成为学者们热议的焦点,而在“什么是智能”的问题背后,隐藏着的另一个提问是,“Scaling Law(尺度定律)还能走多久?”

大洋彼岸,几乎同时举行的另一场学术重磅会议——NeurIPS 2024上,OpenAI的前首席科学家Ilya Sutskever语出惊人,“预训练时代即将终结(Pre-training as we know it will end)”,理由是作为AI发展燃料的数据即将枯竭,依赖海量数据的预训练模型将难以为继。

数据枯竭、算力昂贵、效果下降……最近半年,Scaling Law“撞墙”的反思频繁出现在学术界和工业界。闫俊杰指出,当前全球有效数据被清洗后大概只有20万亿Token。

同时,要想和人脑实现同样功能的计算量是巨大的,图灵奖得主杨立昆在其新书《科学之路》中指出,为了达到人脑的计算能力,必须将10万个GPU连接上功耗至少25兆瓦的巨型计算机才能实现,能量消耗是人脑的 100 万倍,因此深度学习的能力十分强大却又十分有限。

图源:pixabay

“根据我们的观察,随着大模型规模的不断扩大,归纳相关的能力快速提升,而且可能会继续遵循Scaling Law,但其演绎能力,包括数学和推理方面的能力,随着模型Side进一步提升,不仅没有增长,反而在下降。”会议间隙,阶跃星辰首席科学家张祥雨告诉《IT时报》记者,他对万亿以上参数大模型的能力提升,并不绝对乐观。

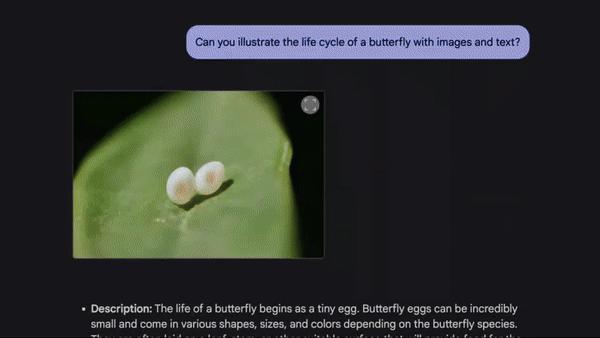

包括OpenAI在内的全球顶尖AI公司和科学家们都在“另辟蹊径”。北京时间12 月 6 日凌晨2点钟,OpenAI 宣布推出满血版o1和o1 pro mode,紧接着,谷歌祭出最强下一代新模型Gemini 2.0 Flash,第一时间都“尝鲜”之后,张祥雨对两个大模型的创新颇为赞赏,不过,虽然“视觉和推理都有很大突破,但离真正的AGI仍有很长的路要走,未来需要更智能的目标导向和试错机制”。

Gemini 2.0 Flash

大会圆桌论坛阶段,上海人工智能实验室主任助理、领军科学家乔宇同样表示,在通往AGI的路线上仍需要突破3~4个关键挑战,目前,大模型并不具备人类的推理、情感、伦理等战略性思考能力,“并不是说Scaling Law要被抛弃了,而是应该寻找新的Scaling Law维度,很多难题并不能单纯靠扩大模型规模、数据、算力解决,我们需要更丰富的模型架构和更高效的学习方法,同时也希望在AGI发展过程中,能有来自中国的核心贡献,找到与中国资源禀赋更加匹配的、自主的技术路线”。

面向2025的“中国思考”

那么,面对即将到来的2025年,当OpenAI、谷歌扔出一个又一个“王炸”时,中国科学家们将在哪些领域携手突破呢?

经历了两年的“狂飙”之后,大模型的发展目标逐渐出现分化:一部分人求解高难度的科学问题,在数学、物理等尖端问题上探索大模型的上限;另一部分人则更关注大模型的落地和稳定性,期待提高模型的下限。

上个月,上海人工智能实验室按照通专融合AGI路径,在第一阶段构建并发布了强推理模型书生InternThinker,它解决问题的路径更接近人类学习方式的路径,面对复杂的推理任务时,并非从海量的样本中学习单点知识,而是学习人类的思维模式——先回忆所需知识,再逐步推理和计算,最终给出准确解答,如果某条推理路径失败,它能够快速调整思路,尝试新的解决方案,体现出独特的深度推理与专业泛化能力的结合。

通过这种方法,InternThinker在“24点”等高难度数学题以及编程题的解决中展现了卓越的能力,不仅完成了解答,还进行了系统的自我检查与反思,确保结果的准确无误。

“如果说,通用大模型已经具备了高中知识,那专用大模型就是在此基础上再学习大学的专业知识,未来希望能够将大学的知识慢慢融入高中教学中,”上海人工智能实验室领军科学家欧阳万里表示,实验室正在进一步探索通专融合的技术路线。

乔宇则希望,新的一年中,多模态大模型的涌现能力能够像语言大模型一样取得重要的突破,上海人工智能实验室最近发布的书生万象2.5已经在多模态思想链(Chain-of-Thought CoT)上取得突破,成为首个MMMU测试(一个大规模多学科多模态理解和推理基准测试)突破70%的开源多模态大模型。

张祥雨同样希望多模态大模型实现理解和生成一体化,可以直接在视觉空间里理解并完成视觉推理,通过新范式的加持,让Scaling Law重新与智能程度的发展正相关。

清华NLP实验室刘知远教授团队则提出了大模型的密度定律(densing law):自2023年以来,模型能力密度随时间呈指数级增长,约每100天翻一倍,这意味着,当前训练出的一个模型,100天后,只需一半的参数就可以实现相同的能力。

基于此规律,一年后,一个58B参数规模的大模型就可以复现750B参数大模型一样的效果。同时,随着芯片电路密度(摩尔定律)和模型能力密度(密度定律)持续增强,意味着主流终端如PC、手机将能运行更高能力密度的模型。

“我们大胆预测,只要是这个世界上能够训练出的模型,未来一定会在某个时刻跑在终端上,这也揭示了端侧智能巨大的潜力。”刘知远认为,未来应该不只是追求规模更大的模型,而应该追求更高的模型制造工艺,寻找更加陡峭的成长曲线,从而让大模型可以实现高质量可持续的发展。

“和100多年前的物理界一样,当前的人工智能领域头顶也有两朵乌云:一朵是下一代智能系统一定是有自主连续增量学习的系统,更接近于人类的个体智能;另一朵是必须取代DP(动态规划)路线,自主学习必须是局部的、高效的,当前(大模型得出同样结果)的能耗比自然界高出8~9个数量级。”马毅希望,参会的年轻科学家们能“吹散”这两朵乌云。

万事之始仍是“人才”

事实上,上海人工智能实验室举办“浦江AI学术年会”的初衷,正是希望以年会为载体,推动“以问题为导向”的学术讨论深入开展,通过高质量问题激发更多创新灵感,“互相出好题、互相协同”,在更高层面实现产业合作、协同创新。

本次大会主席、上海人工智能实验室主任、首席科学家周伯文认为,当前大家都在关注“Scaling Law”,但接下来“Scaling What”(什么规模化)?除了业界关注的算力、数据和最近的推理时间,他认为提升研究者的“Scale”同样重要,“1911年,首篇关于原子结构的论文只有三个人署名,但现在欧洲核子研究中心每次新发现都有数百甚至上千名科学家协作,如何能够创造性地发挥团队本身的创造力,同时又能更好地完成团队间的协作,实现更高层面的Scale,我认为这是Scaling Law下一阶段需要研究的问题。”

令人欣喜的是,本次大会的另一位主席、清华大学交叉信息研究院及人工智能学院院长、上海期智研究院院长姚期智发现,中国人工智能高端人才培养已经进入转折点,国内大学培养出的博士,其创新成就和工作成果已可与国际顶尖实验室“比肩”,这意味着指导这些博士生科研团队跟师资到达世界最高水平,下一步,他期待国内各个高校、科研机构进一步加大对年轻科研人员(博士后阶段)的培养力度,让他们能尽快在人工智能科学道路上独当一面。