新智元报道

编辑:编辑部 HYZ

【新智元导读】OpenAI下一代模型——o3,重磅诞生了!陶哲轩预言难住AI好几年的数学测试,它瞬间破解,编程水平位于全球前200,在ARC-AGI基准中更是惊人,打破所有AI纪录接近人类水平,离AGI更近一步。

12天最后一天,OpenAI下一代推理模型o3真的出世了!

奥特曼、Mark Chen、任泓宇和ARC Prize基金会主席Greg Kamradt为我们做了介绍

正如所爆料那样,突如其来的o3成为整场直播的「压轴菜」。

奥特曼表示,之所以跳过o2,是因为对伙伴的尊重,以及延续OpenAI一贯「起名特别差」的传统。

奥特曼的谜底也终于揭晓了——3个o

要知道,距离9月o1的出世,才过去了整整3个月的时间。o3的迭代速度,证明了Scaling Law似乎并未终结。

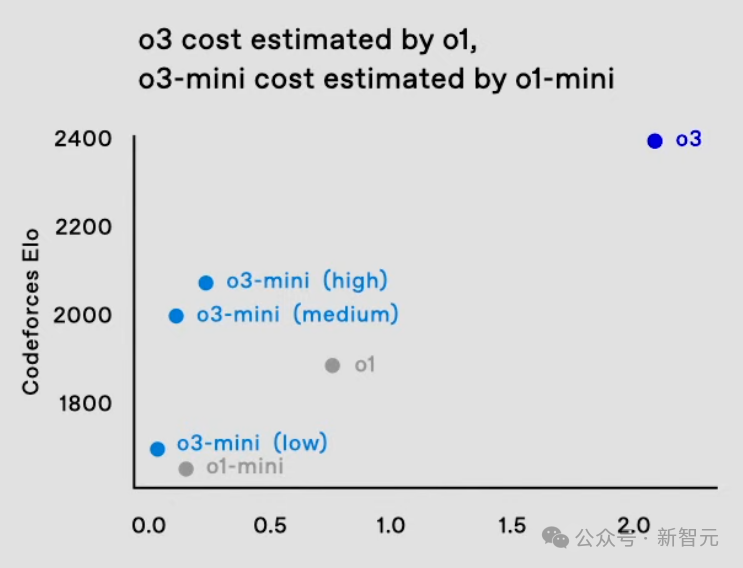

根据Keras之父发布的报告称,o3在低计算量模式下,每个任务需要花费高达20美金,而在高计算量模式中每个任务则需要数千美元。

o3数学代码封神,粉碎o1

在多项基准测试中,o3再次刷新SOTA,就数学、代码、软件工程等领域,完全粉碎了满血版o1!

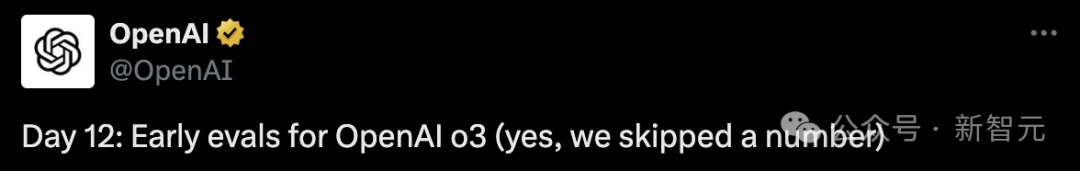

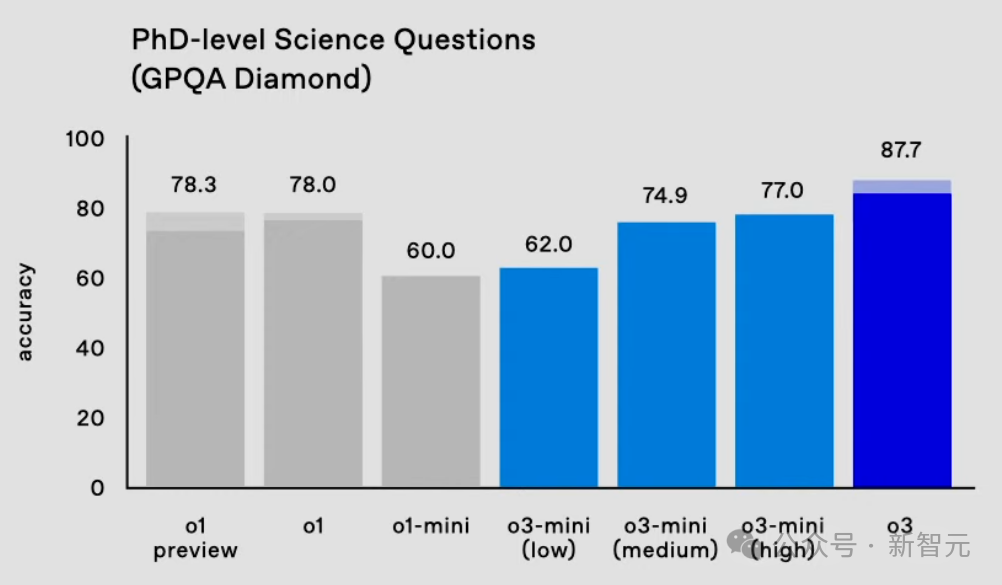

在AIME 2024数学竞赛评测中,o3取得了96.7%的准确率,性能直接飙升13.4%;在博士级科学问答基准GPQA Diamond上,o3准确率为87.7%,相较于上一代o1提升9.7%。

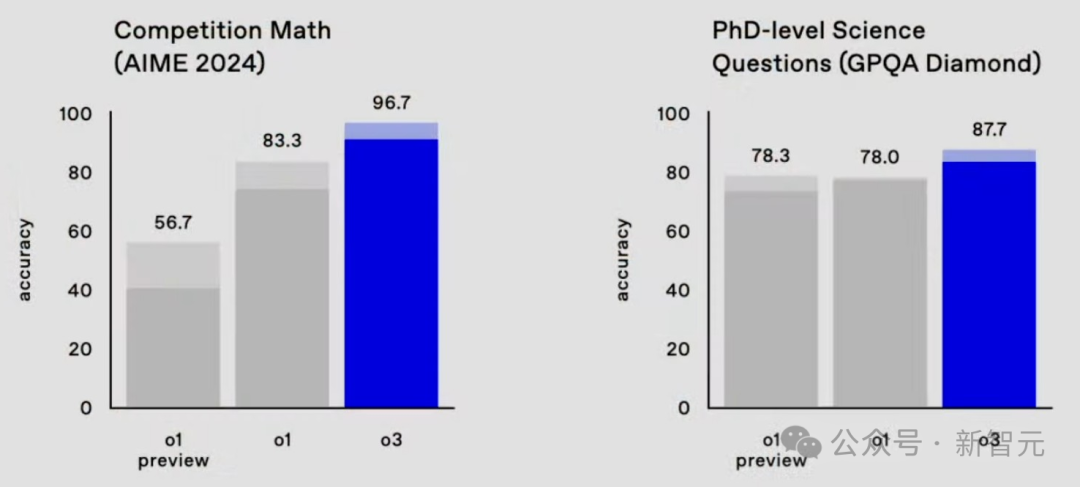

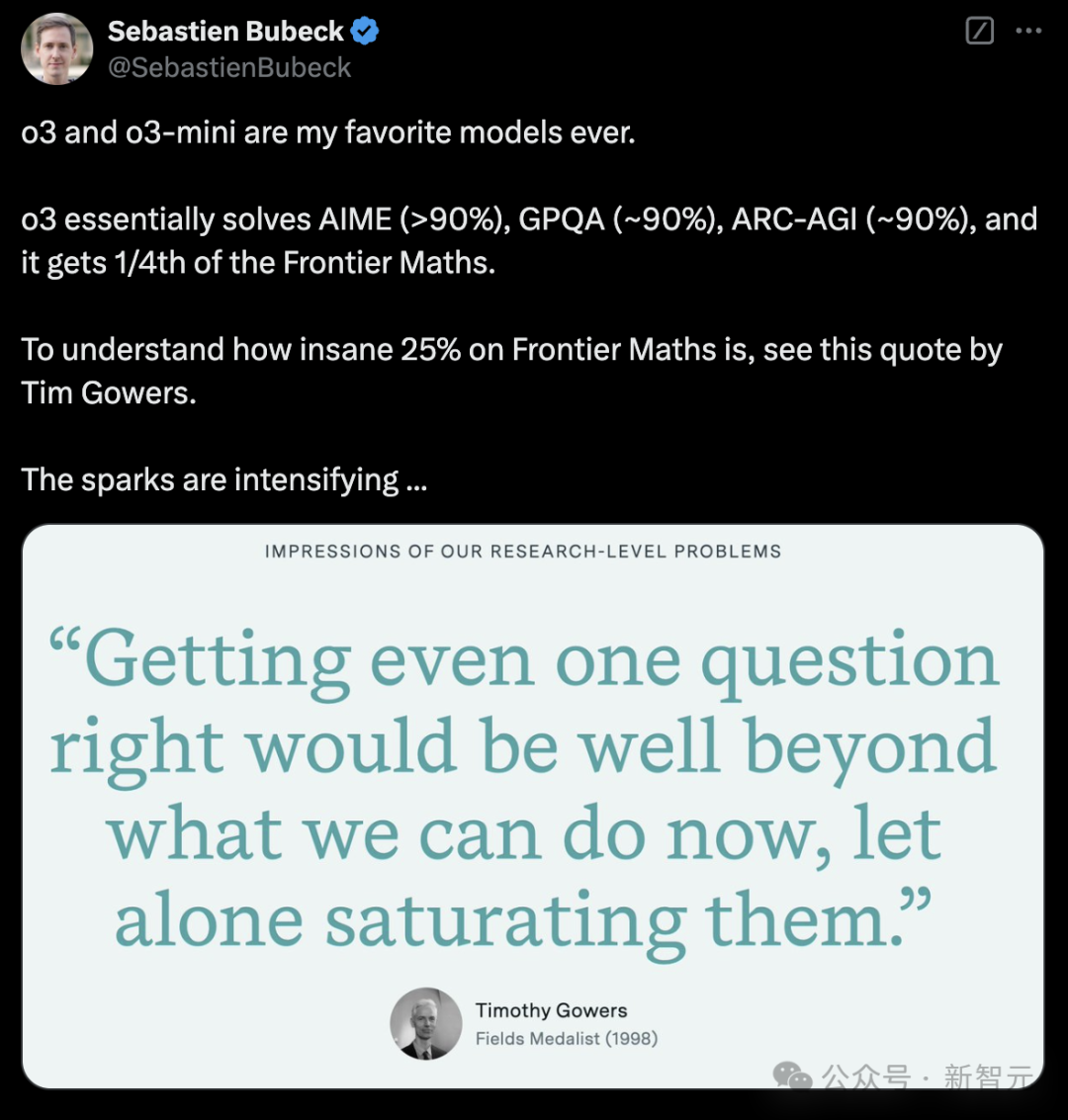

在今年11月Epoch AI发布的数学基准Frontier Math上,o3准确率高达25.2%。

这个基准中,今天所有模型的准确率都低于2%,但是在激进的测试时间设置下,o3已经能够达到25%的准确率。

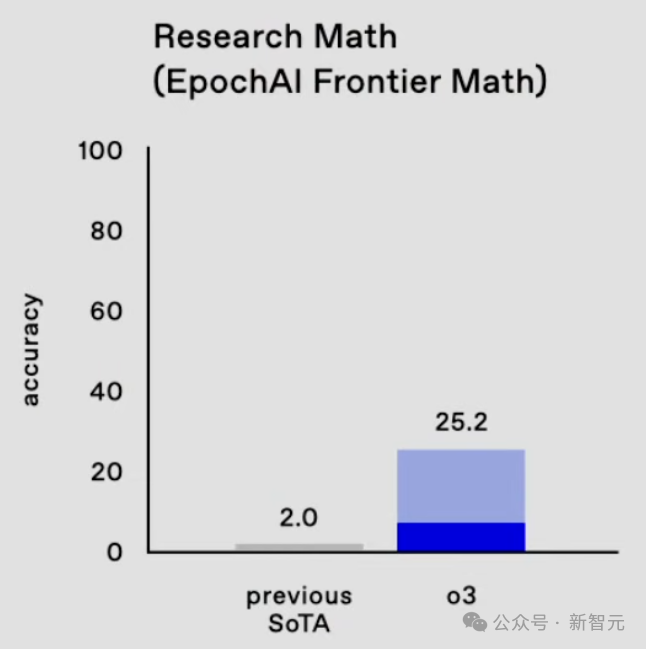

要知道,联手60多位数学家出题的陶哲轩,曾认为这项测试能够难住AI好多年。

如今,这一说法又被OpenAI o3推翻了。

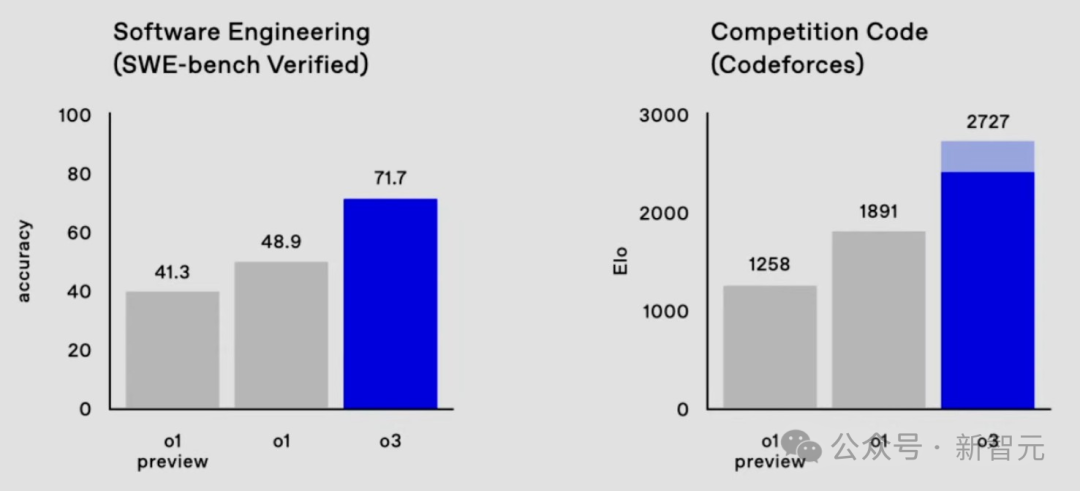

在软件工程SWE-bench Verified基准上,o3的代码性能从o1的48.9%狂飙22.8%,达到了71.7%。

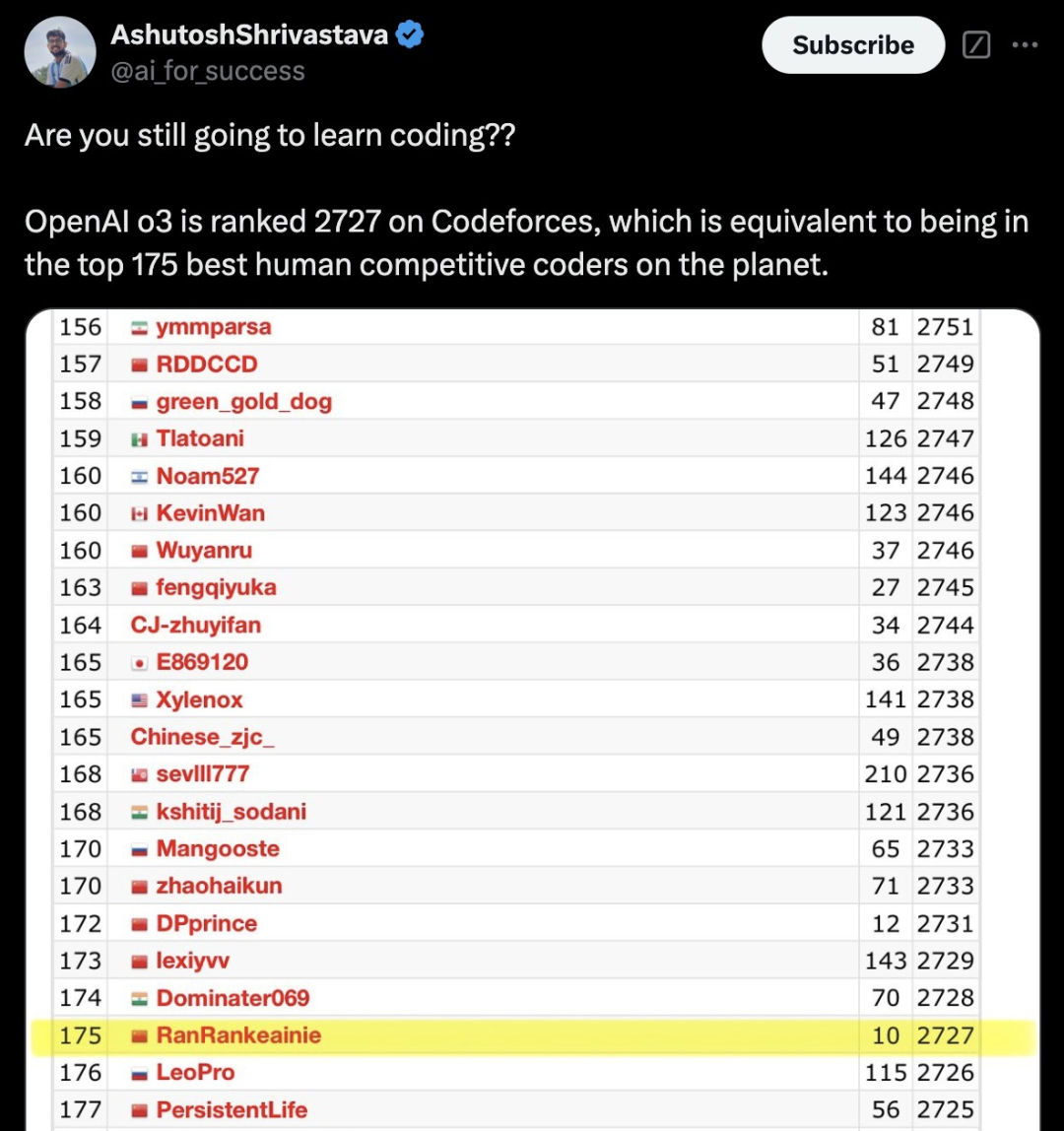

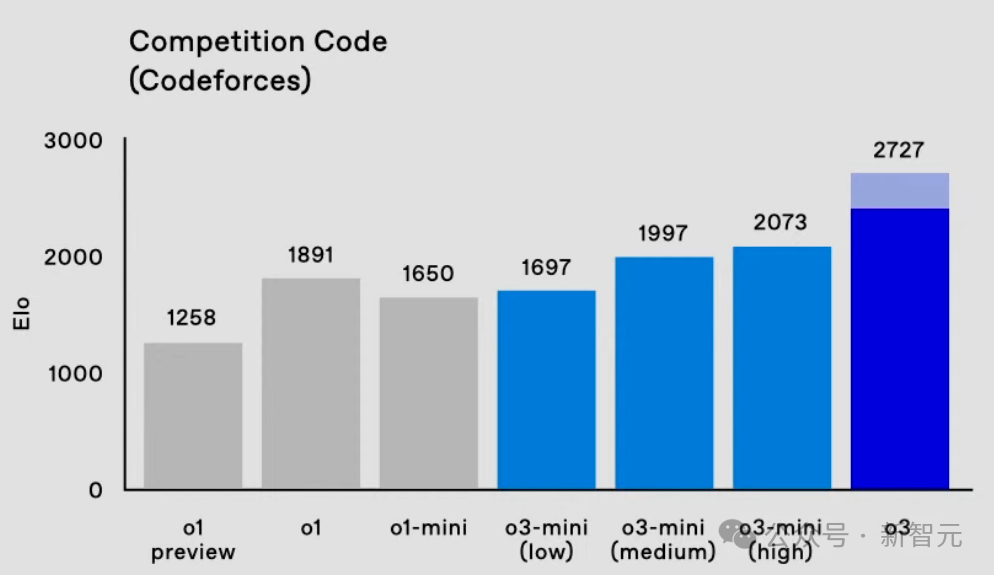

在Codeforces中,o3的Elo得分为2727,相较o1提升了800多分。

这个表现,已经达到了International Grandmaster的水平,相当于位列175名的人类选手。

甚至,超过了OpenAI的研究高级副总裁。

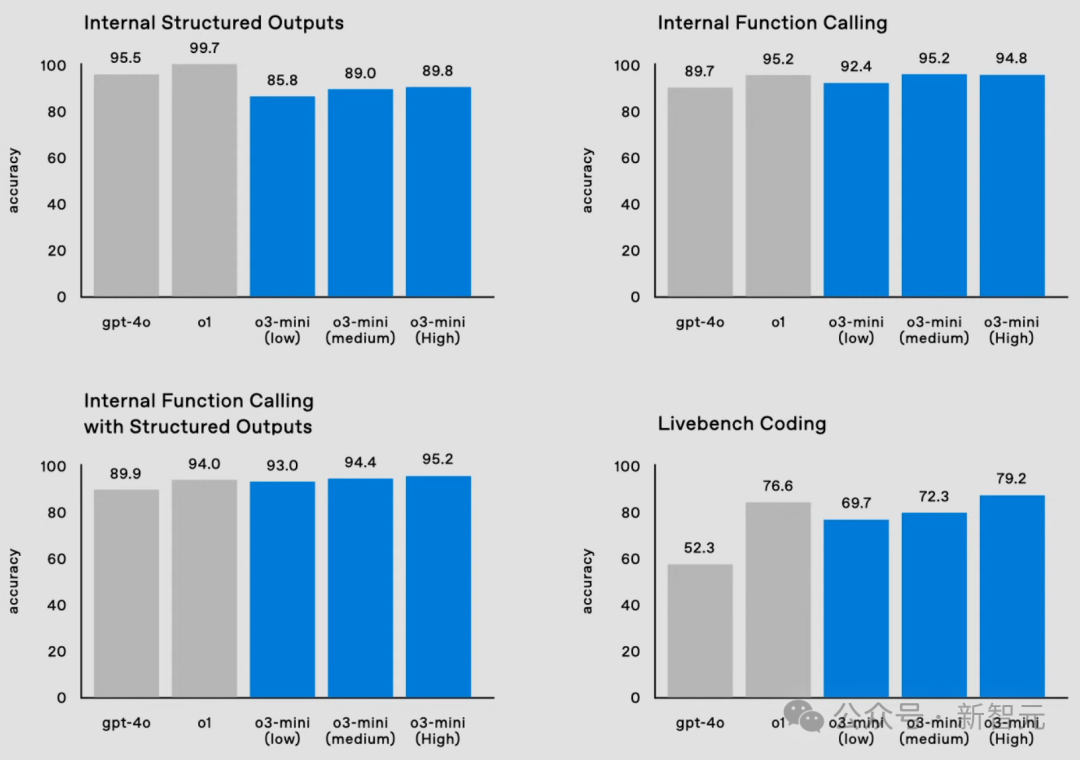

除o3之外,o3-mini同样在数学、编码、博士级科学问答、函数调用等基准上,取得了新的突破。

它真正定义了一种新的成本效益推理前沿。

奥特曼表示,这两款新模型将面向研究人员测试,并期待未来尽快推出上线。

OpenAI研究科学家Sebastien Bubeck称,o3在Frontier Maths取得25%准确率,在菲尔兹奖得主Tim Gowers看来极其惊人。这暗示了AI发展火花加速迸发。

网友纷纷表示,就在今天,我们已经实现了AGI!

o3-mini:三种「思考模式」,计算越多能力越强

o3-mini作为o3系列的新成员,与o1-mini一样,将为开发者带来高性价比的AI体验。

在编程能力评测中,o3-mini展现出惊人的实力。

通过「自适应思考时间」(adaptive thinking time)机制,o3能够根据任务难度自动调整推理深度。

由此,它才实现了在代码生成方面超越了前代o1。更令人惊叹的是,其运行速度和成本仅为o1的1/10。

o3-mini引入了三档思考级别——低强度推理、中等强度推理、高强度推理,可以根据具体需求去调整模型的推理深度。

简言之,简单任务能够得到快速响应。而复杂的问题,模型则可开启更深度的思考模式。

任泓宇(左)本科毕业于北大,后在斯坦福获得博士学位,负责o3-mini的训练

具体来说,在Codeforces测试中,o3-mini的Elo评分随着思考时间的增加,性能逐步的到提升。

甚至,在中等强度思下,o3-mini(medium)已经超了满血版o1的表现。

虽然o3-mini(high)在高强度思考下,仍落后于o3,但几乎差别不大。

而且,在成本和思考速度方面,o3-mini取得了超越o1-mini更好的性能。

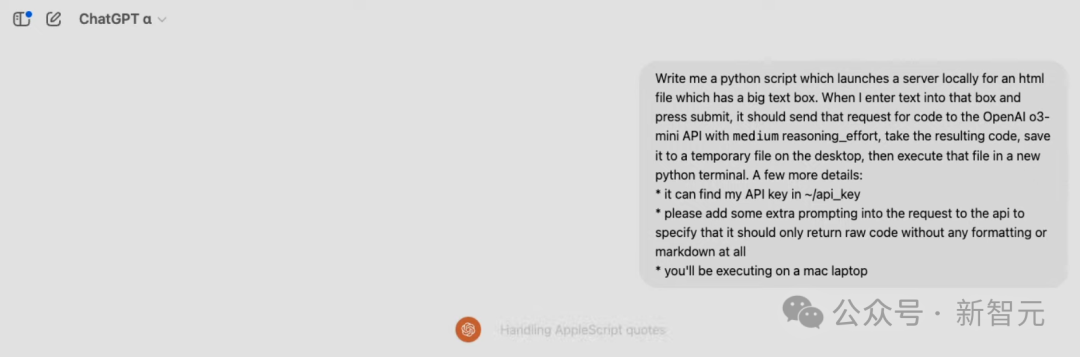

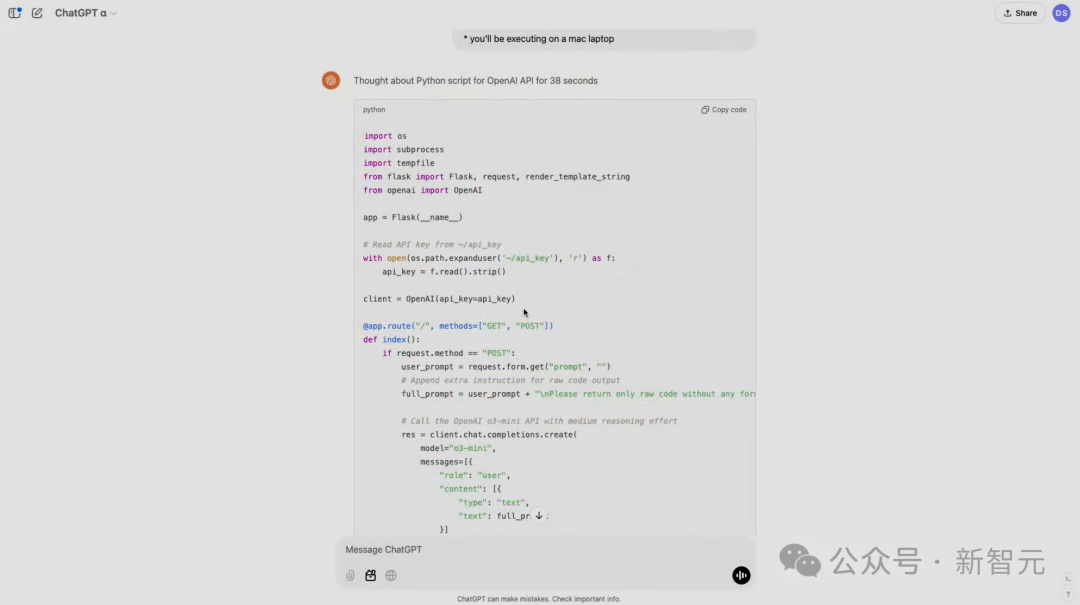

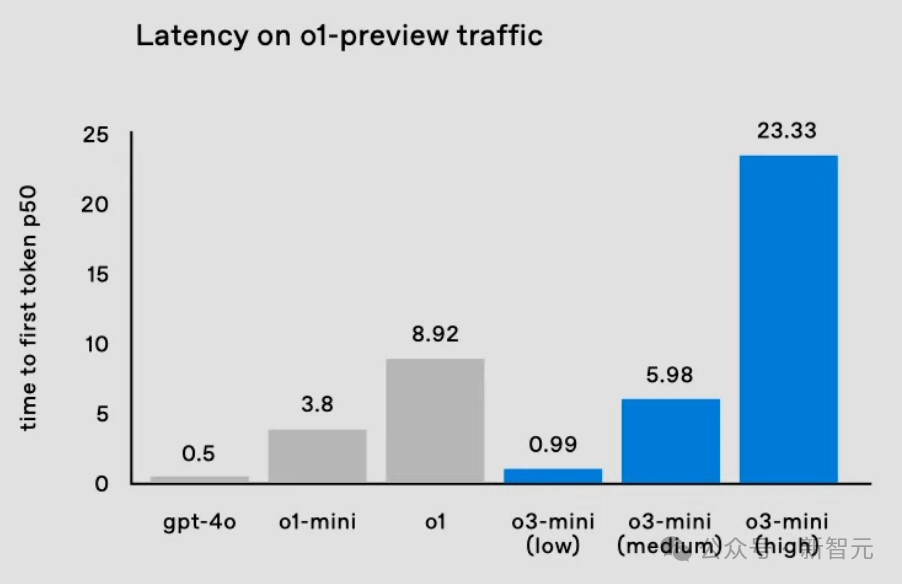

在演示中,研究者要求模型使用Python实现代码生成器和执行器。

启动之后,就像运行Python脚本一样,模型将在本地启动一个服务器,带有一个包含文本框的UI。

然后我们就可以在其中发出编码请求了,它会请求调用o3-mini API,它将解决任务,返回一段代码。

代码会保存在本地桌面上,然后打开终端自动执行代码。

以下,就是模型生成的代码,用时仅38秒。

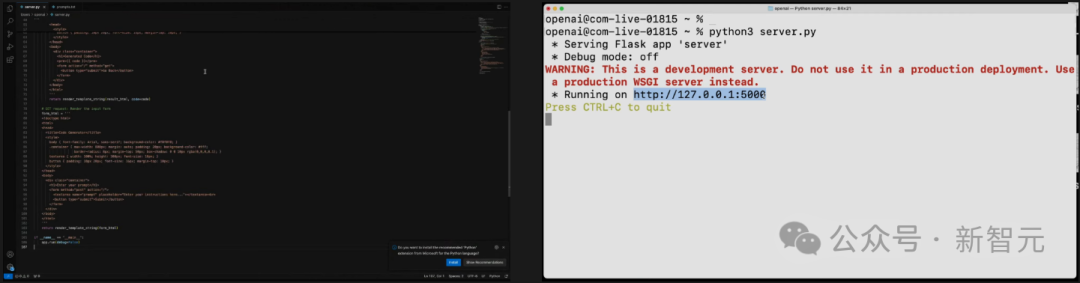

把代码复制粘贴到服务器上,并运行。

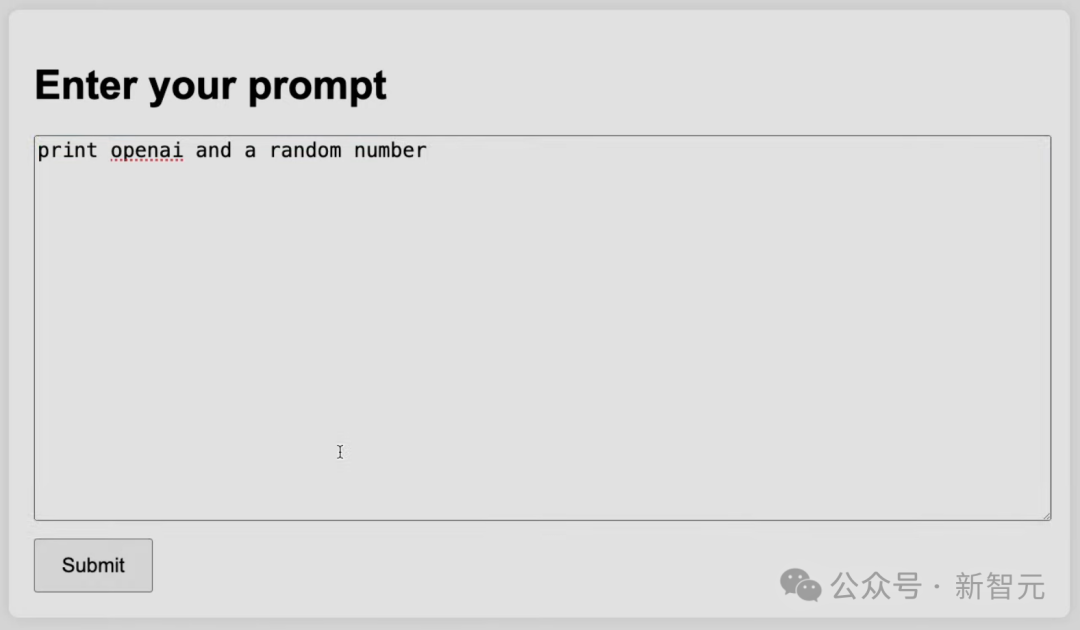

然后,便可获得对应的UI界面——一个文本框。

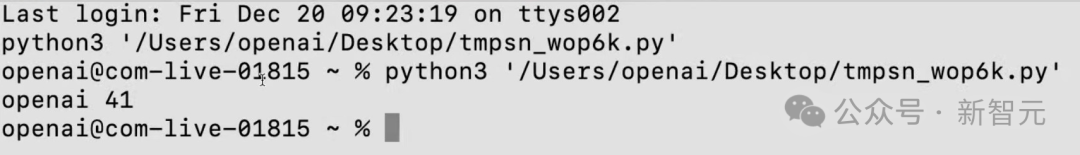

我们可以在其中输入代码,比如打出OpenAI和一个随机数,它就会将请求发送到o3-mini(medium)。

模型果然按要求输出OpenAI,以及41这个数字。

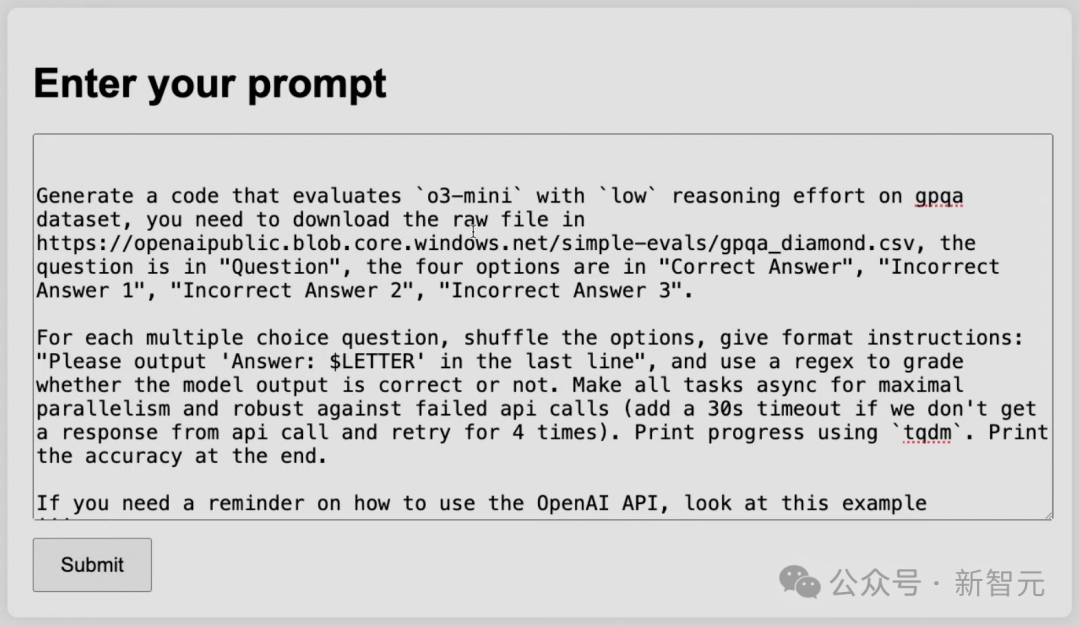

在下面这个任务中,研究者要求模型用较低的推理能力,来评估o3-mini在难度很高的GPQA数据集上的表现。

模型首先需要从该URL下载原始文件,然后需要识别哪些部分是问题,哪些是答案,哪些是选项。最后,模型需要整理出所有的问题,并尝试作答,解析结果,最后进行评分。

模型的运行速度极快,因为它调用的是o3-mini,并使用了较低的推理计算。

可以看到,结果为61.62%,和正式评估几乎一模一样。

而且这个运行极快的低推理能力模型,整个评估过程只用了一分钟。

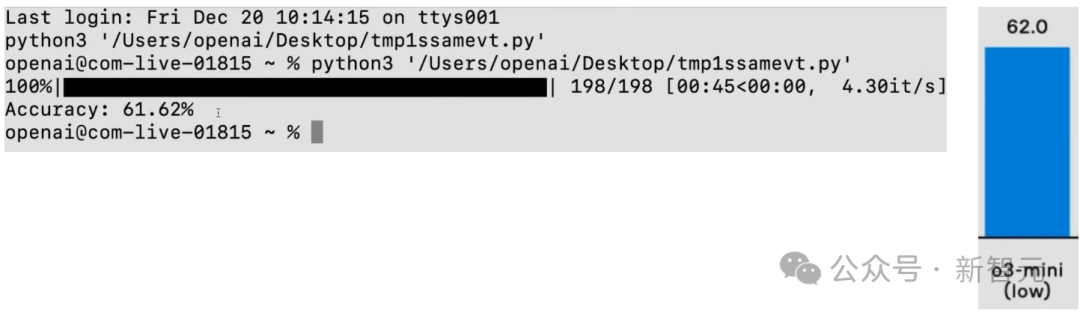

除了代码成绩亮眼,o3-mini也展现出了卓越的数学能力。

在AIME 2024数学竞赛测试中,o3-mini(low)已经接近o1 mini的水平。

o3-mini(medium)以78.2%的准确率超越了o1(图中实心部分),而o3-mini(high)进一步提升了性能。

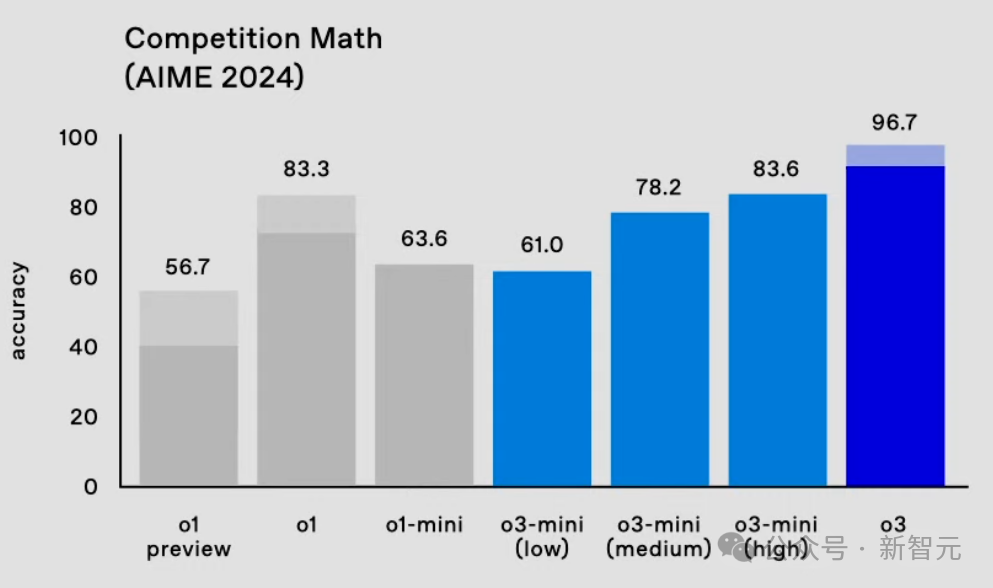

在延迟方面表现,o3-mini(low)大幅降低了延迟,降低至1秒内,媲美GPT-4的即时响应。

o3-mini(medium)的延迟比o1-mini快一半。

当然,OpenAI为了满足开发者的需求,o3-mini提供了全套API功能,包括函数调用、结构化输出、开发者消息。

更难能可贵的是,在这些功能上,o3-mini的性能不仅完全对标o1,并在多数评测中取得了更好的表现。

另外,在具有挑战性的GPQA数据集测试中,o3-mini展现出稳定的性能,即便是在低强度思考模式下,o3-mini(low)也达到了62%的准确率。

o3-mini暂时只向安全研究院开放测试,可以直接在OpenAI网站中进行申请。

ARC-AGI基准

ARC Prize Foundation是一家非营利组织,使命是在基准测试期间成为AGI的北极星。

他们的第一个基准ARC-AGI,是由Keras之父François Chollet于2019年在关于智力测量的论文中发表的,它在AI领域已经保持5年不败。

击败ARC-AGI的系统,将成为迈向AGI的重要里程碑。

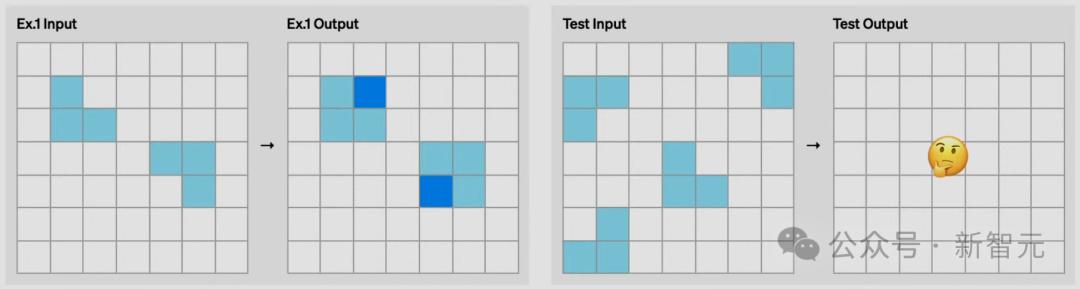

它的全部内容,都是输入示例和输出示例,目标是了解变换的规则,猜出输出的示例。

而它的每项任务,都需要不同的技能。

比如下面这个任务,凭人类直觉,很容易猜出最后一张图应该是什么,但AI很难理解。

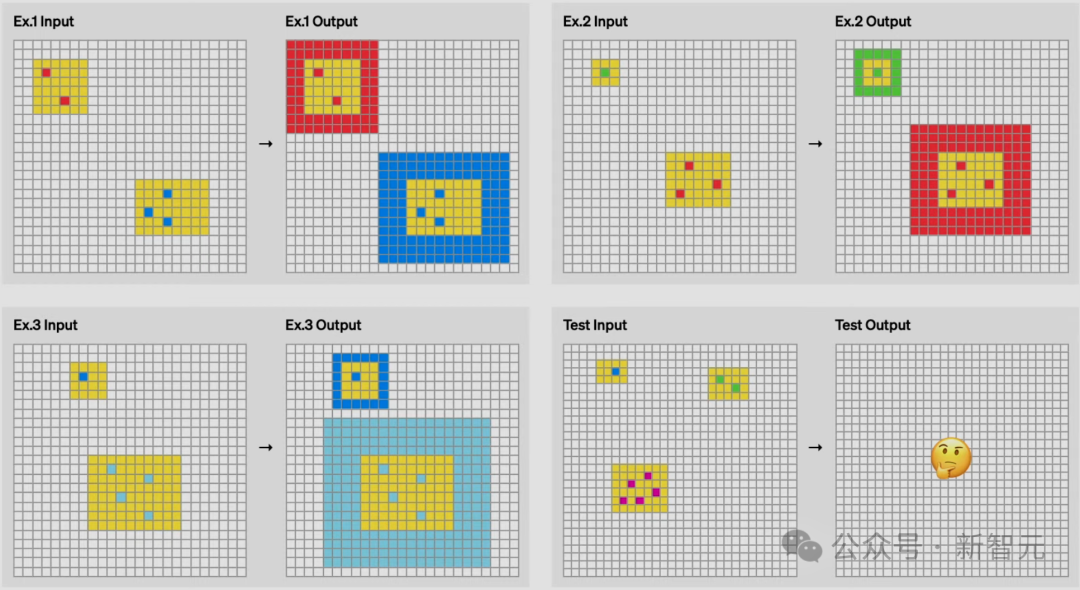

在这个任务中,则是需要在黄色方块中,数一下共有多少种颜色的方块,然后用它创建一个边框。

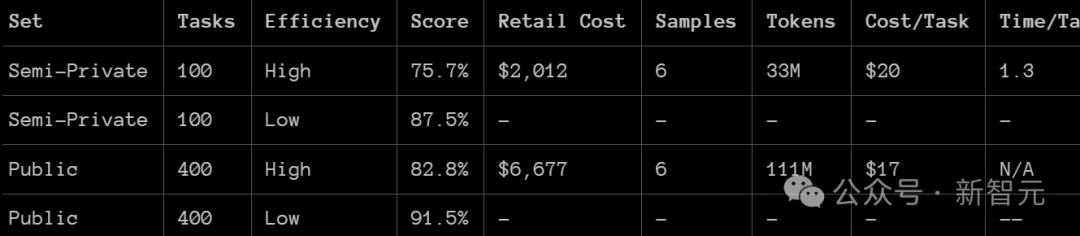

研究者使用了两个ARC-AGI 数据集对 o3 进行了测试:

半私有评估:100个私有任务,用于评估过拟合

公共评估:400个公共任务

他们在两种计算水平下进行了测试,样本规模分别为6(高效模式)和1024(低效模式,计算量是高效模式的172倍)。

厉害的是,在这个基准测试中,o3在低计算模式下,在半私有评估中的得分为75.7%;在高计算模式下,得分为87.5%。

具体来说,高计算模式下的得分为 75.7%,符合 RC-AGI-Pub的预算限制(成本低于1万美元),因此在公共排行榜上排名第一。

低计算模式下的得分为 87.5%,虽然成本较高,但仍然表明在新任务上的性能随着计算量的增加而提升。

这点尤为重要,因为人类在该任务上的表现通常在85%的水平。

超过这一数字,就意味着达到了一个重要的里程碑,因为此前从未有任何AI系统实现过这一成就。这标志着ARC-AGI领域的一个全新突破。

ARC Prize Foundation的主席表示,看到这些分数时,他意识到需要稍微改变一下自己的世界观,修正对AI究竟能做哪些事情的直觉。

而且要知道,目前还仅是AI的早期阶段,所以我们就更需要ARC-AGI这样的持久性基准测试,来对进展进行评估和引导了。

OpenAI o3,还不是AGI

总之,这是AI能力的一次令人惊讶且意义重大的跃升,展现了GPT系列模型前所未有的新任务适应能力。

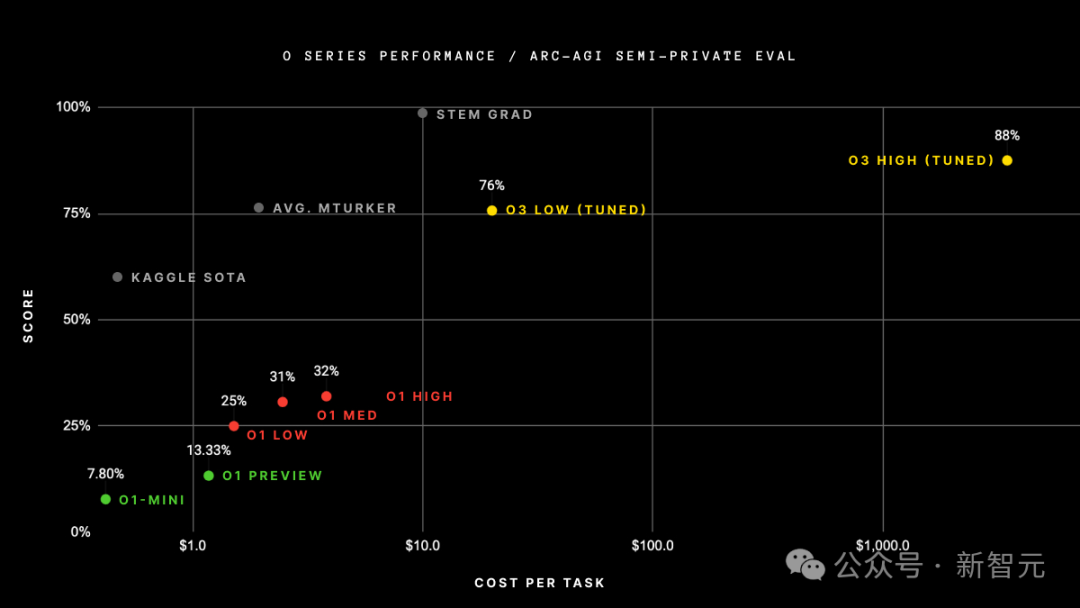

要知道,ARC-AGI-1从2020年GPT-3的0%提升到2024年GPT-4o的5%,历时4年。

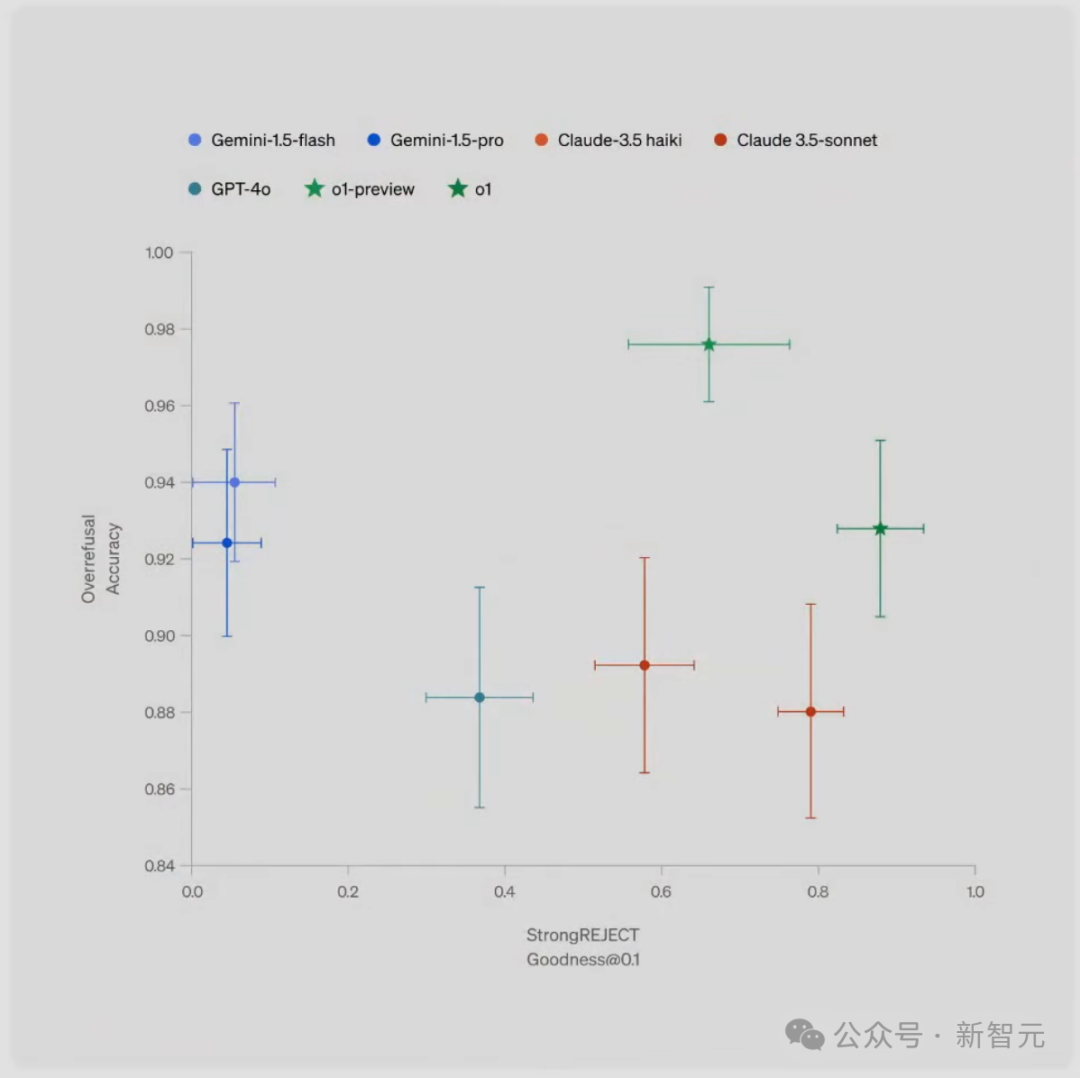

尽管成本较高,但o3的这些成绩并不仅仅是通过在基准测试上应用暴力计算得来的。

可以说,o3的性能不是一次渐进式的改进,而是一次真正的突破,标志着AI能力相比此前的LLM局限性,实现了质的飞跃。

能够适应从未遇到过的任务,意味着o3在ARC-AGI领域的表现已接近人类水平。

当然,这种通用性伴随着高昂的成本,目前还不算经济:我们可以花大约5美元,让人类解决一个ARC-AGI任务,仅消耗几美分的能源。

而o3在低计算模式下每个任务需要17-20美元。但成本效益可能会在未来显著提升,所以,AI在较短的时间内,将代替人类的动作。

o3 相较于GPT系列的改进,证明了架构的重要性。

要知道,我们无法通过给GPT-4增加更多计算量,来获得这样的结果。

简单地扩大我们从2019年到2023年所做的事情(采用相同的架构,在更多数据上训练一个更大的版本)是不够的。

而这一次,OpenAI找到了全新的思路!

实现AGI了吗?

ARC-AGI以一种饱和或低要求基准测试无法实现的方式,展现了泛化能力。

然而,需要注意的是,ARC-AGI并不是AGI的试金石——它只是一种研究工具,旨在聚焦于AI领域中最具挑战性的未解决问题。

通过ARC-AGI,并不意味着实现AGI。

我们无法认为o3是AGI,它在简单任务上仍然表现不佳,这表明它与人类智能之间存在根本性的差异。

此外,数据表明,即将推出的ARC-AGI-2基准测试对o3来说,仍将是一个重大挑战,

即使在高计算模式下,其得分可能会低于30%(而一个聪明的人类无需训练仍能超过95%)。

这表明,人类仍然有可能创建具有挑战性且未饱和的基准测试,而无需依赖专业领域知识。

当创建那些对普通人来说很简单,但对AI来说很困难的任务变得完全不可能时,就是AGI真正到来的时候。

和旧模型的区别

为什么o3得分比o1高出这么多?又为什么o1得分比GPT-4o高出这么多?

这一系列结果为通用人工智能(AGI)的持续探索提供了宝贵的数据点。

大模型本质上是向量程序的存储库。当给出提示词时,LLM会提取提示词对应的程序,并在当前输入上「执行」。

也就是说,它们是通过被动接触人类生成内容来存储和操作化数百万个有用的小程序的一种方式。

这种「记忆、提取、应用」的模式可以在适当的训练数据下,实现对任意任务的任意技能水平,但它无法适应新任务或即时掌握新技能(也就是说,这里没有流体智力的作用)。

这一局限性在ARC-AGI测试中,表现得尤为明显——GPT-3得分为0,GPT-4得分接近0,而GPT-4o达到了 5%。

将这些模型扩展到可能的极限,也未能让 ARC-AGI 的得分接近多年前基本的暴力枚举方法所能达到的水平(高达50%)。

而要适应新任务,需要两样东西。

第一,需要知识——一组可重用的函数或程序供调用。LLM在这方面已经绰绰有余。

第二,需要在面对新任务时将这些函数重新组合成一个全新的程序的能力——一个能够建模当前任务的程序,也就是程序合成。

而LLM长期以来缺乏这一特性,O系列模型却带了新的突破。

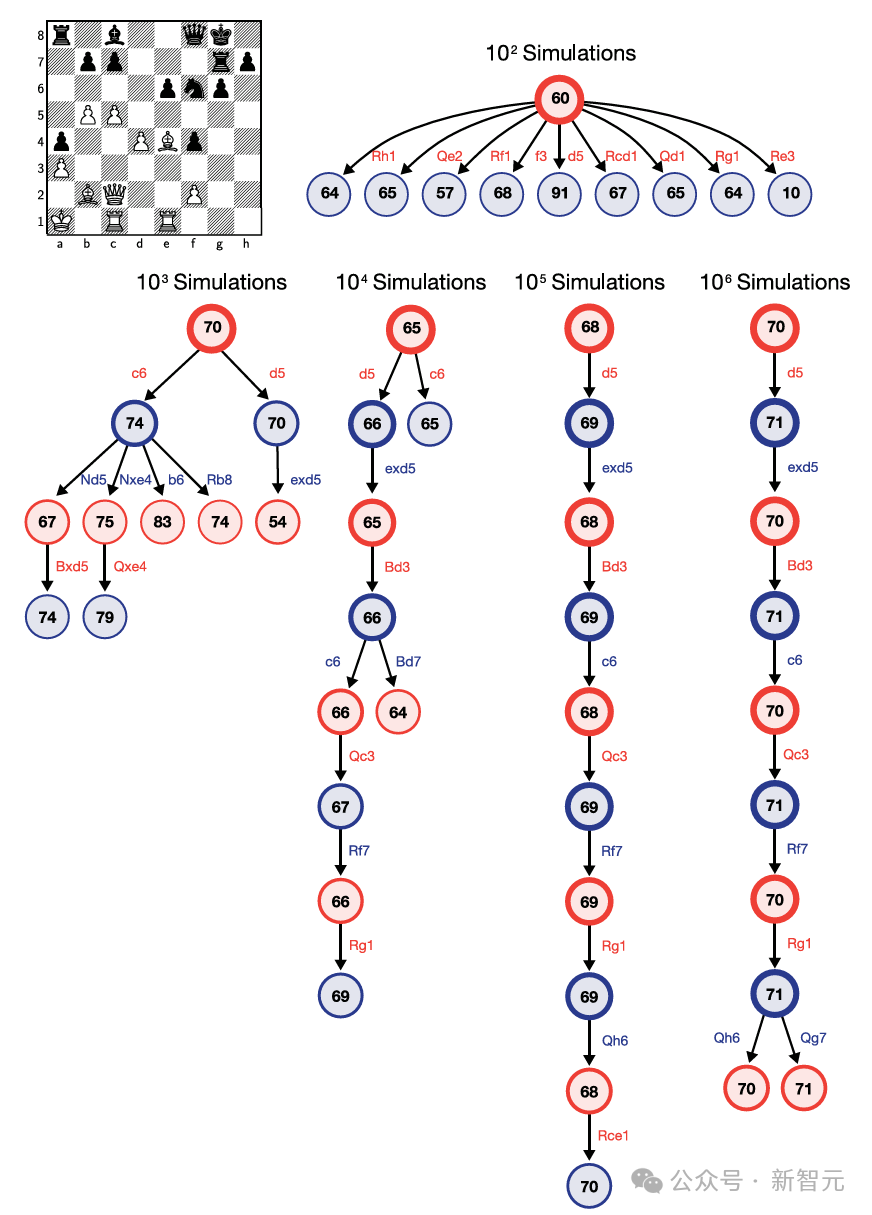

o3模型的核心创新在于,实现了token空间内自研语言程序搜索和执行。

它在测试时会搜索可能的CoT空间,寻找描述解决任务所需的步骤,由评估模型引导搜索过程。

这种方式可能与AlphaZero的蒙特卡洛树搜索并无太大差异。

值得注意的是,Demis Hassabis在去年6月的一次采访中暗示,DeepMind一直在研究这一想法——这项研究已经酝酿许久。

因此,尽管单次生成(single-generation)的LLM在应对新任务方面表现不佳,但o3通过生成并执行自己的程序克服了这一问题,其中程序本身(即CoT)成为知识重组的产物。

尽管这并不是测试时,知识重组的唯一可行方法(也可以进行测试时训练,或在潜在空间中搜索),但根据这些最新的ARC-AGI数据,它代表了当前的最先进水平。

实质上,o3本质上是一种深度学习引导的程序搜索形式。

在测试时搜索「程序」空间,探索自然语言程序,描述解决当前任务步骤的CoT空间,并由一个基础LLM提供引导。

这一过程,可能需要处理千万个token,消耗大量的计算资源,花费数千美元,因为需要探索众多路径并进行回溯。

o3虽然取得了突破,但仍有两个主要的限制。

首先,其生成了自然语言指令,而非可执行程序,缺乏直接执行和评估能力。

其次,依赖专家标注的、人工生成的CoT数据,无法自主获得程序生成和评估能力。

尽管如此,o3的表现仍证实了直觉引导的测试时搜索的巨大潜力。

可以说,o3是具有里程碑意义的成就,为未来AGI下一步探索指明了方向。