阿里Qwen团队发QwQ推理模型预览版 开源版本将很快发布

2025-02-25

/ 阅读约1分钟

来源:cnBeta

阿里Qwen团队今日在Qwen

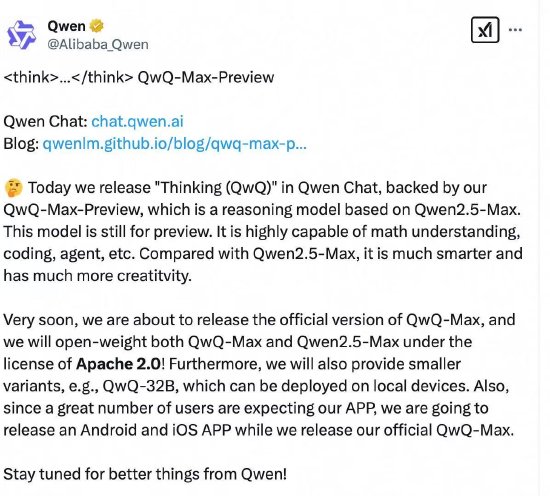

Chat中发布了“Thinking(QwQ)”模型,这是一款由QwQ-Max-Preview提供支持,基于Qwen2.5-Max的推理模型。目前,该模型仍处于预览阶段,具有很强的数学理解、编码、代理等能力。与Qwen2.5-Max相比,它更加智能,具有更多的创造性。

“很快,我们将发布QwQ-Max的正式版本,并将QwQ-Max和 Qwen2.5-Max的开源版本发布在Apache2.0许可下。”阿里Qwen团队表示,团队还将提供较小的版本,例如QwQ-32B,可以在本地设备上部署。