OpenAI 最近奉上了满血版的 o1 Pro,这一全新系列的模型究竟有多强?它能否指明 AI 发展的未来方向?沃顿商学院教授在 3 个月的前一篇博客就中给出了「神预言」一般的答案。

o1 preview 问世 3 个月后,满血版的 o1 Pro 终于在上周以每月 200 美元的身价正式上线,阿尔特曼号称其为「当今世界上最智能的模型」。

所以,这个正式的 o1 Pro 究竟强大到了什么程度?

可以肯定的是,它远远不是一个走到 AGI 终点的灭霸,但这是 scaling law 之后的又一个里程碑吗?代表着未来 LLM 的发展方向吗?能像 OpenAI 研究院 Jason Wei 所说的,足以成为一个「传奇」吗?

就在 o1 Pro 发布的当口,沃顿商学院副教授、GenAI 实验室联合主任 Ethan Mollick 提起了这篇自己 3 个月前写就的博客,可以说既是模型发布前的「神预言」,也是一盆有理有据、恰到好处的「冷水」。

Ethan Mollick 表示,早在 9 月份我们第一次见到 o1 preview 时,他就写下了这篇博客文章,详解这个模型对当下和未来都意味着什么。模型的质量很重要,但更为重要的是,了解模型对人工智能未来的潜在意义。

下面,我们就把这篇文章当成时间传送门,将 3 个月前横空出世的 o1 preview 和处在性价比漩涡中的 o1 Pro 放在一起比较,或许可以给当下提供更多启发。

「草莓」大显身手

一段时间之前,我已经接触到了传闻沸沸扬扬的被称为「草莓」的增强版推理系统,现在 OpenAI 将其发布了,我也终于可以分享一些想法。

这个模型的确让人惊讶,但能力仍然有限,但最重要的是,它的出现指明了 AI 的发展方向。

新模型被称为 o1-preview(此处 Mollick 狠狠吐槽 OpenAI 等一众 AI 公司在命名上非常糟糕),让 AI 在解决问题之前先「思考」一个问题,因此能够解决需要规划和迭代的困难问题。

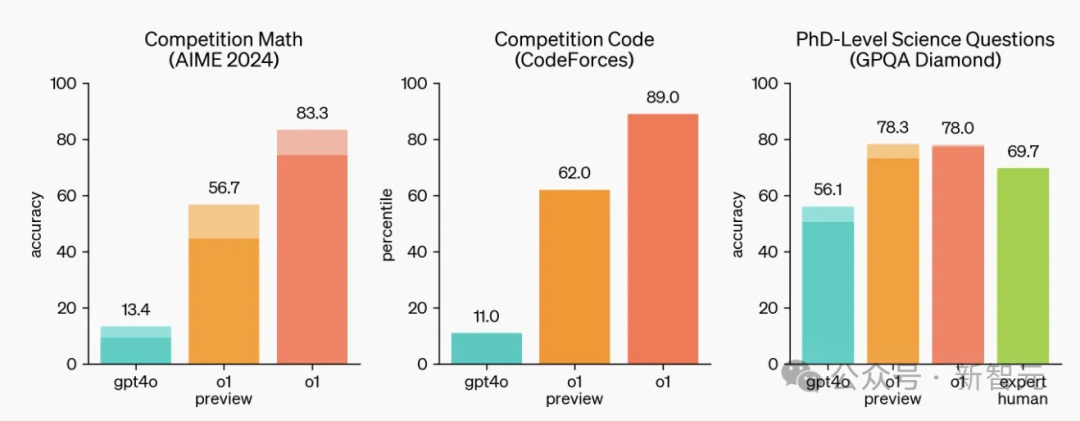

根据这张我们都熟悉的基准结果图,o1-preview 在数学和科学领域尤为强悍,对于极其困难的物理问题,甚至可以击败博士级别的人类专家。

但需要明确的是,o1-preview 并不是在所有方面都有提升,比如在写作方面就没有比 GPT-4o 更强;但对于需要计划的任务来说,变化就相当大了。

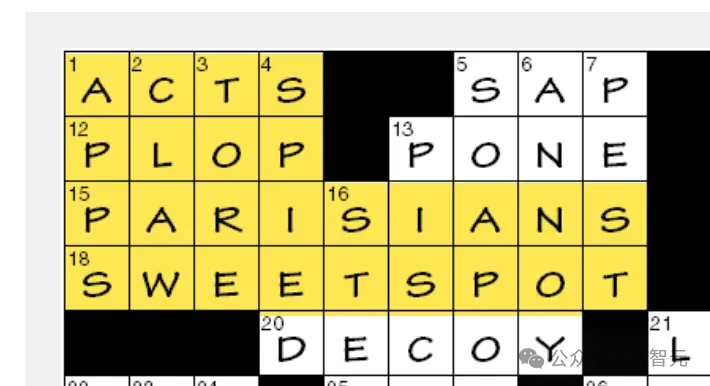

由于很难评估所有这些复杂任务的输出,因此要展示「Strawberry」模型的提升(以及一些限制),也许最简单直观的方法就是游戏 —— 比如填字游戏(crossword puzzle)。

不要小瞧了填字游戏,这是一个下限很低但上限也很高的项目,最难的填字游戏完全可以达到地狱模式,而且非常考验逻辑推理能力。

电影《模仿游戏》中就有这样的情节:二战期间,AI 之父 Alan Turing 担任英国密码破译项目 Enigma 的负责人,为了招揽全国在数学和密码学方面的才俊,他就在报纸上登出了一个填字游戏作为报名测试,甚至最后一关的现场考核也是要求 a 在规定时间内做出填字游戏题。

电影《模仿游戏》剧照

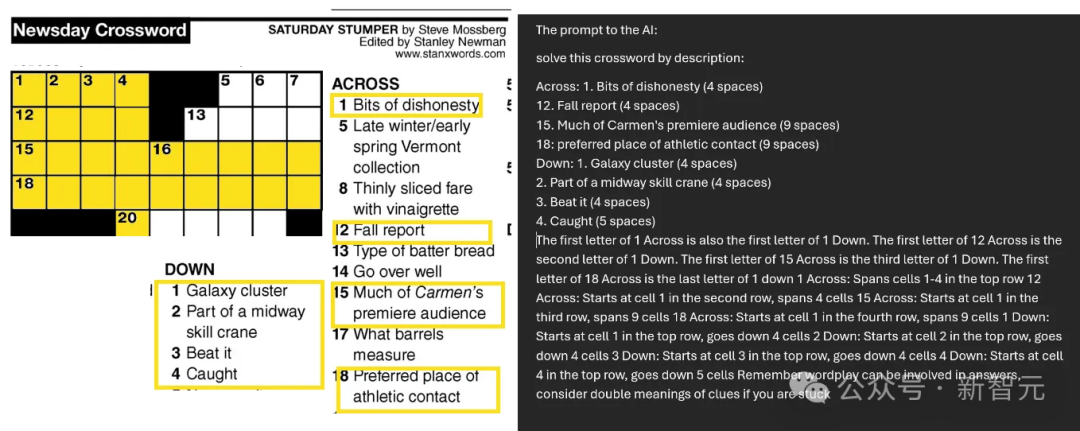

由于 o1 preview 还无法从图片中读取文字,因此 Mollick 只能自己手动打出来喂给模型。如下图所示,这是一个相当具有挑战性的难题,而且,Mollick 只挑选了 18 条线索中的 8 条提供给 o1。

填字游戏对于 LLM 来说尤其困难,因为需要迭代解决:尝试并否决掉许多相互关联的答案 —— 这是之前的大模型无法做到的,因为他们一次只能在答案中添加一个 token / 单词。

如下图所示,如果给 Claude 提供相应的线索,它首先给出序号 1 的答案(它猜测是 STAR,但这个答案是错误的),然后在此基础上尝试解答其余部分。

然而,由于第一颗扣子就扣错了,Claude 永远都无法接近正确答案。如果没有规划流程,它就只能向前冲,并不知道自己前进的方向是对是错。

Claude 的尝试

但面对相同的问题时,「草莓」时会怎么做呢?

首先,它会开始「思考」,这个过程持续了整整 108 秒(但大多数问题都能在更短的时间内解决)。

而且,o1 思考时并不是一声不吭,而是会「自言自语」,输出自己的「思维链」让你看到它的想法。下面是其中的一个示例(还有更多内容未展示出来),而且这些想法非常有启发性,值得你花点时间阅读。

在这个过程中,「草莓」反复迭代,不断创造想法并否决其中不可行的部分,结果做得很好,令人印象深刻。

但值得注意的是,o1-preview 似乎仍然基于 GPT-4o,而且有时对于语言的理解过于拘泥于字面意思。

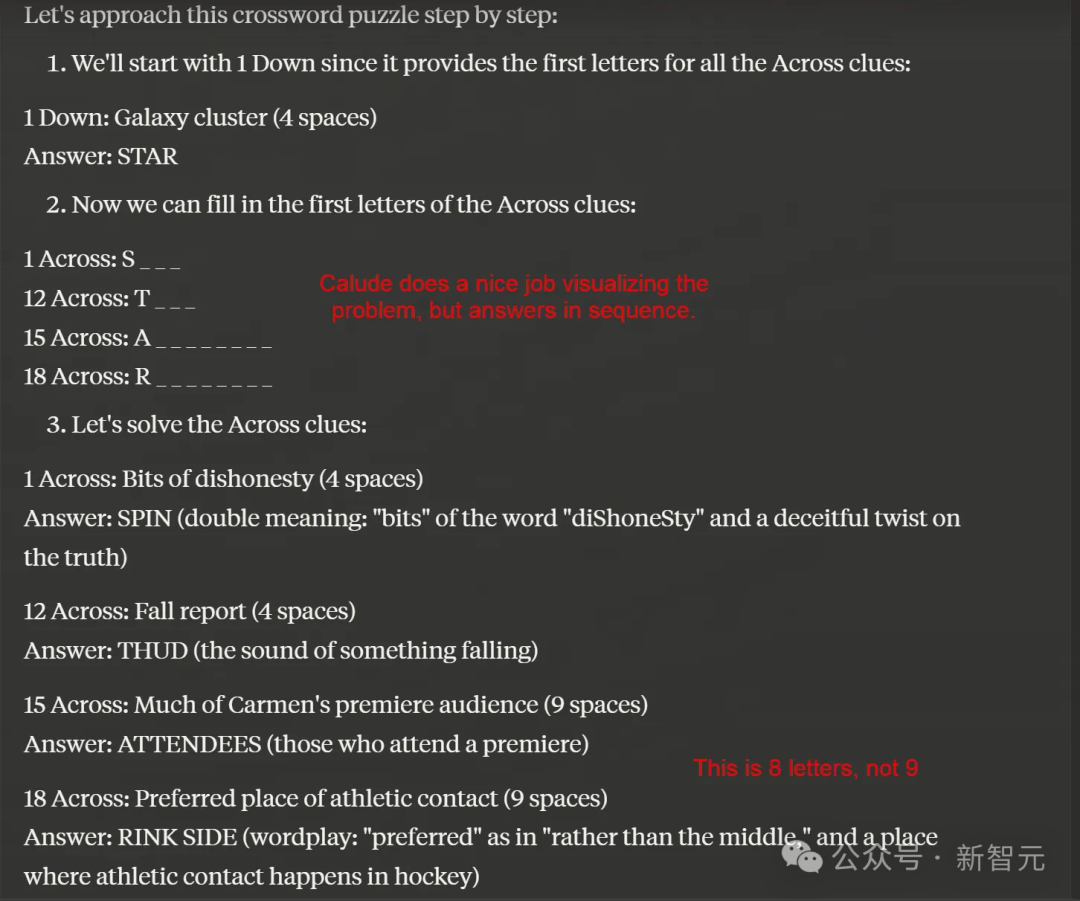

比如,下图右侧中 1 Down 的答案是「Galaxy cluster」,这显然并不是指真正的星系,而是 Samsung Galaxy 手机 ——「APPS」。

AI 并没有猜到这层意思,因此不断尝试各种星系团的名称,然而确定 Down 1 是 COMA(是一个真实的星系团),可想而知,其余的结果也不正确。虽然不完全符合规则,但也相当有创意。

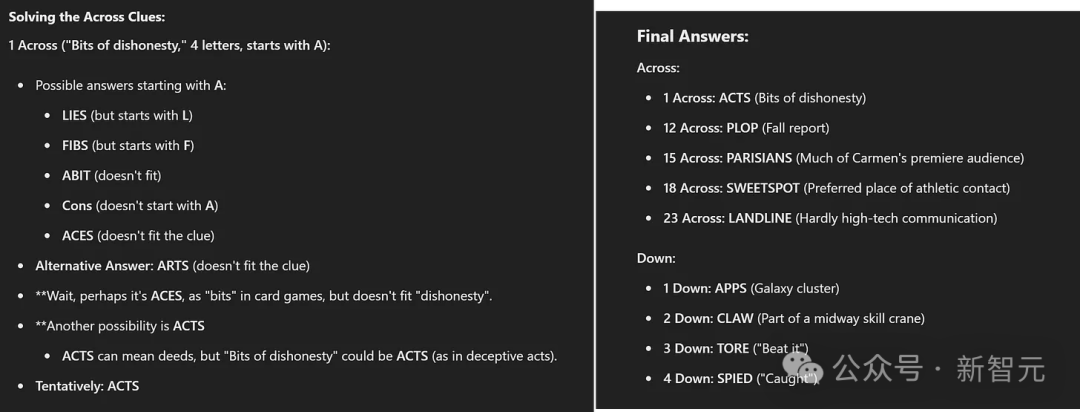

但公平来讲,Mollick 本人也没有猜到这层意思。如果把「Down 1 是 APPS」这个线索提供给 o1,可以看到模型又开始在接下来的 1 分钟内快速迭代想法(下图左侧),并正确推理出了 Across 1 的答案是「ACTS」。

这里是 o1 在一条线索的基础上给出的最终答案,完全正确,而且解决了硬引用,尽管它幻想出了一条不存在的新线索。相比之下,身为名牌大学副教授的 Ethan Mollick 甚至都没能接近这个正确答案。

至此我们可以发现,o1-preview 做了一些没有 Strawberry 就不可能完成的事情,但它仍然不是完美无缺的:错误和幻觉仍然会发生,而且仍然受限于底层模型 GPT-4o 的「智能」的限制。

虽然 Claude 有很多优点,但相比之下,o1 在复杂规划或解题方面远远胜出,代表了这些领域的巨大飞跃。

从协同智能到...

o1-preview 意味着我们正面临人工智能范式的改变。「规划」是智能体的一种表现形式,人工智能可以在没有人类帮助的情况下自行得出结论并解决问题。

可以从上面的例子中看到,AI 完成了太多繁重的思考工作,并产生了完整的结果,人类作为合作伙伴的角色反而被削弱了,整个过程的主体是 AI 完成了自己的工作并给出答案。

当然,我们可以筛选推理思维链的输出来发现 AI 犯了哪些错误,但 Ethan Mollick 的感觉是,他作为布置任务的人,和 AI 的输出内容之间没有什么联系,也没有在引导解决方案的走向上发挥重要作用。这不一定是坏事,但和之前不同。

随着这些系统不断升级并逐渐接近真正的自主智能体,我们需要弄清如何与其保持人类在保持同步 —— 既能捕获错误,又要及时察觉到我们试图解决的问题。

o1-preview 正在缓缓拉开帷幕,解锁我们尚未见到的 AI 能力,尽管它目前还存在局限性。这给我们留下了一个关键问题:随着 AI 的发展,我们如何进化人类与人工智能的合作?这是 o1-preview 目前还无法解决的问题。

参考资料:

https://x.com/emollick/status/1864857524840616345

本文来自微信公众号:新智元(ID:AI_era)