腾讯微信正式发布多模态大模型 POINTS 1.5

3 周前

/ 阅读约2分钟

来源:IT之家

据官方介绍,这一代 POINTS 模型,不仅兼顾了 POINTS1.0 中所坚持的效率优先的思想,同时极大了增强了模型的性能。

感谢IT之家网友 输入法、有鲫雪狐 的线索投递!

IT之家 12 月 14 日消息,距离 POINT1.0 的发布已经过去两个月的时间,腾讯今天宣布推出 POINTS1.5。

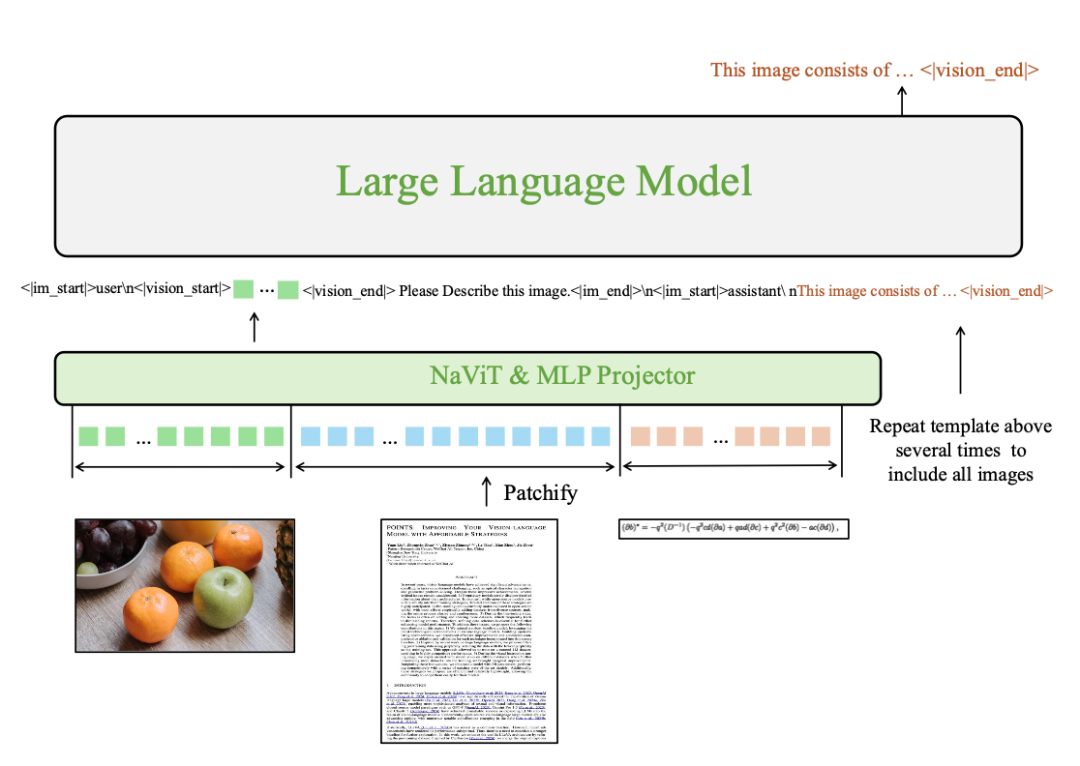

IT之家注意到,POINTS1.5 仍然沿用了 POINTS1.0 中使用的经典的 LLaVA 架构,由一个 vision encoder,一个 projector 和一个大语言模型组成。

据官方介绍,这一代 POINTS 模型,不仅兼顾了 POINTS1.0 中所坚持的效率优先的思想,同时极大了增强了模型的性能。

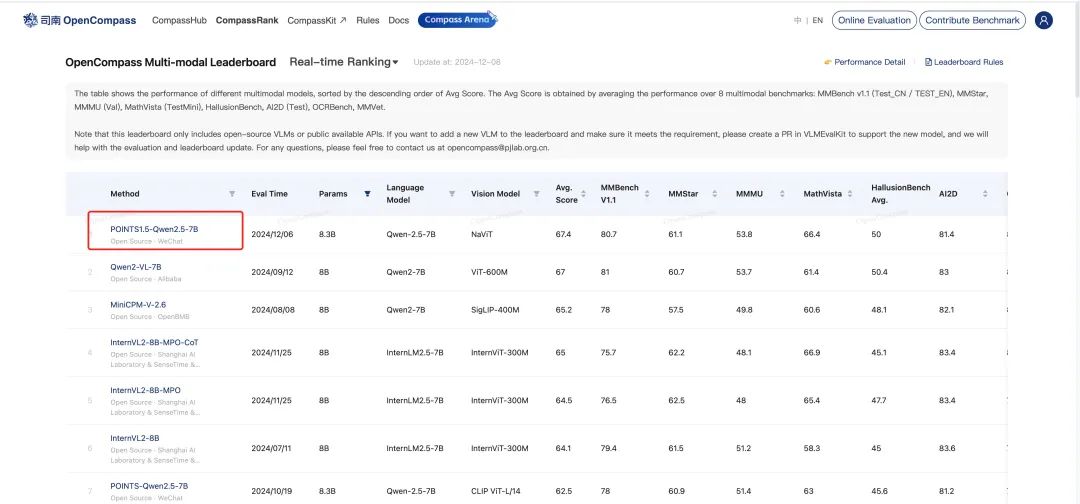

腾讯表示,POINTS1.5-7B 位居全球 10B 以下开源模型的榜首,超越诸如 Qwen2-VL, InternVL2 和 MiniCPM-V-2.5 等业界领先的模型。

实际应用方面,POINTS1.5 在复杂场景的 OCR,推理能力,关键信息提取,Latex 公式提取,数学,图片翻译,物体识别等几个方面中都有不错的表现。

参考资料:

Paper: https://huggingface.co/papers/2412.08443

Github: https://github.com/WePOINTS/WePOINTS

HuggingFace: https://huggingface.co/WePOINTS/POINTS-1-5-Qwen-2-5-7B-Chat

-

C114通信网

C114通信网 -

通信人家园

通信人家园