随着 DeepSeek 问世,从春节至今,和AI有关的资讯与讨论已经让人有些疲劳。然而,相关讨论大都聚焦在产业、投资和技术方面,其中不乏优质信息,但仍缺少一个重要的视角——作为普通用户,我们如何看待并使用AI。

大多数人并不处在技术的前沿,但相比于 2023 年 ChatGPT 刚诞生时, AI 对个人生活的影响已经来到新的阶段,DeepSeek的易用性和广泛接入程度,让每个人都可以成为AI使用者。

狭义的使用,包括Prompting(输入提示词),与AI闲聊,将AI融入工作流;广义的使用则跟我们对语言和信息的辨别力有关。这期播客,我们将和两位AI的深度用户,从各自的生活与工作场景出发,聊一聊使用心得,横比目前国内外流行的大语言模型,说说评价AI好用的依据和标准。

DeepSeek一度被称为「更懂中文」的AI,为什么有很多人觉得 DeepSeek 的中文特别「好」?当我们在说 AI 语言「好」的时候,又到底在说什么?

在一个本就信息爆炸的时代,AI既降低了信息获取的门槛,又在稀释信息的同时拉高了辨别信息的门槛。例如,DeepSeek 刚火的时候,网传冯骥(黑神话悟空的创始人)发布了「国运论」,而DeepSeek梁文峰还对此回应,一度在朋友圈盛传,后来被证实这些言论都是由DeepSeek生成的。

类似的例子还有很多。在AI时代,我们该如何提升对于信息的辨别力?AI技术和事实核查(Fact Check)又能进行怎样的结合?

本期问题青年

- 向辉,白读书屋主理人之一,前科技媒体工作者

- Fancy,现在游戏行业,前青年志趋势团队成员

- 阳少,青年志编辑

严谨的GPT与健谈的DeepSeek

阳少:你们都用了 DeepSeek。从使用体验上,它给你带来的最大惊喜是什么?局限性又在哪里?

Fancy:我先说个简单的。其实我接触 AI 很早,最初因为好奇去用了 ChatGPT。当时并没有意识到它能为你的工作做什么,纯粹是试探它的能力。之前对AI的感受局限在“Siri”,我发现GPT 比 Siri 更有互动性,Siri 可能只是给你一个搜索的页面,而 GPT 会试图理解你的问题。

对我来说,GPT 给人的感觉有点像从小灵通换到了诺基亚的翻盖手机。而如果说 ChatGPT 是从小灵通升级到翻盖手机,那 DeepSeek 给我感觉可能更像是从翻盖手机直接换成了大屏智能机。它的接入门槛低,有中国手机号就能用,也让更多人真正开始在日常生活中使用 AI。

ChatGPT 的表达风格有点“官方”或“职业化”,像一个训练有素的心理咨询师;DeepSeek 更像你身边善良、健谈的大姐,既亲切又幽默。我猜这也是为什么很多人喜欢它的原因。

另外,因为我是个同人女嘛,GPT和DeepSeek刚出来时做过把角色性格设定输入给AI、让它模拟角色互动输出段子来当乐子的事。ChatGPT 输出的内容往往很一本正经,看上去甚至有些滑稽,中文语料的运用略显生硬。而 DeepSeek 则带着点网文风,幽默感更强,符合看梗、段子的习惯,这可能跟它的训练语料,很大程度受中文互联网社群、论坛的影响有关。

向辉:我也算是 ChatGPT 的早期用户,但最初的使用频率不高,因为限制会导致偶尔网络连接不畅。尽管如此,最早体验 ChatGPT 时还是觉得挺惊艳的,尤其是语音功能推出后,那感觉就像电影《Her》里会出现的场景。

当你对AI的使用频率不高时,就会更多把它当作一个“头脑风暴”的存在。后来Claude 3.5(Sonnet)推出时,给了我很不一样的体验。我觉得Claude的输出比 ChatGPT 更流畅、有人情味,文字表达也更优美。我用它写过诗,也跟它讨论过很多哲学和社科议题。

Claude 是一家硅谷创业公司开发的 AI,目前在业内也算热门。它有免费版和付费版,一次性推出了三个版本,名字都很文艺——Sonnet(十四行诗)、Opus(大作)、Haiku(俳句)。其中Opus 是最高级的,我用它来试着做了一些文学创作,体验很不错。

因此,当DeepSeek出现后,我的使用感觉是和Claude类似,但稳定性稍逊。我曾经抛给了ChatGPT、Claude 和 DeepSeek同一个关于“拼音拉丁化”的问题:很多地方性语言只有口语,没有文字,而拉丁化是一种书写方式的转换,我询问哪些语言更容易拉丁化,或者哪些语言在历史上成功完成了这一过程。GPT 的回答生硬,核心内容偏离问题,而 DeepSeek 给出了一些有用的信息,这让我还蛮意外的。但这也是DeepSeek唯一让我满意的一次,之后感觉它实在是太喜欢“发明概念”了。

如果说GPT 是一个上班族,逻辑清晰,按 1、2、3、4 列出要点,那么 DeepSeek 更偏修辞和比喻,甚至会创造一些新的词汇。比如,它特别适合生成贺词、个人年度报告、打油诗之类的内容,这可能也是它在春节期间大火的原因。

阳少:向辉说 DeepSeek喜欢发明概念这点我还蛮有感触的,作为编辑,我用AI的主要用途就是帮忙归纳、整理和总结。从这一点来说,我感觉ChatGPT(免费版)和DeepSeek的差别不是特别大。但后者的问题在于,它喜欢自己发明一些看似高深但经不起推敲的概念,比如网上很多人吐槽“量子”、“塌缩”、“熵增”的滥用——这些话很漂亮,但你其实不太需要。

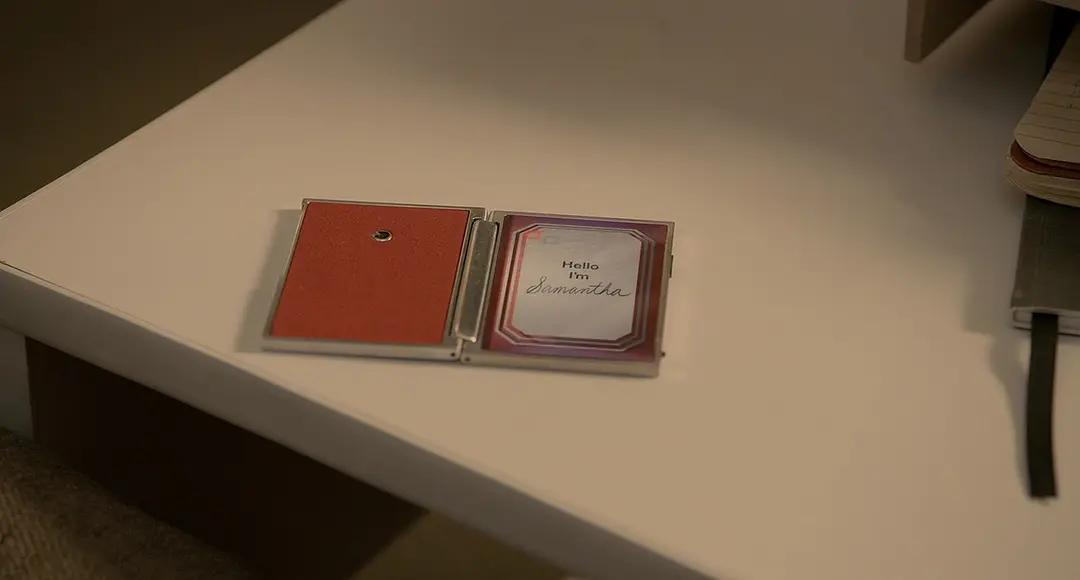

电影《她》

向辉:我这里想再介绍一个大模型,就是Google推出的Gemini Flash Thinking。虽然 Transformer 这个核心架构最早是谷歌提出的,但谷歌在大模型领域一直处于落后地位。所以当他们推出Gemini早期版本时,尽管各种跑分显示它超越了同期的 GPT,但实际使用体验并不好。不过,在发布新版本 Flash Thinking后,我觉得体验流畅了很多。

这其中有个变化,就是在 Gemini 的界面中,右侧有一系列调节按钮,其中有一个叫 Temperature的选项,这个 Temperature 影响模型的输出风格。如果你想让模型回答更严谨,就把 Temperature 调低一些;如果想要它的回答更发散、更有创造力,就调高一点。

我后来看科普才知道,所有的大模型在推出时,Temperature 一般都被限制在 4.5 以下。正常情况下,GPT的默认值大约是 1.5,而 DeepSeek 可能会更高一些,超过了2。此外,Claude 也提供了不同的输出风格选项,比如“紧凑” “解释性”或“简短”等,这些其实都和 Temperature 参数有关。我猜 DeepSeek 在微调时可能选择了一种略显“哗众取宠”的策略。另外,中文互联网语境里,可供它训练的严谨语料可能也没那么多。

阳少:在 DeepSeek 之前,其实已经有很多国产大模型,比如豆包、通义、Kimi 等,各大互联网公司都在布局 AI 领域。但为什么这些模型没有像 DeepSeek 这样突然爆火?

向辉:我分享一些行业内部的观察,可能有点以偏概全。大概在 2023 年,国内对大模型的讨论非常热烈。当时我有帮一些记者写稿,他们经常去参加各种大型科技会议,会议上人人都在聊 AI。

但当时国内关注的 AI 方向,除了 ChatGPT 这种大语言模型,还有两个主要领域:开源模型和行业大模型。前者比较好理解,Meta(Facebook 母公司)推出了 Llama 这个开源模型,它的表现相对稳定,开源社区里也有很多人在基于 Llama 进行微调、扩展训练语料或优化技术方案。国内很多大模型,比如 Kimi、通义等,大多是在这个基础上开发的。

而行业大模型这个方向针对特定的行业需求,比如医疗、金融、客服等,企业会直接开发行业解决方案。很多公司(包括阿里、腾讯等)都在这一块投入资源,因为当时大家普遍认为,要在大模型赛道追赶 ChatGPT 难度太大,还不如利用 GPT 或 Llama 作为基座模型,训练针对特定行业的小模型。

所以在那个阶段,国内的共识是 AI 应该聚焦在应用层面,甚至李彦宏也曾说“做 AI 就是要做应用”。结果 DeepSeek 的横空出世彻底改变了这个认知。回顾当时的情况,很多国产大模型的体验都不如 ChatGPT,用户自然会选择更好用的 ChatGPT 或 Claude。而行业大模型虽然在企业端有市场,但普通用户接触不到,所以热度有限。

AI给出的思索过程,可以缓解决策焦虑?

阳少:DeepSeek 火了之后,网上涌现了大量使用教程,大家都在说“打破信息差”,AI感觉像是无所不能了。但你们觉得,具体到一些专业场景,AI到底能做什么?又做不到什么?

Fancy:我平时主要做写报告和定性研究,AI对我最大的帮助就是基础的语言翻译和信息搜索。另外像我的一些同事更常用AI来帮助调试和编程。就算是入门的编程水平,AI也能快速根据需求生成代码并帮忙 debug,就这方面来说,效率提升是非常明显的,再也不用一个个查找解决了。

如果是一些简单的文书工作,不讲究文学性的话,AI的确能帮大忙,但涉及到复杂的语境或者是理解层次深一点的内容,它就有点做不到了。我有时需要把一份很长的资料提炼成要点。这个过程不仅仅是信息的压缩,更多的是对中文词义的深度理解。比如,我要求AI总结一个产品的外观、使用度、易用性和它在实际生活中的使用场景等,它有时候就理解不了。再比如网文内容出海需要翻译,“破防”这个词,AI会翻译成“break defense”,但在中文语境下,“破防”是一个最早来自游戏里的词,后来指一个人丧失体面、无法自持的状态。AI显然抓不到这个文化背景。

我觉得,不管是夸奖还是质疑 AI 的人,实际上处于使用 AI 不同的阶段,而且他们对 AI 的态度也受到个人工作岗位或具体情境的影响。尽管我对 AI 在工作中的表现有很多不满,但在生活中,当我面临巨大的决策焦虑时,你能看到它冷静而理性的分析方式和思考过程,这个过程对我来说是有启发的,哪怕最终的决策结果有问题。这个思索的过程在某些时候对我来说是有价值的。

比如过年期间,跟我一起回老家的小猫生病了,年初五才刚刚痊愈出院,当时我焦虑于,刚痊愈的牠能否跟我一起坐飞机、能否承受托运的状态。我分别向 ChatGPT 和 DeepSeek 询问,结果截然不同。ChatGPT 的回答是:“你是否因为太焦虑而提这个问题?”它试图让我反思自己的核心需求——既不想让宠物受罪,又舍不得分开。

DeepSeek 则走了另一条路线,它先安抚我,说“看得出来你很爱猫,但你又不想分别”,然后突然来了个赛博玄学的解读:“既然已经定好了托运,说不定这是个好预兆。”它的回答可能受到了对话上下文的影响——前段时间赛博算命很火,我也用 DeepSeek 试了一下,后来在没有开启新对话的情况下询问宠物托运问题,它可能读取了之前的“算命”语料,于是给出了类似“良辰吉日,应该带猫走”这样的回答。

我顺便问了另一个问题:“如果我想生活在一个宠物友好的城市,有什么建议?”这个问题很泛,但 ChatGPT 先反问:“你如何定义‘宠物友好’?”然后列举了一些标准化的内容,像是百科里的正确废话。而 DeepSeek 则不断推测:“用户想要宠物友好,且担心猫……说明他很爱宠物……那他的生活和工作是否应该与宠物高度绑定?”最终,它的建议竟然是建议我去考动物行为学证书,进入宠物行业,甚至推荐杭州——但杭州显然是个遛狗都不太方便的城市,这种荒谬感非常强烈。

当 AI 处理带有复杂社会含义的问题时,它们的局限性就显现出来了。ChatGPT 在无法深入理解时,会退一步,给出模糊但相对安全的答案,而 DeepSeek 则会用“自信但胡说八道”的方式继续推理。

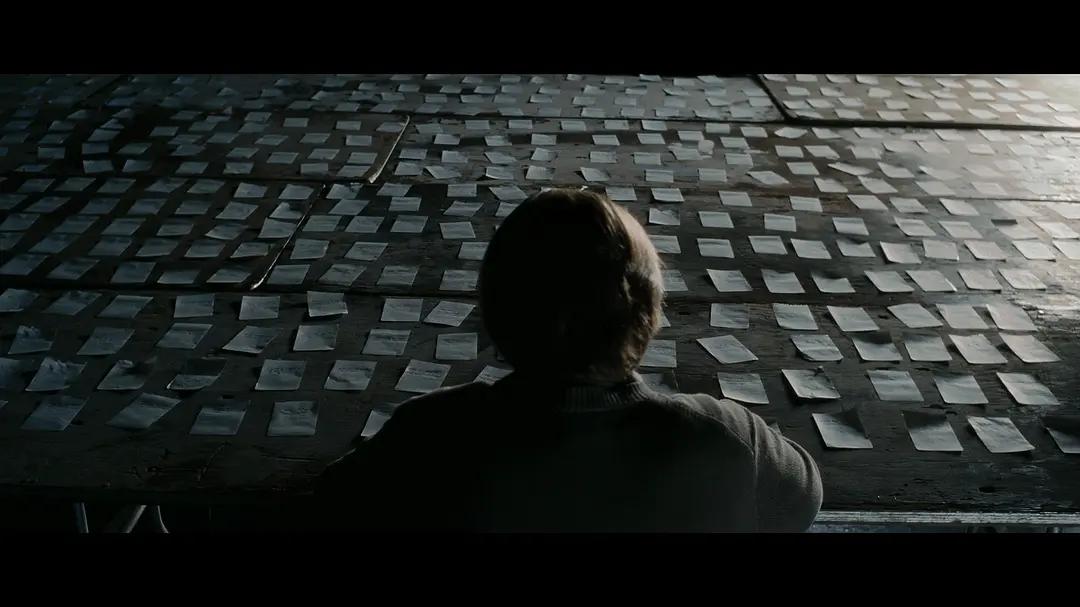

电影《我想结束这一切》

向辉:我觉得文字是个比较敏感的东西,最终取决于人对文字的要求。如果是写一些比较普通的内容,比如之前我也会写一些简短的文章,我会大量使用Claude来帮助润色、翻译,将一大堆信息浓缩成精简的概括。

它可以把一些信息整理成容易理解的内容。比如介绍一本新的学术书籍,你可能没时间看完整本书,但通过快速搜集资料,再让 AI 帮忙汇总,理出大纲,你就能很快写出一篇几千字的文章。这种方式效率非常高。尤其在忙碌的时候,使用 AI协作,一天能写三四篇短文章,而不使用时,最多只能写两篇,还得费劲儿。毕竟有些学术词汇你并不熟悉。

你需要非常清楚 AI 能做什么,不能做什么。它就像是一个实习生,刚从大学毕业,跨专业来工作。虽然对这个专业什么都不懂,但他非常有干劲,算力也很强。你能给它安排一些任务,但不能给它做不了的工作,比如直接让它生成一篇文章,显然是不可能的。不过据说最新的GPT deep research可以了,一次生成上万字的完整资料。

另外,关于翻译,我觉得AI很快就能 替代 90% 以上的翻译工作。在这之前,谷歌翻译等工具就已经做得不错了,尽管当时的“高端”翻译能力,尤其是文学翻译、诗歌翻译、以及一些学术类的知识密集型翻译,还有很大的提升空间。接入AI以后,翻译能力都比以前强多了。因为大语言模型翻译是会照顾到上下文的,比如你要它翻译一个韦伯的文献,它就会把和韦伯相关的名词联系在一起,至少从术语的翻译上是过关的,并且在我的使用体验里,这还在不断优化。

如何向 AI 提问?描述与需求的「双轨制」

阳少:我想先问一个问题,你们会对AI 说谢谢吗?

Fancy:我会的。我不光会说谢谢,在它胡说八道的时候,也会很生气的质问它:你为什么要骗我?特别是在我每个月给你花20美金的前提下。

阳少:我就是那种从来都不跟AI说谢谢的人,完全把它当工具,并且会使用大量的祈使句。之前跟朋友开玩笑说,等以后AI统治世界,像我这种人就是要被抓进AI集中营的,而那些会跟AI说谢谢的人,可能会得到AI的善待。

之所以会问这个问题,是因为接下来想跟两位聊聊Prompting,就是怎么给AI 输入提示词。AI的使用是非常个人化的,你怎么跟它对话,决定了它怎么给你输入信息。你们对于Prompting有什么心得和体会吗?

向辉:我觉得 Prompting 这个事挺有意思的。尤其是在 DeepSeek 出来以后,Prompting 的角色好像变弱了。原来用 GPT 时,网上有很多教程教你怎么Prompt,才能得到一个可靠的结论,或者是一个很好的流程。但在 DeepSeek 出现后,大家发现,好像怎么用都能得到比较合适的结果。这其实说明了,DeepSeek的提示语机制并不总是在响应你提出的要求,反而是对里面的关键词很敏感,但你不知道它到底会识别哪些词为关键词。比如像Fancy前面提到的例子。

“提示词工程(Prompting engineering)”这个概念出自吴恩达,是通过合理的提问来引导AI做出最佳回答。这里涉及到了人类语言的习惯问题。我们在描述一件事情时,“命令”与描述是混合在一起的,比如我说“桌子很脏”,这是个描述,也是一个“需求”,可以暗示你去擦桌子。AI与人类对话时,工作方式就像“双轨制”,它在你的描述中提取你隐藏的“需求”,然后再执行。这就像人类在日常交流中,很容易分辨出你是描述一个事情,还是在提出一个请求。而AI训练时并不总是能直接理解这些,所以它需要一些特别的提示来帮助它分辨用户的意图。

在DeepSeek这个阶段,大语言模型逐渐可以不依赖复杂的Prompt,它在处理时会根据你之前输入的语境找到要点。但有时候,这种优化也带来了一些问题,它会非常依赖一两个关键词,然后疯狂输出,最后造成“过度生成”的情况。

关于我自己使用AI的方式,我试过一些不同的方法。有时我会将一些指令直接放在前面,像是让AI处理某段文本,或者要它完成几个明确的任务。比如先把语料粘贴进去,然后清楚地列出任务要求:“做1、做2、做3”。我发现这种做法效果较好,因为它让AI知道你的优先级是什么,并且能够按顺序执行任务。但同时我也得注意,不要让它做太多的事。一次最多给三个命令,超过了它可能就不太能完成了。

还有一个问题很奇怪,就是GPT的输出格式。AI在列出要点时非常规范,但如果我让它输出连贯的段落,而不是以“1、2、3”的方式进行要点呈现,就会出现记忆的缺失。比如,可能它输出了“1”之后,就不记得“2”的内容了,或者你的提示词里出现了让它不要做什么,三个点可能都会遗忘。这个问题看起来就像是一个典型的不成功的prompt —— 它没有理解你想要什么。

阳少:我感觉AI的思绪是高度结构化的,当然这种结构化足以应付许多人的工作与生活场景。但如果放到「叙事」的角度,并不是所有叙事都得按照结构化的方式展开。相反,结构化的表达,会抑制叙事的多样性与复杂性。

电影《纽约提喻法》

真诚丧失了吗?AI时代的「敷衍文学」

阳少:DeepSeek出来后,当人们说某个AI “语言好”时,到底是在说什么?现在小红书起号了一大批以DeepSeek为噱头的情感、生活和职场博主,标题往往是“被DeepSeek狠狠共情一针见血了”,这样的表达,填补了当今人们哪些情感上的空白?

Fancy:DeepSeek火起来后,一度被推崇为“更懂中国人”的AI。我记得之前有个生活博主发布过一个视频,她半开玩笑地说,Deep Seek一出来,就不需要再问情感博主,直接问DeepSeek就行了。

我个人感觉是,AI确实比谷歌的搜索栏更有互动性,它有点像一个桌面“电子宠物”,让人产生点依赖,甚至投入真情实感。我记得很早以前的电脑系统就有“桌面宠物”这种功能,,它可以动来动去,甚至可以换衣服。工作时,我会戳它一下,看它有反应,虽然这只是个小游戏,但这种互动感有时能让人感觉舒服。

至于你提到的情感博主用DeepSeek起号,或许还是因为它的普遍性和易用性,让很多人找到了倾诉的窗口。就像以前的网易云评论区,后来成了一个情感释放的场所,被戏称为“网抑云”。在情绪低落时,人们总是需要一个树洞去倾诉的。我们今天日常的很多沟通,都是讲究效率的、理性驱动的,甚至有些沟通是很暴力的,但人们其实在日常生活中是需要“深刻时刻”的,而且也需要不敷衍的支持。deepseek可能恰好提供了这样一个窗口。

向辉:春节的时候,有个朋友发了个朋友圈,他是拍短视频的,经常要写脚本,他说,DeepSeek写的比他好多了。他当时问DeepSeek:你为什么写的这么好?灵感从哪里来?

DeepSeek用了很多词汇,像“文明胚胎学”、“神话原型烙印”、“神经共鸣定律”、“道德拓扑学”、“最小善意的最小公倍数”、“文学蜂群效应”、“创伤修复本能”等等。这非常奇怪。因为他的提问是非常自然的,但DeepSeek却一下子造了十几个不自然的词,细想一下,每个词根本即使把一些理科词汇和文科词汇强行拼凑在一起,它们只是看起来“炫酷”而已,其实不知所云,没有任何实际意义。

为什么大家会觉得DeepSeek“写的好”,或者说为什么它打动了很多人?它说的很多内容我们都能理解,没有什么新奇的东西,没有什么意外,但它的语言呈现却非常丰富,有些地方甚至有点“变异”了。

就像Fancy说的,人类确实需要情感上的支持和交流,而这在大多数情况下都是通过语言来实现的。在AI的使用场景下,这种基于语言的连接会被无限放大。我们会把DeepSeek当作一个人来对话,不自觉地认为它具备了创造力、意识、感受力,甚至是像人类一样的情感。这是非常自然的反应,“它懂你”的心理暗示会不断加强。否则,为什么你会相信它说出来的内容呢?假设你跟你家的面包机说话,它的屏幕上突然输出一些小说般的内容,你一定会觉得很奇怪。

你们在讨论的时候,我还顺便在小红书上搜了一下,我发现加入“DeepSeek”标签后,点击量就会变得多。很多讨论都是关于关系的,比如“DeepSeek说女性最适合结婚的年龄”、“嫉妒AI,这正常吗?”等等,这种风格和小红书的氛围奇怪地融合在了一起,人们在寻求情感上的确定性时,也需要类似的自我确认机制。

阳少:我觉得这里面涉及到一个“真诚”的问题,AI并非说话的主体,因此尽管它能说出一些动听而漂亮的语言,总感觉会有些经不起检验。另一方面,我也在想,当人们寻求“情绪价值”时,真的那么在乎言语里面有多少“真”吗?假设这些话是坐在你面前的人说出的,Ta也未必是出于真诚,真诚有时伤人,而出于习惯、教养和技术等原因所习得的话语,才显得漂亮和情商高。

我们似乎不应该苛求AI“真诚”,但真诚却是一个可以继续追问下去的点。很早以前看《十三邀》采访陈嘉映,他提到鲁迅评价陀思妥耶夫的小说时有一个很精准的描述:真诚下面藏着虚伪,虚伪下面也藏着真诚。随着人类和AI的互动加深,我最担心的其实不是AI越来越像人,而是人越来越像AI,就连虚伪底下的那一抹真诚,也荡然无存。

Fancy:我非常同意你说的,不知道你们有没有听过一首网络歌曲叫《我的人机朋友》,里面有一段歌词是:从我发的表情包里面选一个 再发我一遍 把我的观点切片加个语气词 看起来更体面 最多加几个笑哭 就是他表达能力的极限。

这首歌本身挺有意思,但它描述的现象也很符合我对现代社交的观察。人与人之间最真诚、最认真对待的部分,往往被简化成了类似“敷衍文学”的东西。你在小红书上也能看到类似的例子。如果我想要安全地和你社交,就会有一张表格列出:当你表示惊讶时该说什么,当你想继续追问时该用什么词,当你生气时又该怎么说。我看到这些就会觉得,这不是把自己喂成 AI 了吗?

我也在想,为什么和AI挂钩后,社交就被打上了“不真诚”的标签。我们在面试的时候遇到过使用AI的候选人,其实对方明明很有能力,但当你发现对方的作业里有AI痕迹时,顿时会觉得对方“态度有问题”“不真诚”——但当人自己面对AI(比如deepseek)时,又会感觉自己被看见、被支持;好像单独面对AI时,AI又是真诚的。这个矛盾还挺有意思。

电影《她》

AI 既生产假新闻,也有潜力核查假新闻

阳少:我们前几天发了篇文章《当DeepSeek生成〈哪吒2〉热门影评:低注意力时代的信息稀释》,作者提到一个观点,“说人话”正在成为很多人使用DeepSeek的提示词后缀,当AI模仿定义了何谓“人话”后,真正有价值的内容可能是反而是“不说人话”的。你们怎么看待这个观点?

向辉:我突然想到一个点,AI可能会改变我们表达的语境。我们与 AI 的互动,不管是文字版还是语音版聊天,背后都有一些实际需求。我们可以将这些需求分为实际用途和具有消遣性质的——比如打游戏或要求提供情绪价值。而在日常交流中,选择使用什么词汇、说什么话,往往受到情景和语言表达风格的影响。有些人非常善于挑选词语,以至于他们能用简短的几句话精准评价他人,甚至带有幽默和讽刺的色彩。每当你听到这种评价,就会觉得这个人特别有趣。

现在我们对 AI 的要求也类似。有时我们会让DeepSeek 去“锐评”GPT,或让 GPT 去“锐评”DeepSeek。“锐评”原本是人与人之间吐槽的方式,通常是和朋友或持相同观点的人一起进行。这种评价常常带有犀利和尖锐的语言,而当我们让 AI 去做类似的事情时,语境却发生了变化。

你提到“说人话”的prompting,这种倒转的要求,其实反映了一个普遍的现象:我们开始期待人类在语言上表现得像 AI 那样简洁、直白、无所顾忌。这和短视频文化也有关系——它强烈影响着我们的语言使用方式。短视频删除了语言的前后文,只输出一个强烈的观点或评价。当我们接受这个内容时,往往不在意大环境或其他复杂因素,只关心“我喜欢”或“不喜欢”,并希望能得到一个明确的表达方式。

如果 AI 与短视频、社交媒体紧密结合,可能会加剧这种趋势。AI 能大量输出这种简化的表达方式,而很多人可能缺乏免疫力,只想要快速、简洁的观点或情感表达。如果 AI 在这种语境中占据主导地位,可能会改变我们对语言、情感和交流的理解。

Fancy:我对这个话题的感受挺复杂的。虽然我自己不怎么看短视频,但我觉得它对我妈妈这样的人所处的群体来说,是有好处的。她60多岁了,除了去老年大学打太极拳,并没有太多娱乐活动,她把抖音当成朋友圈用,在上面和朋友,同事和亲戚们保持联系。因此我虽然想,但不能因此去限制她用抖音。

科技给她们这个群体带来了快乐。她看电影时,如果是原版外语片没有中文配音,她看得很吃力;她搜索的时候是没办法像年轻人一样看浏览器的搜索结果的。但如果问AI,AI 给她提供的简短内容,字大又清晰,她反而很喜欢。有一次,她还给我发了一个用 AI 做的猫咪视频,我家猫老打架,但AI让两只猫亲亲了;尽管AI做的是虚假的,但我妈妈获得的快乐是真实的。

当然另一方面 ,我也很担心她会被AI生成的假消息给诈骗。我父母这代人已经在无意间被 AI 影响了,比如他们搜索就习惯在微信搜索栏搜,但现在微信的搜索栏引用的信源基本来自AI或公众号、微信视频号内容。如果AI的回答是不可靠的,我父母看到回答以为是真的,久而久之假的信息也会变成“真”。他们如何适应这种变化,仍然是我一个很大的忧虑点。

阳少:这个就涉及到事实核查(Fact Check),作为儿女,需要为父母接触到的信息做事实核查。而在公共领域,事实核查指新闻传播领域里针对信息的真实性进行检验。向辉对于AI 时代的事实核查有什么观察吗?

向辉:无论中国还是美国,新闻行业在当前都面临着一定的冲击。假新闻满天飞,造假的成本变低了,事实核查的人力成本在变高。

AI在生成虚假信息、制造谣言方面非常强大,但反过来,它在验证信息时的效率也应该超过人类。例如,当一个信息发布后,往往会生成不同版本,AI能否汇总这些版本,快速识别出一些假新闻的特征,帮助做事实核查的人快速筛选,这从技术上来说是可行的。只是看谁来做,或者以何种方式进行。实现的前提在于,AI必须产品化和开源化,这样大家就能共同参与事实核查。

今天我们讨论了很多关于AI如何撒谎、如何不传递真实的信息。毕竟现在的AI的基础是基于语言的大模型,但就从人的角度来说,语言本身并不总是追求真理或事实的。按照维特根斯坦的理论,求真是一系列特殊的“语言游戏”。在日常交流中,我们并非总是在追求真相与事实,而是为了满足某些目的,即“以言行事”,我们可以用语言模仿、命令、请求、咒骂、夸赞,语言的意义在生活形式和社会之中。所以要在一个语言模型实现求真,难度其实很大。这其实是AI社会化的过程,而非单纯语言层面的挑战。