凤凰网科技讯 2月23日,华尔街日报发文解析,为什么人工智能领域的支出在日益增加。文章认为,尽管投资者曾短暂犹豫,但现在,大型科技公司、政府和风险投资人正以前所未有的速度将资金注入AI领域。要理解这一现象,我们需要深入了解AI技术本身的演变。

从大语言模型到推理模型

传统的大语言模型需要大量的电力和计算时间进行训练。然而,人们正在迅速找到方法,以减少在用户运行大语言模型时所需的资源量。推理模型则不同,它们基于大语言模型,但在实际运行中消耗的资源(包括芯片和电力)要多得多。

自OpenAI在9月发布其首个推理模型o1以来,AI公司纷纷推出竞争产品。其中包括今年年初震撼AI界,改变众多科技和电力公司估值的DeepSeek R1,还有埃隆·马斯克旗下的Grok 3推理模型。

DeepSeek之所以引起恐慌,是因为它展示了一种可能性,即以其他模型成本的一小部分来训练AI。这可能会减少对数据中心和昂贵、先进的芯片的需求。但实际上,DeepSeek推动了AI行业去发展资源需求量更大的推理模型,这意味着基础算力设施仍然非常必要。

推理模型的资源需求

推理模型及其相关产品(如“Deep research”工具和AI agent)为何需要如此多的资源?答案在于它们的工作方式。

Nvidia的AI产品管理副总裁Kari Briski最近表示,推理模型可以轻松消耗超过传统大语言模型100倍的计算资源。这种倍增来自于推理模型在长时间“思维链”中与自己对话(并非所有对话用户都能看到)。模型使用的计算资源与生成的单词数量成正比,因此生成100倍单词的推理模型将使用更多的电力和资源。

当推理模型访问互联网时,资源需求量会进一步增加,如谷歌、OpenAI和Perplexity的Deep research模型。

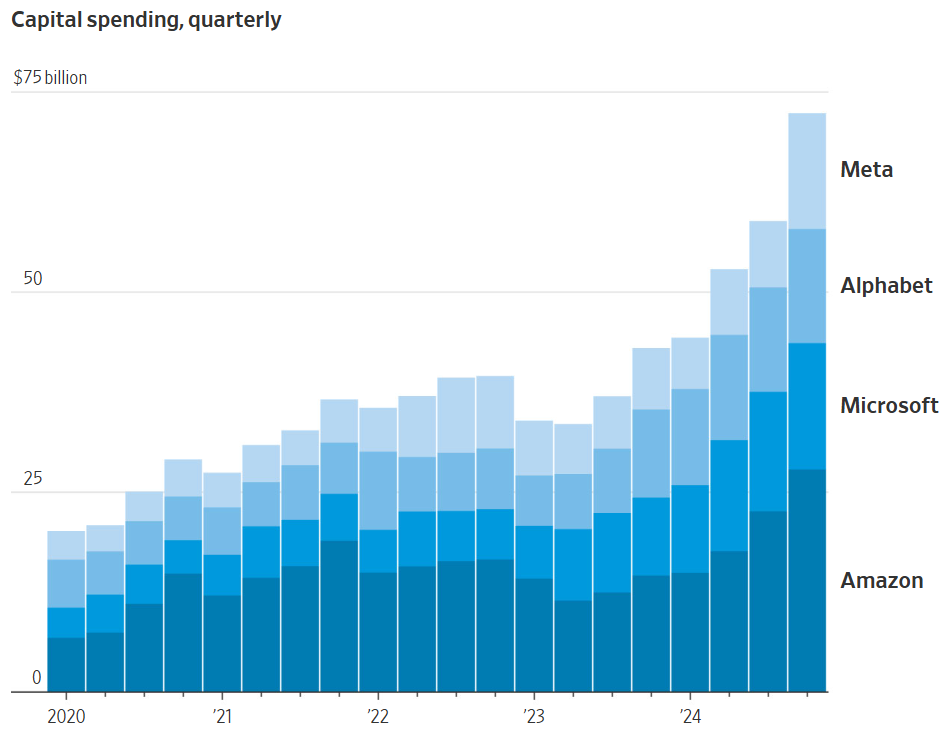

这个数量的资源需求仅仅是开始。谷歌、微软和Meta计划在2025年共同支出至少2150亿美元,比去年增加45%,其中大部分用于AI数据中心。

科技巨头们的季度资本支出

未来AI有多大需求?

为了预测未来AI的需求量,我们可以列出一个简单的等式。等式中的第一个值,是ChatGPT这种大模型处理单个标记所需的计算量。

1月,随着中国AI模型DeepSeek R1的发布,每个标记的成本(包括算力资源和金钱)似乎会大幅下降。DeepSeek及其相关论文展示了一种方法,可以比美国AI实验室先前披露的方法更高效的方式训练和交付AI。

表面上看,这似乎表明AI未来对算力的需求将大大减少,比如为当前的十分之一。但推理模型在“思考”时所增加的需求量会弥补这一点。简单来说,类似DeepSeek的高效AI模型,把对算力的需求减少到十分之一,但如果整个行业对推理模型的需求增加100倍,那么未来AI对算力的需求仍将是现在的10倍。

位于智利圣地亚哥的谷歌数据中心

1000倍增长

随着企业发现新AI模型更强大,它们会越来越多地调用这些模型。这将算力的需求从训练模型转向使用模型,即AI行业中的“推理”。

Baseten的CEO Tuhin Srivastava表示,这种向“推理”的转变已经在进行中。他的客户包括在应用程序和服务中使用AI的科技公司,如Descript和PicnicHealth。这些客户发现,随着对自身产品需求的快速增长,他们需要更多的AI处理能力。

未来几年,技术创新和更先进AI芯片的出现可能意味着,向客户提供AI的系统会比今天高效一千倍。风险投资家Tomasz Tunguz表示,投资者和大型科技公司在赌,未来十年中,由于推理模型和AI的迅速普及,对AI模型的需求可能会增加一万亿倍或更多。

“你键盘上的每一次按键,或你对着麦克风说的每一个音素,都将由至少一个AI转录或处理,”Tunguz说。如果真是这样,他补充道,AI市场可能很快会比今天大1000倍。(作者/陈俊熹)