AI 加速竞赛在科技巨头与初创公司之间愈演愈烈。这边 DeepSeek R1 的诞生引爆全球科技圈,其强大的竞争对手们也没有闲着,先有 OpenAI 加码带来 Deep Search 工具并向所有用户开放 ChatGPT 搜索功能,后有 Google 正式向所有用户推出升级后的 Gemini 2.0 家族,并称其为迄今为止“功能最强大”的 AI 模型套件。

该模型套件包含适用于大规模且高频率任务的 Gemini 2.0 Flash、具有最佳编程性能与处理复杂任务能力的 Gemini 2.0 Pro Experimental 以及极具性价比的 Gemini 2.0 Flash-Lite,还有大幅提升推理能力的 Gemini 2.0 Flash Thinking 模型。

谷歌 DeepMind 首席技术官 Koray Kavukcuoglu 在官方公告的博客文章中写道:“所有这些模型在发布时都将支持多模态输入、文本输出功能,并且未来几个月将有更多模式可供普遍使用。”

不难看出,面对 DeepSeek、OpenAI 等竞争对手的强势攻势,Google 正在加速迎战,全力推动 Gemini 2.0 生态的发展。

01 高效主力模型 Gemini 2.0 Flash 来了

Gemini Flash 系列最早于 Google I/O 2024发布,以高性能、高频任务处理能力受到开发者青睐。

去年 12 月,Google 发布了 Gemini 2.0 Flash 实验版本,正式开启了智能体(Agentic)时代。这个模型专为开发者打造,具备低延迟和高效能的特点。

上周,Google 进一步将升级版 2.0 Flash 推向更广泛的用户,在桌面端和移动端的 Gemini 应用中开放使用,让更多人能够探索 Gemini 的创造力、交互性和协作能力。

时下,Google 通过 Google AI Studio 和 Vertex AI 中的 Gemini API 正式发布更新后的 Gemini 2.0 Flash。

该模型相较竞争对手的一大优势在于上下文窗口,许多主流模型(如上周发布的 OpenAI o3-mini)仅支持 20 万或更少的 tokens,相当于 400 至 500 页的小说,而 Gemini 2.0 Flash 支持高达 100 万 token,能够处理海量信息,尤其适用于高频、大规模任务,在信息整合和长文本理解方面具备明显优势。

开发人员现在可以直接使用 2.0 Flash 构建生产应用程序。这一最新模型在多个关键基准测试中提升了性能。此外,图像生成和文本转语音功能也即将推出。

当下,用户可在 Gemini 应用、Gemini API(Google AI Studio 和 Vertex AI) 中直接上手体验 2.0 Flash。

增强推理能力的 Flash Thinking 模型进入 Gemini App 端

今年年初,Google 在 Google AI Studio 中更新了 Gemini 2.0 Flash Thinking Experimental 模型,经过训练后,该模型会在回答问题时生成其所经历的“思考过程”。因此,与 Gemini 2.0 Flash 模型相比,Flash Thinking 模型在回答问题时能够发挥更强的推理能力。

Google CEO Sundar Pichai 在社交平台 X 上宣布,Google Gemini 移动应用(iOS 和 Android) 已加入了 Gemini 2.0 Flash Thinking 模型,用户可以在模型选择下拉菜单中使用。

简单来看,这款模型能够解释如何回答复杂的问题。

据外媒 Venturebeat 分析,事实上,DeepSeek R1 和 OpenAI 新推出的 o3-mini 模型都不支持多模态输入,也就是说,它们无法直接处理图片、文件上传或附件。虽然 R1 在官网和移动端应用的聊天界面中可以接收这些输入,但它只是通过光学字符识别(OCR)——一种已有 60 多年历史的技术——提取文本信息,并不会真正理解或分析图片中的其他内容。

然而,DeepSeek R1、OpenAI o3-mini 这两个模型都属于新一类的“推理”模型,会花更多时间思考答案,注重“思维链”(chain-of-thought)和回答的正确性。这与典型的大型语言模型(LLM),如 Gemini 2.0 Pro 系列,有着明显区别。

因此,将 Gemini 2.0、DeepSeek-R1 和 OpenAI o3 进行直接对比,实际上有些“鸡蛋与苹果”的意味。

不过,当前 Google 还会推出一款更具自主智能的 Gemini 2.0 Flash Thinking 模型版本,它可以连接 Google 地图、YouTube 和 Google 搜索,拓展了 AI 研究和交互的可能性,而没有这些生态支持的 DeepSeek 和 OpenAI,短期内难以匹敌。

Gemini 2.0 Pro(实验版):最强代码能力与复杂任务处理

对于需要更高级 AI 功能的用户,Gemini 2.0 Pro(实验版)模型现已可供测试。

Google 表示,Gemini 2.0 Pro Experimental 是迄今为止最强的代码性能和复杂任务处理模型,在理解和推理世界知识方面超越了以往所有版本。其特点包括:

超大上下文窗口:支持 200 万 token,可处理海量信息,深入分析复杂问题。

工具调用能力:可调用 Google Search 进行实时信息查询,并支持代码执行,提升编程能力。

目前,Gemini 2.0 Pro(实验版) 已在 Google AI Studio、Vertex AI 开放给开发者,并可在 Gemini 高级版(Gemini Advanced) 的桌面和移动端模型选择菜单中使用。

Gemini 2.0 Flash-Lite(公测版):Google 成本最低的模型

此前,Gemini 1.5 Flash 以其高速度、低成本深受用户喜爱,而 Google 进一步优化质量,同时保持相同的成本和速度,推出了全新的 Gemini 2.0 Flash-Lite,旨在提供经济高效的 AI 解决方案,同时不影响质量。

Gemini 2.0 Flash-Lite 具备百万 tokens 上下文窗口,支持多模态输入,类似于完整的 Flash 模型。

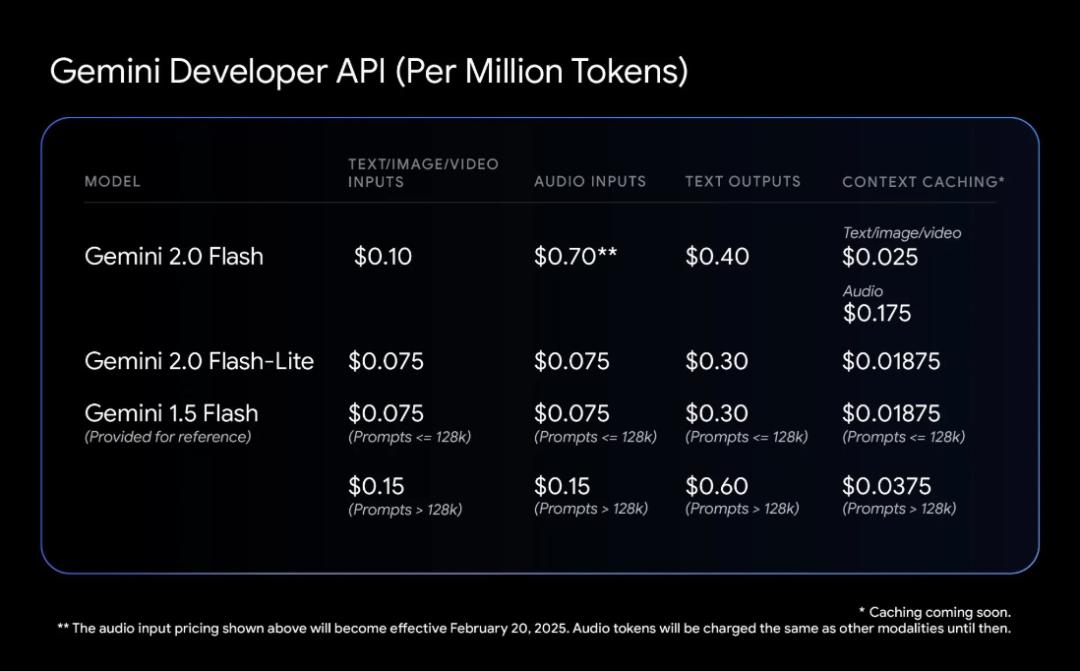

同时与其他主流 LLM API 相比,Gemini 2.0 Flash 的定价极具竞争力。Gemini 2.0 Flash-Lite 的价格为每百万代币 0.075 美元(输入)和每百万代币 0.30 美元(输出),而其他一些主流模型如:

OpenAI 4o-mini:每百万 tokens 输入/输出费用分别为 $0.15 / $0.6

Anthropic Claude:每百万 tokens 输入/输出费用高达 $0.8 / $4

DeepSeek V3(传统 LLM):每百万 tokens 输入/输出费用为 $0.14 / $0.28

相比之下,Gemini 2.0 Flash 在性价比方面更胜一筹,且在大多数基准测试中均优于 Gemini 1.5 Flash,根据官方数据显示,该模型可以为大约 40,000 张独特的照片生成相关的一行标题,在 Google AI Studio 的付费套餐中成本不到 1 美元,这也使得它成为市场上最具吸引力的 LLM 选择之一。

对此,Google AI Studio 负责人 Logan Kilpatrick 在 X 上强调,“Gemini 2.0 Flash 是目前所有 LLM 中最具价值的选择,现在是时候开始构建了!”

目前,Flash-Lite 可通过 Google AI Studio 和 Vertex AI 进行公开预览,预计将在未来几周内全面上市。

最后

以上便是 Google 此次带来的重点大模型更新。在模型的安全方面,Google 也分享了其最新投入,他们利用:

强化学习优化:使用 Gemini 自身来评估和改进其回答,提升对敏感问题的处理能力,确保输出更加准确、合理。

自动化红队测试:评估安全风险,尤其是间接提示注入(Indirect Prompt Injection) 等网络安全攻击,防止恶意指令被 AI 误用。