最近这段时间,美国股票市场的动静比较大。有两个科技股概念,突然变得很火,引起了市场的高度关注,涨幅惊人。这两个概念,分别是 ASIC 和量子计算。

今天这篇文章,我们主要说说 ASIC。

按资本市场的说法,ASIC 正在加速崛起,威胁 GPU 在 AI 计算中的统治地位。而博通,作为 ASIC 最重要的概念股,股价一路猛涨,一度从 180 飙到了 250,市值也突破了万亿美元。相比之下,英伟达反而成了昨日黄花,股价一路下跌,甚至不到 130 美元。

那么,ASIC 时代真的到来了吗?博通真的会取代英伟达,成为新的 AI 之王?

█ ASIC 和 GPU 是什么

ASIC 和 GPU,都是用于计算功能的半导体芯片。因为都可以用于 AI 计算,所以也被称为“AI 芯片”。

准确来说,除了它俩,计算芯片还包括大家更熟悉的 CPU,以及 FPGA。

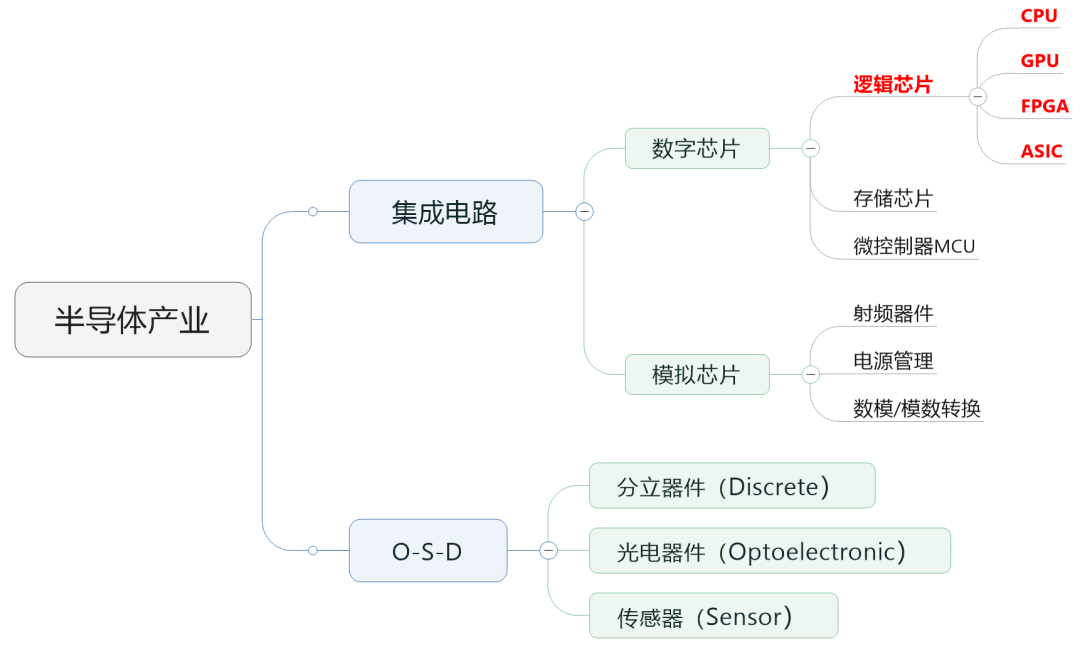

行业里,通常会把半导体芯片分为数字芯片和模拟芯片。其中,数字芯片的市场规模占比较大,达到 70% 左右。

数字芯片,还可以进一步细分,分为:逻辑芯片、存储芯片以及微控制单元(MCU)。CPU、GPU、FPGA、ASIC,全部都属于逻辑芯片。

逻辑芯片,就是计算芯片。它包含了各种逻辑门电路,可以实现运算与逻辑判断功能。

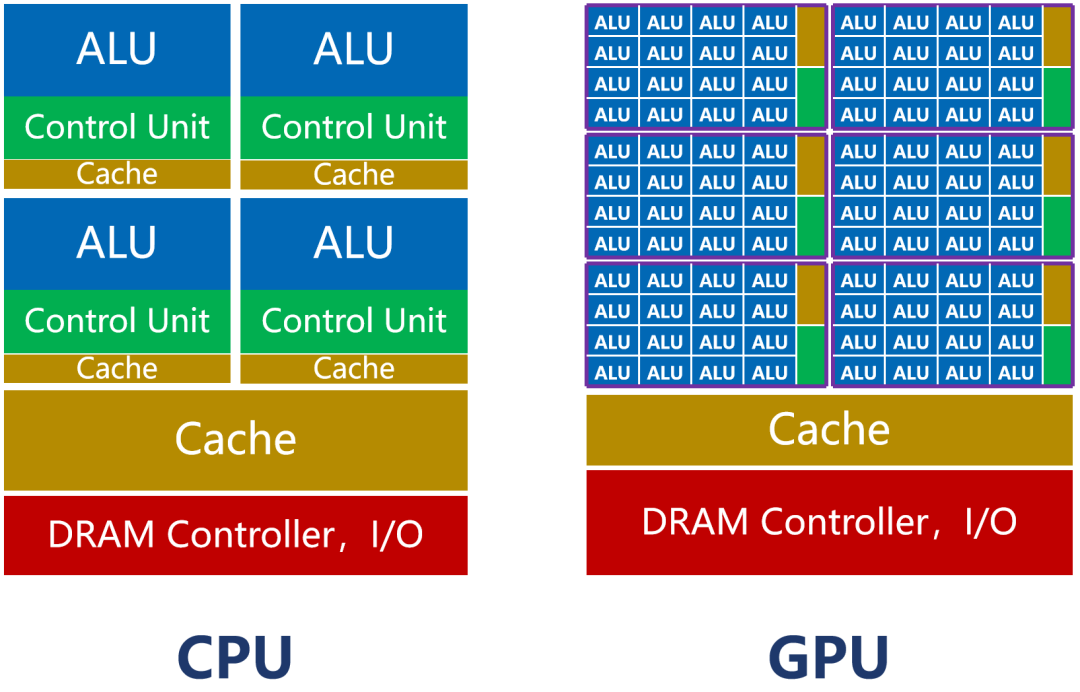

四个芯片里,CPU 和 GPU 是通用芯片,可以完成多种任务。尤其是 CPU,是全能型选手,单核主频高,啥都能干,所以经常被拿来做主处理器。

而 GPU,本来是用来做图形处理(显卡)的。它的内核数量特别多(大几千个),适合做并行计算,也就是擅长同时做大量的简单计算任务。(图形处理,就是同时处理大量的像素计算。)

AI 计算和图形计算一样,也是典型的并行计算型任务。

AI 计算中包括大量并行的矩阵相乘、卷积、循环层、梯度运算等任务,所以,特别适合 GPU 去完成。CPU 不适合 AI 计算,这也是英特尔股价跌到 20 美元以下的原因之一。

2023 年以来,AI 浪潮爆发,大部分企业的 AI 训练,采用的是英伟达的 GPU 集群。如果进行合理优化,一块 GPU 卡,可以提供相当于数十其至上百台 CPU 服务器的算力。这直接导致了英伟达的股价猛涨了几十倍,而且还买不到。

再来看看 ASIC 和 FPGA。

ASIC(Application Specific Integrated Circuit,专用集成电路),是一种专用于特定任务的芯片。ASIC 的官方定义,是指:应特定用户的要求,或特定电子系统的需要,专门设计、制造的集成电路。

Google 公司大名鼎鼎的 TPU(Tensor Processing Unit,张量处理单元),还有前几年很火的比特币矿机,英特尔的 Gaudi 2 ASIC 芯片,IBM 的 AIU,AWS 的 Trainium,都属于 ASIC 芯片。

这几年非常火的 DPU(Data Processing Unit,数据处理单元)和 NPU(Neural Processing Unit,神经网络处理单元),也是 ASIC 芯片。

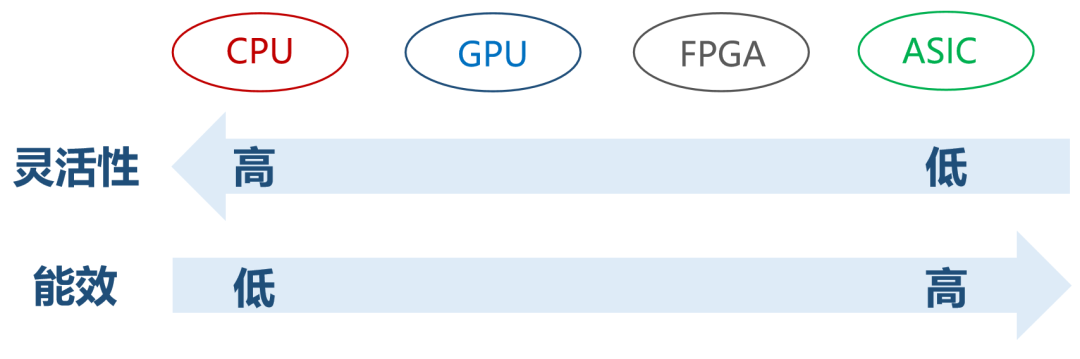

FPGA(Field Programmable Gate Array,现场可编程门阵列),是半定制芯片,也被人称为“万能芯片”。FPGA 可以根据用户的需要,在制造后,进行无限次数的重复编程,以实现想要的数字逻辑功能。

ASIC 和 FPGA 的区别在于,AISC 是全定制芯片,功能写死,没办法改。而 FPGA 是半定制芯片,功能灵活,可玩性强。FPGA 不需要流片(很烧钱的一个工序),但因为可编辑,冗余功能比较多,一旦用于单一目的,就会存在浪费。大规模生产的情况下,FPGA 的成本比 ASIC 高,且极致能效不如 ASIC。

所以,FPGA 现在多用于产品原型的开发、设计迭代,以及一些低产量的特定应用,或者用于培训和教学。它适合那些开发周期必须短的产品,也经常用于 ASIC 的验证。

反正,大家记住,大规模出货用于 AI 计算,一般不考虑 FPGA。

所以,AI 芯片,也就是 GPU 和 ASIC 之争。

█ GPU 和 ASIC,到底谁厉害?

ASIC 作为专用定制芯片,基于芯片所面向的专项任务。它的计算能力和计算效率都是严格匹配于任务算法的。芯片的核心数量,逻辑计算单元和控制单元比例,以及缓存等,整个芯片架构,也是精确定制的。

所以,ASIC 可以实现极致的体积、功耗。这类芯片的可靠性、保密性、算力、能效,都会比通用芯片(GPU)更强。

例如,在同等预算下,AWS 的 Trainium 2(ASIC 芯片)可以比英伟达的 H100 GPU 更快速完成推理任务,且性价比提高了 30-40%。明年计划推出的 Trainium3,计算性能更是提高了 2 倍,能效提高 40%。

但是,为什么这两年一直火的都是 GPU 呢?

主要是因为英伟达太猛。

英伟达在 AI 上也是歪打正着。当年 AI 大佬辛顿(就是那个新晋诺贝尔奖得主)带着徒弟使用 GPU 做 AI 训练,获得巨大突破,才让英伟达发现自己竟然还有这样的泼天富贵。

然后,英伟达就开始在 AI 发力,拼命做更厉害的 GPU(当然,也有游戏的带动)。

在英伟达的持续努力下,GPU 的核心数和工作频率一直在提升,芯片面积也越来越大。算力越强,有利于缩短训练时间,加快产品发布,这也是重要优势。

当然,算力变强,功耗也水涨船高。但是,靠工艺制程、水冷等被动散热,勉强也能兜得住,反正不会烧掉。

除了硬件之外,英伟达在软件和生态方面也很会布局。

他们捣鼓出来的 CUDA(AI 开发的软件套件),是 GPU 的一个核心竞争力。基于 CUDA,初学者都可以很快上手。所以,英伟达的 GPU 方案,被全球用户广泛接受,形成了牢固的生态。

相比之下,FPGA 和 ASIC 的开发还是太过复杂,不适合普及。

ASIC 之所以在 AI 上干不过 GPU,和它的高昂成本、超长开发周期、巨大开发风险有很大关系。现在 AI 算法变化很快,ASIC 这种开发周期,很要命。

综合上述原因,GPU 才有了现在的大好局面。

值得一提的是,前面说了,AI 计算分为训练和推理两种。训练任务,需要更强大的算力,所以在 AI 训练上,厂商们主要以 GPU 为主。

推理任务的话,算力要求要低一点,也不需要什么并行,所以 GPU 的算力优势没那么明显。很多企业,就会开始采用更便宜、更省电的 FPGA 或 ASIC,进行计算。

这个情况,一直持续到了现在。AI 芯片,GPU 的占比能达到 70% 以上。

如今,因为大家实在是“苦英伟达久矣”,不想总被英伟达“卡脖子”,所以非常希望算力多元化。再有,大模型现在从“训练热”走向了“推理热”。推理类的 AI 计算需求增加,给了 ASIC 机会。

所以,扶持 ASIC 产业链,提升 ASIC 芯片在 AI 领域的占有率,成为了大家的共识。这才有了博通和 Marvell 股价的猛涨。(据说,博通正与三个大型客户开发 AI 芯片,预计 2025 年 AI 芯片业务收入达到 150 亿-200 亿美元。)

那么,取代就真的那么容易吗?ASIC 会很快淘汰掉 GPU 吗?

显然不是的。

凭借前面提到的性能、生态、集成能力等方面的优势,英伟达的 GPU 仍然会是中短期内的 AI 芯片首选。英伟达的软硬件网络整套方案都很成熟,技术和资金实力太强,GPU 的存量和出货量依然很大,市场地位难以撼动。

ASIC 的崛起速度虽然很快,但仍需要一定的时间走向成熟。AI ASIC 芯片的研发,也具有很高的风险。即使研发成功,也需要时间被用户所接受。

这就意味着,在很长的一段时间内,GPU 和 ASIC 都将处于共存状态。基于不同的场景,用户会选择最适合自己的芯片。发展自研 ASIC,更多是有利于厂商们和英伟达进行谈判砍价。

未来的情况还是比较难预测的。量子计算是不是会对计算领域造成颠覆式影响,现在也是讨论的热点。

好了,以上就是今天文章的全部内容。感谢大家的耐心阅读!

本文来自微信公众号:鲜枣课堂(ID:xzclasscom),作者:小枣君