OpenAI公布了o3,相比o1实现了一次阶跃,在编程、数学、科学等一系列基准测试中成为学霸中的学霸。特别是在ARC-AGI的测试中取得了大幅度的突破。是否意味着2025年人类可以看到AGI的曙光?我们在这里编译了ARC-AGI测试标准的创始人撰写的o3测评的报告。原标题OpenAI o3 Breakthrough High Score on ARC-AGI-Pub。

正文如下:

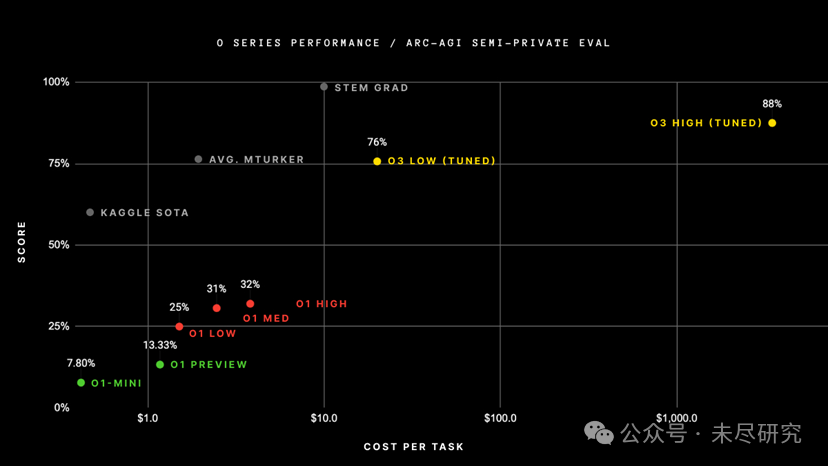

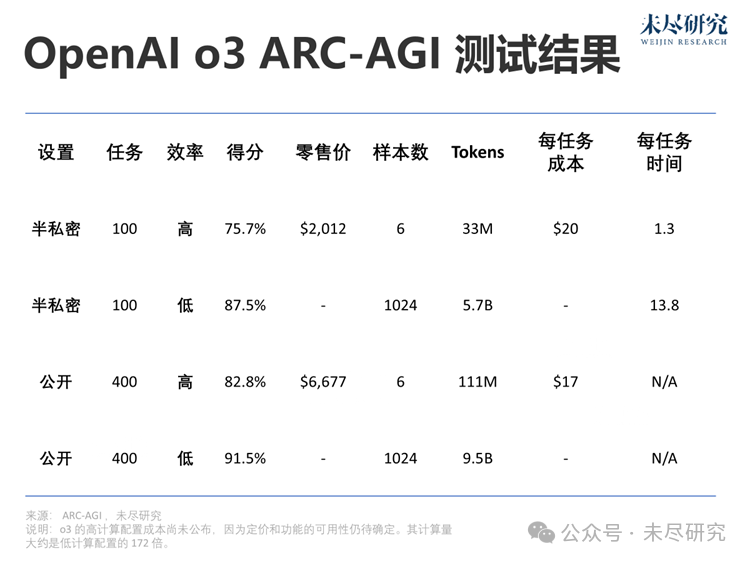

OpenAI训练新o3系统,使用了ARC-AGI-1公共训练数据集,在我们的公开排行榜上,以$10k的计算成本限制,在半私密评估数据集上取得了突破性的75.7%得分。而高计算配置(172倍计算量)的o3系统则达到了87.5%的得分。

每次任务的成本,来源:ARC Prize

这标志着AI能力的一次重要的阶跃式提升,令人惊喜地展现了此前GPT系列模型从未具备的新型任务适应能力。相比之下,ARC-AGI-1从2020年的GPT-3的0%进步到2024年GPT-4o的5%,用了整整四年。为了o3,我们对AI能力的所有直觉都需要刷新。

ARC奖的使命不仅限于做第一个基准测试:它是通向AGI的北极星。我们很高兴明年能继续与OpenAI团队以及其他伙伴合作,共同设计下一代、可持续的AGI基准测试。

ARC-AGI-2(相同的测试格式——经验证对人类容易但对AI更难)将与2025年ARC奖同步推出。我们承诺将持续运行大奖赛,直到创造出一种高效的开源解决方案,得分达到85%。

下面请看完整测试报告。

OpenAI o3 ARC-AGI测试结果

我们对o3系统进行了两组ARC-AGI数据集的测试:

半私密评估:100个私密任务,用于评估过拟合情况

公开评估:400个公开任务

根据OpenAI的指示,我们在两种计算规模下进行了测试,用了不同的采样规模:6(高效率)和1024(低效率,计算量为172倍)。

以下是测试结果。

由于推理预算的差异,效率(例如计算成本)现在成为报告性能时的必需指标。我们记录了总成本和每个任务的成本,作为效率的初步衡量标准。整个行业需要共同探讨哪种指标最能体现效率,但以成本为起点是一个不错的选择。

在高效率模式下,得分75.7%符合ARC-AGI公共评估的预算规则(成本< $10k),因此在公共排行榜上获得了第一名!

在低效率模式下,得分87.5%尽管成本高昂,但依然表明性能在计算资源增加的情况下有所提升(至少到这一水平为止)。

尽管每个任务的成本显著,这些成绩并非仅仅是通过“暴力计算”达成的。OpenAI的新o3模型在AI适应新任务的能力上取得了重大飞跃。这不仅是渐进式的改进,而是一次真正的突破,标志着AI能力相较于之前的大语言模型实现了质的飞跃。o3是一个能够适应前所未见任务的系统,可以说在ARC-AGI领域接近了人类的表现水平。

当然,这种通用性需要付出高昂代价,目前尚未具备经济性:让人类解决ARC-AGI任务的成本大约为每个任务$5(是的,我们试过),而能源消耗仅需几美分。而o3在低计算模式下每个任务需要$17~20。不过,成本性能在未来几个月到几年内可能会显著改善,因此我们应预计这些能力将在较短的时间内与人类劳动竞争。

o3在GPT系列上的改进证明了架构的重要性。即便给GPT-4投入更多计算资源,也无法获得这样的结果。仅仅通过从2019年到2023年所采用的方法进行简单的扩展——例如采用相同架构,训练更大的版本,使用更多数据——已经不足以推动进一步的进展。未来的突破将依赖于全新的理念。

那么,o3是AGI吗?

ARC-AGI是一个关键的基准,用于检测AI的重大突破,特别是在泛化能力方面,这些是其他已经饱和或要求较低的基准无法展示的。然而,需要明确的是,ARC-AGI并不是AGI的“酸性测试”,这一点我们今年已经重复多次。它是一个研究工具,旨在将注意力集中在AI中最具挑战性的未解决问题上,并在过去五年里很好地履行了这一角色。

通过ARC-AGI并不等同于实现AGI。实际上,我认为o3还不是AGI。o3在一些非常简单的任务上仍然会失败,这表明它与人类智能存在根本性的差异。

此外,早期数据表明,即将推出的ARC-AGI-2基准对o3来说仍将是一个重大挑战,即使在高计算模式下,其得分可能会降至30%以下(而一个聪明的人类无需训练仍然可以获得95%以上的分数)。这表明我们仍然可以创建具有挑战性、未饱和的基准,而无需依赖专家领域知识。只有当设计那些对普通人类来说简单但对AI困难的任务变得完全不可能时,你才会知道AGI真正到来了。

o3与旧模型有何不同?

为什么o3的得分远高于o1?为什么o1的得分又远高于GPT-4o?我认为这一系列结果为AGI的研究提供了宝贵的数据点。

我对LLM的心理模型是,它们像是一个向量程序的存储库。输入提示后,它们会把提示映射的程序提取出来,并对依据前输入“执行”该程序。LLM通过被动接触人类生成内容来存储和操作化数百万个有用的小程序。

这种“记忆、提取、应用”范式在适当的训练数据支持下,可以在任意任务上达到相应水平的技能,但它无法适应新颖性或随时学习新技能(也就是说,它缺乏流体智能)。这一点在LLM在ARC-AGI基准上的表现不佳——GPT-3的得分为0,GPT-4接近0,GPT-4o达到5%。即使将这些模型扩展到极限,也无法使ARC-AGI的得分接近几年前基本的暴力枚举法所能达到的50%。

要适应新颖性,需要两个条件:首先是知识,即一组可重用的函数或程序,LLM已经具备足够多的这类知识。其次是能力,能够在面对新任务时将这些函数重新组合成一个全新的程序——即任务建模。这就是程序合成,而LLM长期以来缺乏这一特性。o系列模型解决了这一问题。

目前我们只能推测o3的具体工作机制。但核心机制似乎是在token空间的自然语言程序的搜索和执行:在测试阶段,模型会在可能的思维链(CoT)空间中搜索,描述解决任务所需的步骤,其方法可能与AlphaZero风格的蒙特卡洛树搜索类似。在o3的情况下,这种搜索似乎由某种评估模型引导。值得注意的是,哈萨比斯(Demis Hassabis)在2023年6月的采访中曾暗示DeepMind正在研究这一想法——这条研究路线已经酝酿许久。

因此,尽管单代的LLM在面对新任务时表现不佳,o3通过生成并执行自己的程序克服了这一障碍,在这里程序本身(CoT)成为知识重新组合的产物。虽然这并不是测试阶段知识重新组合的唯一可行方法(你还可以进行测试阶段的训练,或在潜在空间中搜索),但根据新的ARC-AGI数据,这代表了当前的最先进水平。

从本质上来说,o3代表了一种基于深度学习引导的程序搜索形式。该模型在测试时会在“程序空间”(在此案例中是指自然语言程序——描述解决当前任务步骤的思维链(CoTs)空间)中进行搜索,这一过程由深度学习先验(基础LLM)引导。解决一个ARC-AGI任务之所以可能需要数千万个tokens并花费数千美元,是因为这个搜索过程需要探索程序空间中的大量路径——包括回溯。

然而,这里发生的事情与我之前描述的“基于深度学习引导的程序搜索”作为通向AGI的最佳路径之间存在两个重要区别。关键在于,o3生成的程序是自然语言指令(由LLM“执行”),而不是可执行的符号化程序。这带来两个后果:

1. 这些程序无法通过直接执行和任务直接评估与现实接触——它们只能通过另一个模型来进行适应性评估,但这种评估由于缺乏直接的任务基础,可能在分布外操作时出错。

2. 系统无法自主获得生成和评估这些程序的能力(不像AlphaZero等系统可以通过自我学习掌握棋类游戏)。相反,它依赖于专家标注的人类生成的CoT数据。

目前尚不清楚这一新系统的具体局限性是什么,以及它的扩展能力有多大。我们需要进一步测试才能得出结论。不过,当前的性能代表了一项非凡的成就,也明确证明了直觉引导的测试时程序空间搜索是一种强大的范式,能够构建适应各种任务的AI系统。

接下来是什么?

首先,通过ARC奖竞赛在2025年促进o3的开源复现将是推动研究社区前进的关键。需要对o3的优势和局限性进行彻底分析,以理解其扩展行为、潜在瓶颈的性质,并预测未来发展可能解锁的能力。

此外,ARC-AGI-1现在已经接近饱和——除了o3的新得分,事实上,一个由低计算资源的Kaggle解决方案组成的大型集成体现在都可以在私密评估中达到81%的得分。

我们计划通过一个新版本提高标准,ARC-AGI-2自2022年开始研发,承诺对当前的最先进技术进行一次重置。我们的目标是通过难度大、信号强的评估推动AGI研究的边界,并突出AI的当前局限性。

ARC-AGI-2的早期测试表明,即使对o3来说,这也将是非常具有挑战性的。当然,ARC奖的目标是通过大奖赛生成一个高效的开源解决方案。我们目前计划在2025年ARC奖推出时同步发布ARC-AGI-2(预计在第一季度末发布)。

展望未来,ARC奖基金会将继续创建新的基准测试,以将研究人员的注意力集中在通往AGI的最难解决的问题上。我们已经开始研究第三代基准测试,该基准测试完全脱离了2019年ARC-AGI的格式,并融入了一些令人兴奋的新想法。

作者François Chollet曾在谷歌从事AI研究9年。2019年,他发布了通用人工智能抽象与推理语料库(ARC-AGI)基准,衡量人工智能系统解决新颖推理问题的能力。