曾经在国内风评两极分化的Manus,近日被曝出在国外拿到了7500万美元的新一轮融资,估值近5亿美元。

这时,距离Manus发布还不到两个月。

3月6日,顶着全球首款通用AI智能体的头衔,Manus正式对外发布。

作为初代AI智能体,Manus可以自主调用互联网工具,自主执行诸如文章和研报编写、PPT制作等工作。

不过,Manus后来卷入套壳风波,行业风评不及预计……

实际上,Manus真正的价值不在于它拥有多强大的功能,而是它在适当的时间打开了AI智能体的这扇大门。

更重要的是,Manus验证了研发AI智能体的模型上下文协议的可行性。

模型上下文协议MCP,由此也成了被视为AI智能体元年的2025年的“开年第一课”。

01 “叛逃者”的胜利时刻

2024年11月25日,差不多是ChatGPT发布两周年之际,OpenAI的“劲敌”,也是OpenAI“出逃”的前员工们创办的大模型独角兽企业Anthropic在官网发布了一篇博客。

在这篇博客中,Anthropic官方向公众介绍了一个刚刚开源的大模型协议,模型上下文协议MCP。

一个程序员的新时代就此悄悄开启。

什么是MCP?

Anthropic在开源文档中给出了这样一个比喻:

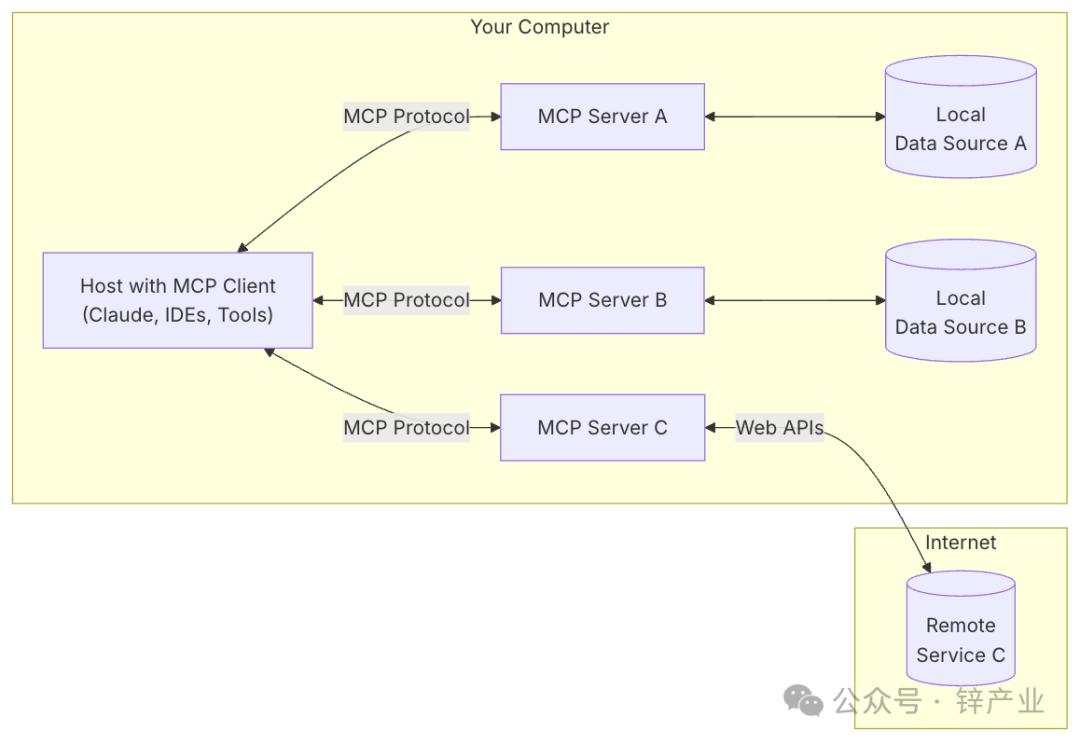

就像USB-C提供了一种标准化方式将你的电脑连接到各种外围设备和配件一样,MCP规范了应用程序向大模型提供上下文的方式,提供了一种将AI模型连接到不同数据源和工具的标准化方式。

说得再简单一点就是,MCP是打通大模型与应用程序之间的标准化开源协议。

有了MCP,你就可以让大模型调用外部其它互联网应用和工具,自动执行各类任务了。

这与互联网软件、移动应用的工作和研发逻辑有几分相似,实则正是现在AI智能体的开发逻辑。

不过,这并不是大模型应用开发的开端,任何技术的成熟都不是一蹴而就的,MCP同样不是。

在Anthropic开源MCP之前,这套工作流还经历了一系列重要开发和降本过程。

OpenAI是ChatGPT的创造者,也是大模型始作俑者,作为推动OpenAI从非盈利组织转型为一家以盈利为目的的公司的Sam Altman,自然不会只是让ChatGPT停留在一直烧钱与用户对话这件事上。

Sam Altman应该也一直在思考,如何让大模型跨过商业鸿沟,从引领一次技术革命跨越到真正革新商业秩序。

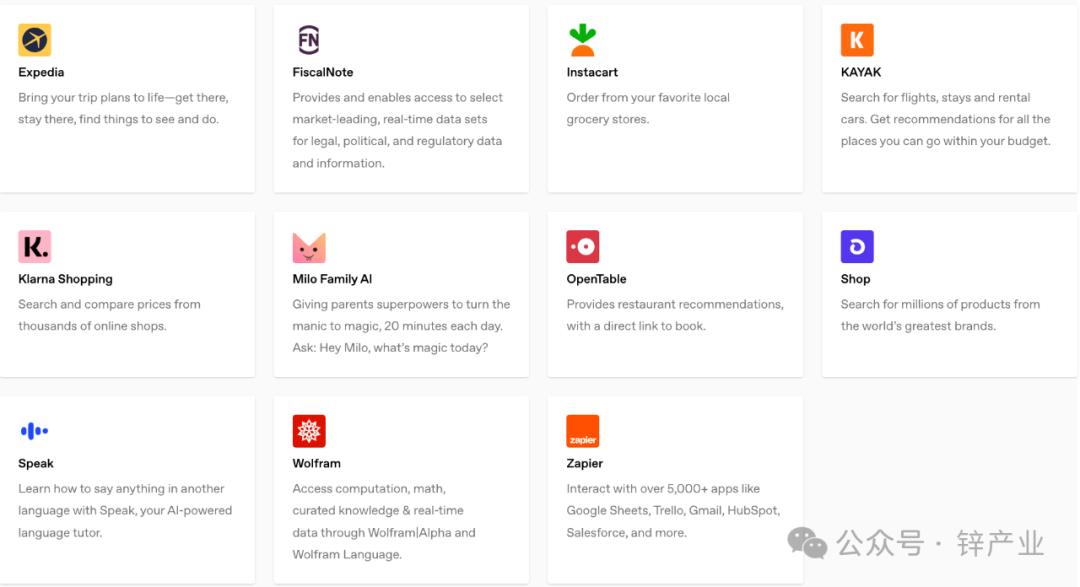

于是,在ChatGPT推出三四个月后,熟悉互联网发展史,以及浏览器和搜索引擎的Sam Altman为大模型搞出了一个略显复古的功能,插件。

2023年3月23日,OpenAI在对外发布的一篇博客中,正式官宣推出ChatGPT Plugins,也就是ChatGPT插件。

在这篇博客中,OpenAI官方介绍透露:

Plugins是专为ChatGPT设计的访问最新信息、使用第三方服务的工具,我们在ChatGPT中已经初步实现了对Plugins的支持。

Plugins出现的目的,是让ChatGPT能够连通互联网数据、打通互联网服务,在更广泛的真实世界中得以使用,有点互联网世界里的具身智能的意思。

在这之后,关于大模型调用外部工具这项技术,又经历了一番迭代:

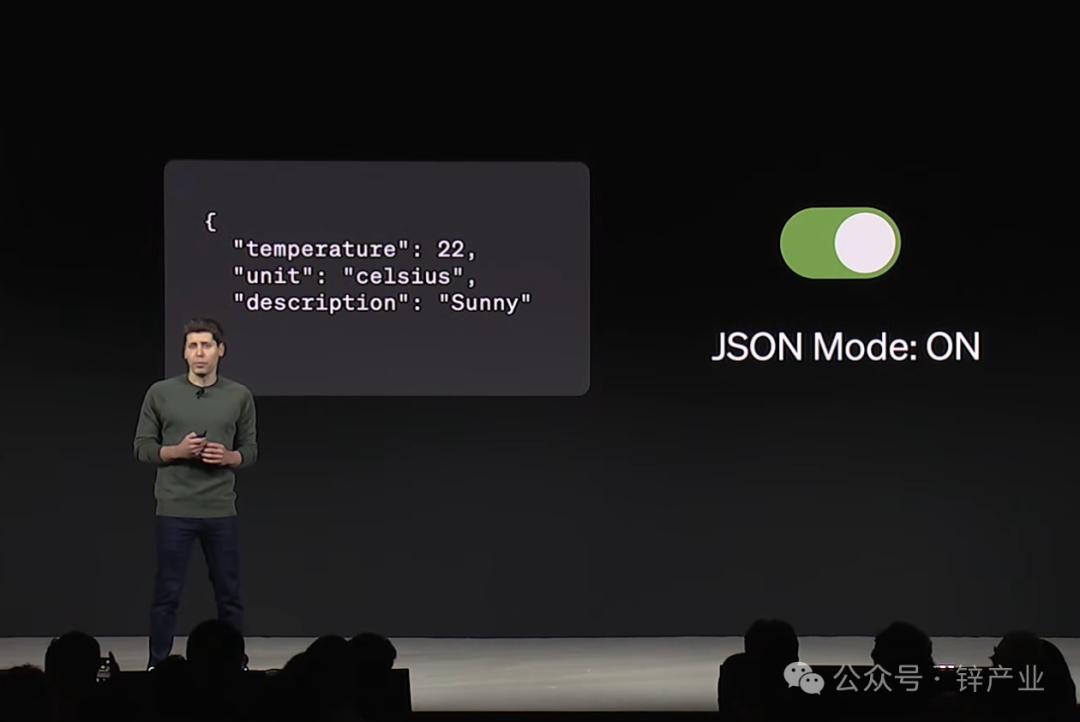

2023年6月,OpenAI发布GPT-4,与之一同发布的还有名为Function calling的功能,这一功能允许开发者让大模型通过JSON指令调用外部工具。

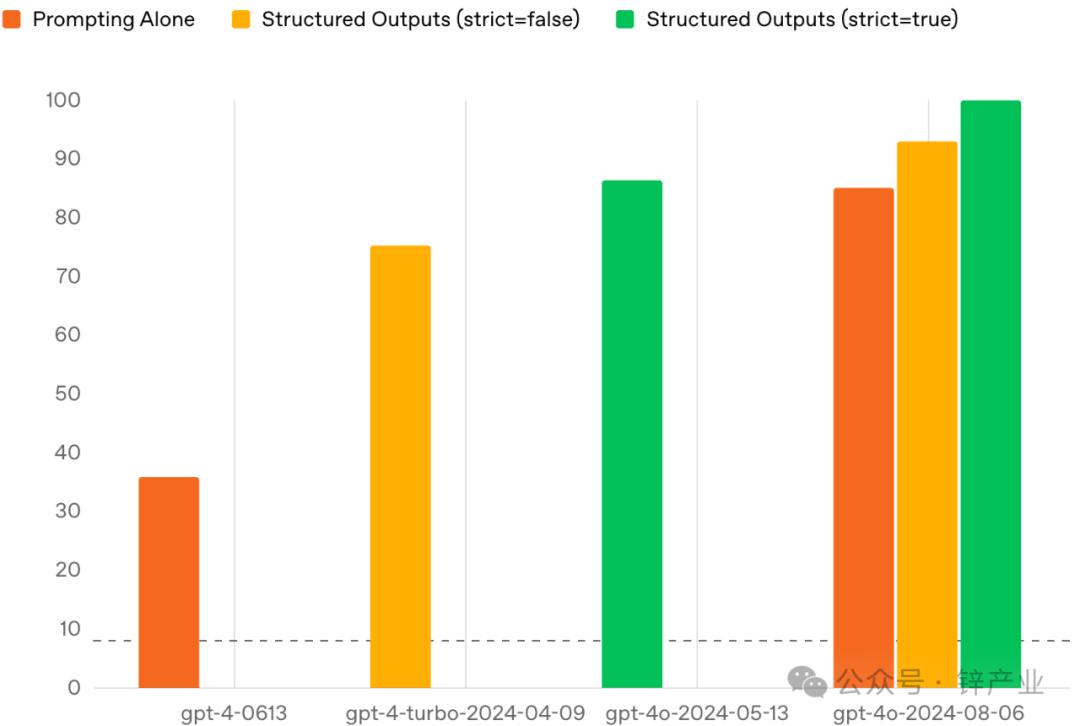

然而由于当时即便GPT-4这样聪明的大模型,通过Function calling进行工具调用的成功率还不足40%,响应速度极为缓慢,大模型的使用成本在当时还居高不下,这使得Function calling功能并未得到广泛推广,但让AI开发者们有了大模型可以进行工具调用这个意识。

2023年11月,OpenAI第一次面向全球召开开发者大会,大会上,OpenAI除了对外发布了GPT-4 Turbo、GPTs外,一个让开发者更兴奋的发布是JSON mode,广大AI开发者们终于可以让大模型输出JSON文件,并基于此进行函数调用。

2024年8月,OpenAI在官方博客上正式对外发布了结构化输出——Structured Outputs,在Function calling阶段不足40%的结构化信息输出和工具调用成功率,在这个阶段终于将成功率进化到了100%。

OpenAI“结构化输出”功能的引入,实则已经标志着大模型拥有了稳定调用外部工具的能力,也标志着AI智能体的爆发。

只不过,后来Anthropic惊艳一时的Claude 3.5 Sonnet和computer use,以及顶着首个通用AI智能体的名头的Manus,将开源MCP推向了潮头。

02 接入MCP,巨头们的不得不

2024年1月10日,北京时间1月11日凌晨,OpenAI在官方博客再次发布更新,万众期待的GPT应用商店(GPT store)正式上线。

GPT store的上线,意味着大模型已经从技术演进,转向与生态扩容并行。

不过,在生态建设上更着急、跑得更快的其实是,害怕走向平庸、紧跟科技潮流的互联网巨头们。

投资了OpenAI的微软就是这样一个颇具忧患意识的科技巨头,微软早在2023年5月的开发者大会上,就通过Bing与ChatGPT的插件功能共享,以及自己天然的搜索引擎和浏览器阵地优势,打造起了大模型插件生态。

本就更卷的国内互联网巨头自然也不会放过这个机会。

阿里魔搭、百度千帆先后成为国内版大模型应用商店,到被阿里、百度等视为AI智能体元年的2025年,MCP也再次成了BAT等国内互联网巨头快速跟进的又一战略方向。

在4月9日的AI势能大会上,阿里云刘伟光称,“2025年,一定是中国AI应用爆发的元年,一定是AI智能体爆发的一年。”

与此同时,刘伟光还在大会上官宣,自4月9日起,阿里百炼平台全面支持MCP服务部署和调用。

在这之后,阿里魔搭社区上线MCP广场,包括支撑阿里另一个重要应用生态的支付宝官宣上线MCP服务,这意味着AI智能体开发者可以直接通过MCP协议调用支付宝,在AI智能体中实现支付功能的闭环。

而就在今天(4月29日)凌晨官宣发布的开源大模型Qwen3,同样支持MCP协议来调用Qwen-Agent内置工具,以及开发者集成的其它工具。

在4月25日的百度开发者大会上,李彦宏称,“MCP是AI发展的一大步,现在基于MCP开发智能体,就像2010年开发移动APP。”

在大会上,李彦宏还官宣了百度千帆全面兼容MCP,可以提供大量第三方MCP服务,也支持开发者创建和发布MCP。

此外,百度搜索、百度地图、百度网盘、百度文库,甚至就连百度文心大模型的联网搜索工具也成了百度搜索的MCP服务供开发者调用。

支持并接入MCP,成了押注大模型的互联网巨头今年在兼容DeepSeek后,另一件必须做的事。

大模型生态由此也从各自为战在协议层面开始走向统一,为接下来AI智能体的爆发时刻做好准备。

03 AI应用没有“护城河”

在刚刚过去这两个月里,“老实人”朱啸虎的两个言论在社会层面引起了广泛讨论:

一个是上篇文章我们提到过的“看不到具身智能或人形机器人商业化潜力”;

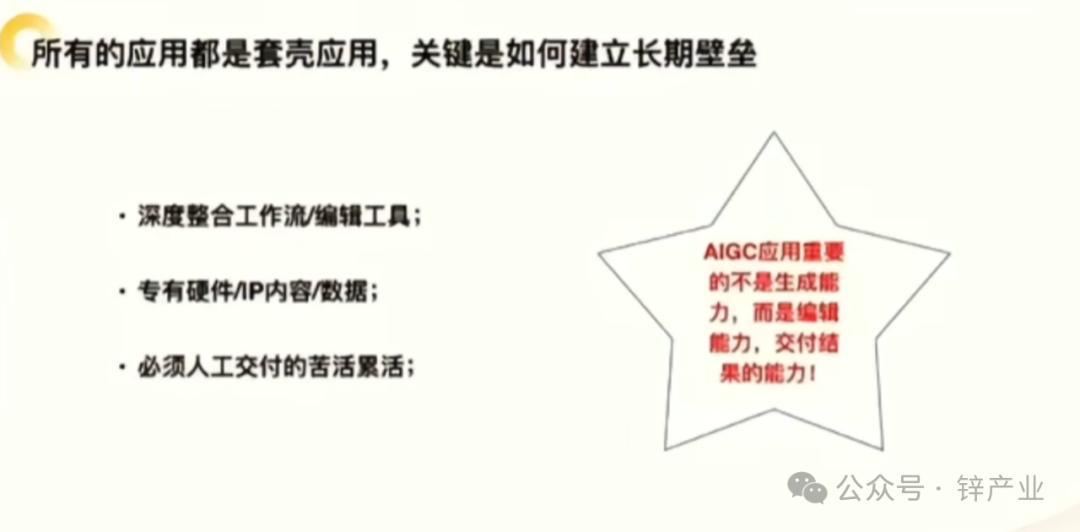

另一个则是“AI应用没有护城河”。

就在前不久的2025中关村论坛年会上,这位知名投资人针对如今爆火的AI应用和AI智能体指出:

“AI应用没有技术壁垒,说有壁垒都是忽悠人的,要在非AI能力上建立壁垒,这些非AI能力来自于互联网大厂不愿意干的、必须由人工交付的苦活累活。”

在朱啸虎发表这番言论前,3月6日凌晨,一家名为「蝴蝶效应」的武汉创业公司官宣了全球首款通用AI智能体Manus的发布,而在Manus发布后不久,就陷入了套壳风波。

关于Manus的产品逻辑,Manus创始人肖弘在接受媒体采访时曾指出:

“我记得很清楚,在3、4月份的时候,我发现全球范围内除了ChatGPT以外,增长最快的(大模型产品)居然是Poe,而Poe是套壳的集大成者,所以我当时就和我的投资人说:套壳到极致就是牛,我们也套壳吧。”

那么,Manus究竟套了谁的“壳”呢?

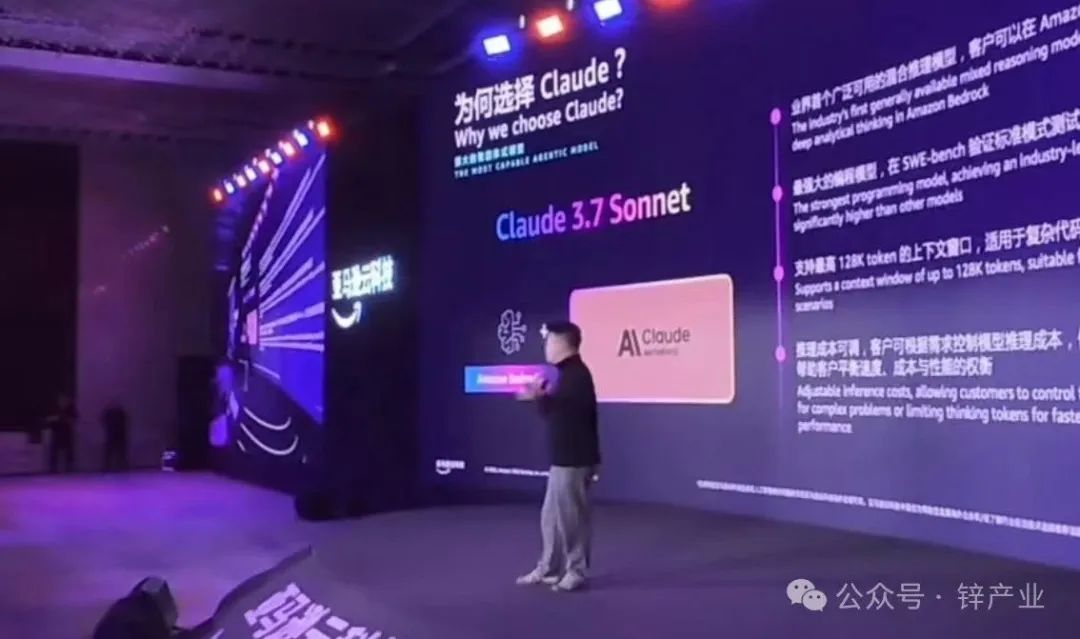

Manus另一位联合创始人张涛在亚马逊云科技大会上透露,Manus的底层模型选用了Claude。

张涛指出,“市面上大部分大模型面向的都是chatbot场景,在这个场景中,绝大多数大模型的训练目标是希望可以在一轮对话中解决问题,如果用这类大模型做智能体,你会发现它特别着急,特别希望很快给你答案,但智能体需要搜索、读文章、重新思考、写代码……,很难在一轮对话中给你答案。”

正因如此,张涛认为,目前市面上最适合做智能体的大模型是Claude 3.7 Sonnet。

近日,据彭博社报道,Manus在国外已经拿到了7500万美元的新一轮融资,估值高达5亿美元。

在套壳风波之后,Manus已经成为2025年AI智能体的第一个受益者,而就在MCP成为全球AI智能体构建的事实标准时,下半年大模型将会呈现出两个趋势:

第一,Anthropic行业地位将继续攀升,成为OpenAI最头疼的劲敌;

第二,可以调用各类应用、能够真实做事儿的AI智能体将大量涌现,一个新的AI智能体生态正在开启。