2025年蛇年春晚,舞台上出现了一幕令人眼前一亮的场景:一群机器人带来了一场别开生面的扭秧歌表演,吸引了全球观众的目光。在张艺谋导演的《秧BOT》节目中,这些机器人身着东北特色的花棉袄,随着音乐节奏翩翩起舞,动作精准流畅,手中的手绢转得虎虎生风,与人类舞者相比也毫不逊色。

这些惊艳众人的机器人,来自杭州的一家具身智能创业公司。它们的亮相,不仅向全球观众展示了中国具身智能机器人技术的飞速发展,更引发了人们对具身智能机器人产业的广泛关注与深入思考。

具身智能机器人,作为人工智能与物理世界深度融合的结晶,正逐步成为未来科技发展的关键方向。清华大学全球创新学院院长、自动化系教授兼博导刘云浩在其新书《具身智能:人工智能的下一个浪潮》中,以通俗易懂的方式剖析了什么是具身智能,以及如何实现从人工智能到具身智能的跨越。

如何使机器“自然地做到”

小狗在草地上欢快地奔跑,小鸟在空中飞翔,这些行为都不需要动物的大脑进行复杂计算或过度努力。但要想让机器人能做到跑步、跳跃,那可就费劲了。首先,智能体需要准确地感知环境和对象的状态,这包括对象的位置、大小、形状和纹理等信息;其次,智能体需要根据感知到的信息进行运动规划,计算出如何移动自己的关节和肢体,以实现预期的动作;最后,智能体需要精确地执行这些动作,这不仅要求其对关节和肢体的控制精度,还要求其能够适应环境的变化和不确定性。你看看波士顿动力—这家公司花了数十年的时间在工程研究、机械设计、传感器集成以及算法开发上,才使得其机器人能在高度控制的实验室条件下实现类似动物包括人类的奔跑、跳跃。

在我们的日常生活中,很多看似简单的任务如切菜、刮胡子、整理收纳等,人工智能都没能很好地完成,一个不小心智能体还会掉入所谓的“恐怖谷”。这个术语描述了当机器人或仿生对象接近但尚未达到与真实人类或其他生物无法区分的程度时,引起的不适感或恐惧。

这是因为,日常任务虽然对人类来说轻而易举,但对机器人来说却涉及复杂的运动控制和精细的感知能力。例如,切菜不仅需要根据食物的硬度、形状和纹理调整力度和切割角度,还需要避免切到手,也不能造成不必要的浪费;刮胡子则要求机器人能够精准识别脸部轮廓,轻柔而有效地去除毛发,同时避免刮伤皮肤;整理收纳则涉及对物品的识别、分类和空间规划,需要机器人具备一定的空间智能和组织能力。

这也揭示了具身智能发展过程中的重大瓶颈—如何使机器不仅能“做到”这些动作,而且能够像生物那样“自然地做到”。

“具身智能”由两个词组成,一个是“具身”,一个是“智能”。我们先来说“具身”。

动物尤其是人类能够做到运动控制,需要一个复杂而精细的过程,它涉及神经系统、肌肉系统以及感觉系统的协同工作。运动控制的核心在于神经系统与肌肉系统的协同作用。神经系统通过发出电信号来控制肌肉的收缩和放松,从而实现各种动作做到运动控制是由演化决定的。

对于智能机器,我们希望其行动能够做到准确、迅捷、协调。可是,要让机器变得如此灵巧,又谈何容易?

从维纳的控制论开始,行为主义在这一领域做了大量的工作。时至今日,从波士顿动力翻跟头的机器人到穿街走巷的无人驾驶汽车,从流水线上组装零件的机械臂到夜空中飞舞盘旋组成各种图案的无人机集群,我们已经目睹了大量灵巧的智能机器。

但是我们仍然不满足,因为这种灵巧还不够“通用”,还有很多任务做得并不好,就连最普通的家务,目前也并没有哪一款智能机器能够包揽并达到商用的程度。

那么,这些任务到底难在哪里呢?交互是关键。在没有外界交互的情况下,对智能机器的控制已经得到了广泛的研究并取得了显著成果。但一旦牵涉与环境的交互,机器行动的难度便急剧上升。摆在交互面前的三座大山分别是“对象”、“环境”和“动态性”。

首先来看交互的对象。对象的类型无穷无尽,可能是一件衣服、一个柜子、一座山、一片海、一个人或者另一台机器。每个对象都有其独特的属性和特性,我们与它们互动时的体验和需求也截然不同。比如,雕刻木头与堆雪人所需的技巧大相径庭,抓住水杯与拿起豆腐所需的力度迥异,拧开药瓶盖与打开微波炉门的动作也各有不同。

其次是交互的环境。物理世界中的交互总是发生在复杂纷繁的环境当中,充满了各种噪声和干扰。以晾衣服这一简单任务为例,我们需要在可能的风力干扰下,从一堆洗净的衣物中挑选一件并将其固定到晾衣架上。对于无人驾驶汽车而言,雨雪天气、道路障碍物等都可能对其行动造成重大影响。

最后是交互的动态性。交互的过程往往充满了动态性,交互对象的变化、环境的变化等都无法在行动之初就确定下来,甚至这些动态性也会导致行动的阶段性目标发生变化,进而需要智能机器及时进行调整。

不过,当我们将视角转向较为简单可控的环境,针对少数对象的交互时,现代智能机器已经展现出了卓越的成就。例如,在生产线上,焊接机器人面对的交互对象和环境在一定时期内是恒定的,因此即便需要快速完成多个焊点,这些机器人也能精准高效地完成任务。

事实上,就重复性工作效率和精准度而言,机器已经超越了人类。再如,就乒乓球这项对人类运动控制能力要求极高的运动而言,在我们将交互环境限定于固定的球台一侧、将对象仅限于球拍和球之后,智能机器已经能够与人对战,展现出不俗的技艺。

知者敏于行

面对交互之难,到底该如何提升智能机器的行动能力呢?“头痛灸头,脚痛灸脚”历来饱受诟病。要想解决交互中的挑战,除了提升控制算法和执行器的物理性能(这些内容在其他教材或文献中已有广泛讨论),我们还需要聚焦于“知”的深度与广度。这里的“知”,涵盖了从感知到认知的完整过程,即我们对行动主体与客体的全面理解。

该怎么提升“知”的深度与广度?还是从我们最熟悉的人类来入手进行分析。人类之所以能拥有卓越的行动能力,并非仅因肢体结构的复杂性,更在于我们拥有强大的感官和神经系统。例如,我们用刀切肉时,首先是通过视觉给出的信息将其定位到正确的位置和姿态,然后结合视觉以及握持刀柄的手传来的触觉信号来决定施加多少力度和施力的方向。而如果我们假设执行者是一个仅具备视觉传感器的智能机器,当肉里面有一块骨头时,它就很难做出快速而准确的响应了。

人的手部皮肤能够感知到痛觉、温度觉、振动觉、移动性触觉、恒定性触觉等多种信息,包含17000多个触觉小体,能够实现细粒度精确的触觉感知。在这方面,当前的智能机器显然存在极大不足。

因此,我们要发挥具身智能特有的优势。虽然智能机器人没有那么多神经和感官,但是它的形态和感知能力也同样不受基因限制。事实上,人短时间内不可能在脑袋后面进化出一双眼睛,但是让智能机器拥有“脑后眼”并非奇事,因此它们能在不受传统感官局限的情况下,探索一个更广阔的感知世界。

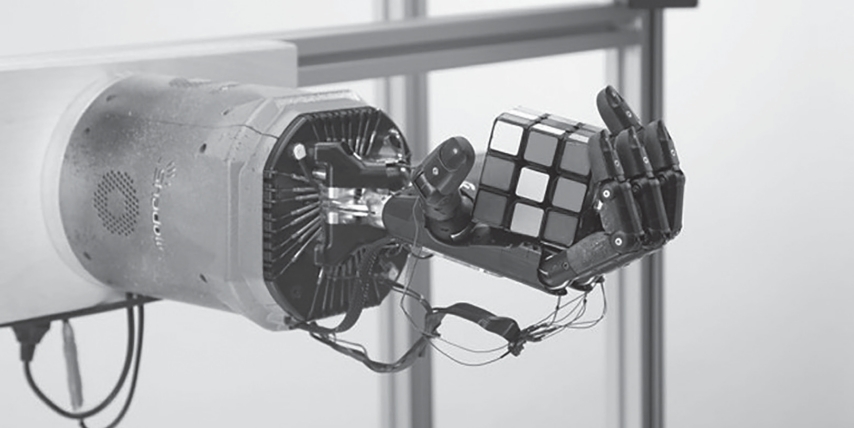

例如,魔方是一种很多人喜欢的益智类玩具,但是恢复魔方对很多没有经过专门练习的人来说很不容易。就算经过一定学习,以我本人来说,也需要3分钟左右。OpenAI在2019年发布了一个用机械手解魔方的系统。研究人员为了测试机械手的极限,不仅要求其单手完成复原,还在实验中设置了多重障碍:戴上橡胶手套,部分手指被绑住,甚至还有一只长颈鹿走过来干扰。尽管面临这些挑战,系统仍然展现出了卓越的鲁棒性。

图:OpenAI发布的用机械手解魔方的系统

这个用来玩魔方的机械手,来自ShadowRobot(英国暗影机器人公司)的ShadowDexterousHand(灵巧手),它被安装在一个装备有RGB摄像头和PhaseSpace动作捕捉系统的方形笼中。其控制策略基于强化学习,以机械手的手指当前位置和魔方的状态为输入,输出机械手下一步的动作。在OpenAI公开的一个视频中,机械手在约4分钟的时间里成功还原了一个三阶魔方。魔方的状态通过三个不同角度的摄像头来估计,而机械手指尖的位置则通过3D(三维)动作捕捉系统追踪。这个系统展示了一个核心理念:尽管只有一只机械手在执行动作,但其感知能力却遍布整个空间。机器能够随时给自己选配很多强大的感官。例如在自动驾驶汽车上,最新的激光雷达已经能够实现超过百米范围的高精度三维扫描,热成像传感器也能够让机器在黑夜里发现有温度的目标。这同样带来一个新的问题,即如何使多种感官能够很好地协同工作。人类的感官融合是长久以来的进化结果,而在这方面,机器智能刚刚起步。

DenseFusion采用了一个创新的异构网络架构,能分别处理RGB和深度数据。这种设计使各种数据能保留其原始结构,而不是简单地将它们融合为单一通道。在单独处理完数据后,DenseFusion首先对两种数据分别进行预处理,然后使用一个密集融合神经网络进行整合,使得模型在保持数据结构的同时,有效地利用RGB和深度数据的互补性。

提出TAVI(TactileAdaptationfromVisualIncentives,从视觉激励中触觉适应)这一新框架的作者认为,仅依靠现有智能机器的触觉感知无法提供足够的线索来推理物体的空间配置,这限制了纠正错误和适应变化情况的能力。因此,他们提出可以通过使用基于视觉的奖励来优化灵巧策略,从而增强基于触觉的灵巧性。

机器也不是一直都能够打“富裕仗”,在很多应用场景中,由于受到体积、成本等诸多方面的限制,智能体必须学会充分利用有限的感知数据。

抓取是具身智能体一项基础而复杂的能力,它要求精准控制力度,以避免物体受损或滑落。不同的物体需要不同的抓取策略:滑溜的陶瓷杯和粗糙的橡胶球,它们的抓取方式截然不同(毕竟我可不希望自己精心淘来的卡洛曼设计的咖啡壶被打碎)。AnyGrasp就提出一种新的用于抓取的感知技术,让机械夹爪能够对大量堆叠的、形状不规则的、没有见过的物体进行稳定抓取操作。感知部件仅为一台普通的深度相机。得益于对大量真实世界数据的学习,机器能够主动避开障碍并且通过感知零件的质心以提高稳定性,这两项特性在人类的视觉抓取行为中是经常能够看到的。而在另一项研究中,Takahashi等人提出了一种通过图像来估计触觉特性的方法,这对于具身智能体与环境的交互至关重要。例如,如果智能体通过视觉观察到某物体表面比较滑腻,它可能会采取更紧的抓握方式以防滑脱。

除了提升感知能力,如何使机器具备真正的认知能力也是目前具身智能研究的前沿,包括图灵奖得主杨立昆近期提出的关于世界模型的理论在内,大量的工作正围绕这一问题展开。

智能化熵增与具身导航

互联网和物联网时代,连接已经深入人们的生活,网络变得无处不在。你也许会疑惑:连接不就是交换信息吗?它如何能够影响认知甚至是推动智能发展呢?

1.连接传递认知。

当没有连接的时候,感知以及认知是如何达成的呢?靠的是观察和猜测。没错,人类做判断的过程本质上也是一种猜测,即根据观察到的某种信号并结合自己的认知进行猜测。很显然,感知是有盲点和误差的,认知也存在局限和错误。我们的视觉可能会被遮挡,看到的也可能不是真相。比如,同样是在昏暗中看到模糊的身影,有的人可能会因为恐惧或迷信而认为这是“鬼魂”;而另一些人则可能基于理性分析,认为这不过是光影效果或视觉错觉造成的“正常现象”。

所以,假设智能机器的任务是从一堆水果当中寻找1个苹果,它必须努力克服遮挡的影响来寻找苹果的特征,然后发现了一个非常相似的目标,但这可能是一个外表非常相似的塑料苹果。智能机器将其抓起来后甚至可能发现重量也和真的苹果差不多,于是只能考虑闻闻味道(如果配备了嗅觉传感器的话)或者切开再继续观察。单方面的感知或者认知总是困难重重。

如果智能机器能够与所有交互对象建立连接,那么它们的行动是否将变得更加简单和直接?

在这一点上,智能机器和人类相比反而更具有优势。人类主要的交流方式是语言,且不说和一块石头交流,就算是跨省的方言我们可能都听不懂,因此人类与外界的交流很多时候还要借助智能机器。而反观机器,从连接的媒介(无线信号、声音信号、光信号)、连接的“语言”(协议)、连接的带宽等多个方面来看,都要强大很多。

另外,多个智能机器之间可以比人类更充分地共享它们的认知,这样每一个机器都能够获得更多的信息,有利于规划自身的行动。这样的群体智能显然超越了个体智能。

2.连接创造认知。

除了传递认知,连接本身也创造了认知。连接的载体即各种信号本身就是能够被感知并且被认知的,它们携带着物理世界的印记,赋予我们丰富的信息。

例如,在无线导航的研究中,我们利用无线信号的强度与距离的相关性估计距离。通常,距离的测量依赖专门的感知模块,如尺子或激光测距仪,而无线信号的距离估计能力是连接本身所固有的。更进一步,通过观察无线信号的相位变化,我们曾经提出过一种精度达到毫米级的定位技术,比同期技术的定位精度提高了40倍。

无线信号的相位变化还可以用来感知高频率的振动,这对于实时监控机器设备的状态至关重要。最常见的无线信号还能够赋予机器“透视”的能力。比如,我们平时使用的Wi-Fi路由器就能够穿墙透视,让我们“看到”墙后的人。这听起来像是某种“超能力”,但实际上,通过分析Wi-Fi信号的微妙变化,科学家确实已经能够探测到墙壁另一侧人体的移动。

这种连接的建立本身就是一种认知成果。它不仅代表着物理上的临近和可达性,我们还可以通过这些连接所形成的网络构建起一种拓扑图,反映实体间的相互关系和连接的复杂性。举例来说,社交网络中的六度分隔理论揭示了人类社会关系的紧密程度。它告诉我们,任何两个陌生人之间最多只隔着6个人。这个理论也反映了通过连接可以实现认知扩展。在机器的世界里,类似的原理可以应用于物联网设备,它们通过无线信号相互连接,形成一个庞大的感知网络,使得每台设备都能够感知到网络中其他设备的状态和位置。

在这种方式下,连接不仅是信息传递的媒介,还是智能系统认知世界的一种方式。

3.连接影响智能分布。

在生物出现在地球上之前,智能如同沉睡的种子,尚未萌芽。随着时间的推移,植物和动物逐渐演化,最终,人类以独特的智慧在生命之林中脱颖而出,智能就此出现。智能的集中赋予了人类无与伦比的地位。人类不仅成为探索这个世界的主导者,更成为塑造这个世界的主要力量。

随着信息技术革命尤其是人工智能的发展,智能机器诞生并开始辅助人类。互联网和物联网的普及正在改变这种不均匀的智能分布。借鉴信息论中熵的概念,我们可以把这种现象称为“智能化熵增”。如果智能与非智能界限分明,我们认为熵较低;反之,如果智能遍布世界的每个角落,我们认为智能化熵在增加。

例如,一台终端设备本身运算能力可能有限,但一旦联网,它就能从云服务器获得强大的算力和知识,从而增强自身的能力。也就是说,智能化熵增降低了智能机器对自身固有感知和认知的依赖。

我们还是回到具身导航的例子。一辆无人驾驶汽车利用自身携带的摄像头、激光雷达、无线模块感知周围的环境,做出加速、减速、变道、超车等行动。在传统的导航中,路径规划和行动决策依赖于提前获取的地图,通过卫星信号等方式定位,引导汽车行动,不断缩短当前位置与目的地之间的距离。汽车如果具备感知周围环境的能力,就不一定需要把自己映射到地图上才能导航。我们指路的时候,也很少直接指定几个坐标地点,更常见的方式是“往前走两个红绿灯,左转前行,看到路左边一个商场,右边的白色写字楼就是目的地”。这样的导航,完全是依赖感知进行路径引导的。我们可以证明,感知数据所构成的感知空间,也符合线性空间的基本定义。只要定义恰当的距离函数(数学称为范数),就可以让感知空间和物理空间保持尺度不变性:物理空间远的,感知空间也远;物理空间近的,感知空间也近。如何定义恰当的范数,就完全是一个数学上的技巧了。实际上,我们都知道物理空间是三维的,而感知空间是远远高于三维的线性空间,这就让我们有很多的数学技巧可以施展,以通过优化实现感知空间和物理空间的一致性,即“感知空间—物理空间”一致性理论。

我们还可以有一些其他的推论,比如:感知空间是一个完备的赋范线性空间(数学上称为巴拿赫空间);存在感知子空间与物理空间同构,两者存在单一映射关系;物理空间的移动,可以被该感知子空间的时间函数唯一描述;物理空间任两点之间的距离函数,等于该感知子空间像的距离函数;等等。这些推论表明,在物理空间内进行导航,等价于在感知空间内进行导航。也许有一天我们的导航完全是在感知空间内进行的,只是通过具身智能体表现为在物理空间中的移动。

在实际场景中,感知空间的维度太高,计算复杂度也过高。即使是最聪明的无人驾驶汽车,我们也经常会在新闻中看到它们在路上踯躅不前。而有了车联网之后,单体智能逐渐走向群体智能,车辆之间通过连接实现了信息的共享,使行动决策变得更为简单高效。2024年1月,五部委联合发布的《关于开展智能网联汽车“车路云一体化”应用试点工作的通知》,使得这个连接的范围进一步扩展到了云端、道路单元。试着想一下,数百米外的交通事故被道路单元发现并通知给即将驶来的车辆,这是任何老司机都没办法做到的。一辆无人驾驶汽车驶进停车场后,也不必到处转悠找车位了,停车场会直接给出空位的指引,然后车子自己就倒车入库了。是不是很便利,也很自然?

从另一个维度审视智能化的演进,我们不难发现,随着智能化熵的增加,智能体的边界正在逐渐消融。这种转变意味着,机器不再局限于其物理形态,而是开始将外部环境融入其智能系统的内部。这就像是将外部世界变成了智能体的延伸,将原本的外部行动转化为了内部的自然交互。先是人驾驶车辆,然后是智能机器驾驶车辆,而在未来,我们把道路及车辆的集合看作一个具身智能体,也就是由道路来开车。道路能够全面感知其上的一切情况,掌握所有车辆的实时动态,从“上帝视角”出发,进行全局的交通调控。在这样的未来,交通事故或许真的只存在于历史之中了。