当前的 AI 领域,可以说 Transformer 与扩散模型是最热门的模型架构。也因此,有不少研究团队都在尝试将这两种架构融合到一起,以两者之长探索新一代的模型范式,比如我们之前报道过的 LLaDA。不过,之前这些成果都还只是研究探索,并未真正实现大规模应用。

今天凌晨,首个商业级扩散大型语言模型(dLLM)来了!该模型名为 Mercury,其表现非常卓越,在英伟达 H100 上能以每秒超过 1000 token 的速度运行,同时性能也并不比现有的经过速度优化的 LLM 差。

下面是官方展示的一个对比示例。让一个自回归 LLM 与 Mercury 编写一个 LLM 推理函数。自回归模型迭代了 75 次,而这个 dLLM 却仅迭代了 14 次就完成了任务,速度要快得多。

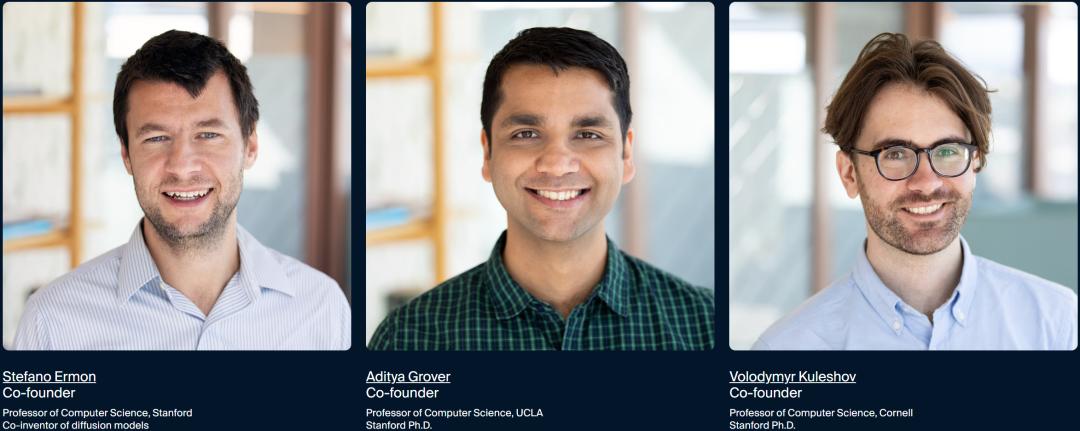

打造 Mercury 系列模型的是一家创业公司,名为 Inception Labs,该公司的创始人之一 Stefano Ermon 实际上也正是扩散模型(diffusion model)的发明者之一,同时他也是 FlashAttention 原始论文的作者之一。Aditya Grover 和 Volodymyr Kuleshov 皆博士毕业于斯坦福大学,后分别在加利福尼亚大学洛杉矶分校和康乃尔大学任计算机科学教授。

Inception Labs 今天发布的 Mercury 具有巨大的性能和效率优势,据 Kuleshov 推文介绍,基于来自 MidJourney 和 Sora 等图像和视频生成系统的灵感,该公司为 Mercury 引入了一种新的语言生成方法。相比于现有的 LLM,这种方法的运行效率显著更高(速度更快、成本更低),并且还可将推理成本降低 10 倍。

性能表现上,Mercury 系列中的编程模型 Mercury Coder 可比肩 Claude Haiku 和 GPT4o-mini 等针对速度指标优化过的前沿模型。但是,它的硬件效率要高得多,因为它使用了利用 GPU 的并行生成机制。这使得模型能以远远更快的速度和更低的成本运行(可以在同样的硬件上为更多用户提供服务)。

目前 Mercury Coder 已上线,可公开试用。该公司表示还可为企业用户提供代码和通用模型的 API 和内部部署服务。

试用地址:https://chat.inceptionlabs.ai

如此高效且达到商业级的新型语言模型自然吸引了不少关注,著名 AI 研究科学家 Andrej Karpathy 发帖阐述了这项成果的意义。他表示,不同传统的自回归 LLM(即从左到右预测 token),扩散模型是一次性向所有方向进行预测 —— 从噪声开始,逐渐去噪成 token 流。虽然之前的研究似乎表明文本好像更适合自回归范式,而扩散模型更适合图像与视频,但业界对此其实并没有定论。而这项研究更进一步表明,扩散模型在文本模态上也具有极大的潜力。

下面我们就来看看 Mercury 究竟是怎么打造的及其实际表现。

让扩散模型驱动下一代 LLM

当前的 LLM 都是自回归模型,也就是说它们是从左到右生成文本,一次生成一个 token。

这种生成过程本质上是顺序式的 —— 在生成某个 token 之前,必须先生成它之前的所有文本。而每个 token 的生成都需要评估一个包含数十亿参数的神经网络。前沿的 LLM 公司正在研究通过测试时计算来提高模型的推理和纠错能力,但生成长推理轨迹的代价是推理成本的急剧上升和更长的延迟。为了使高质量的 AI 解决方案真正普及,需要进行范式转变。

而扩散模型提供了这样的范式转变。

扩散模型的生成过程是「从粗到细」,即输出是从纯噪声开始的,然后通过一系列「去噪」步骤逐步细化。

由于扩散模型不受到仅考虑之前输出的限制,因此它们在推理和结构化响应方面表现更好。而且,由于扩散模型可以不断细化其输出,它们能够纠正错误和幻觉。因此,扩散模型是当前所有主要的视频、图像和音频领域的生成式 AI 的基础,包括 Sora、Midjourney 和 Riffusion。然而,扩散模型在文本和代码等离散数据上的应用从未成功过。而现在,情况变了。

Mercury Coder:每秒 1000+ Tokens

Mercury Coder 是 Inception Labs 向公众开放的第一个 dLLM。

它将 AI 能力推向了另一个高度:比当前一代的语言模型快 5 到 10 倍,并能够以低成本提供高质量的响应。

dLLM 作为典型自回归 LLM 的直接替代品,其支持很多用例,包括 RAG、工具使用和智能体工作流。

其工作流程是这样的,当接收到查询提示时,它并不是逐 token 生成答案,而是以「从粗到细」的方式生成。对答案的改进是由一个神经网络提供 —— 在文章示例中是一个 Transformer 模型 —— 在大量数据上进行了训练,并通过并行修改多个 token 来提高答案的质量。

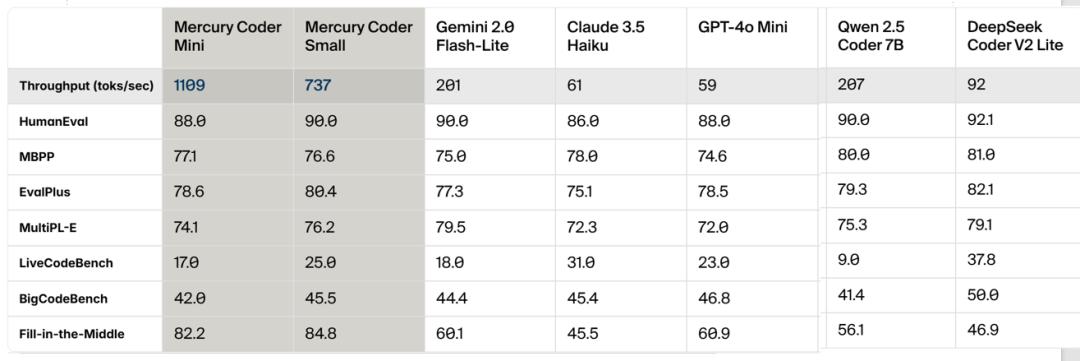

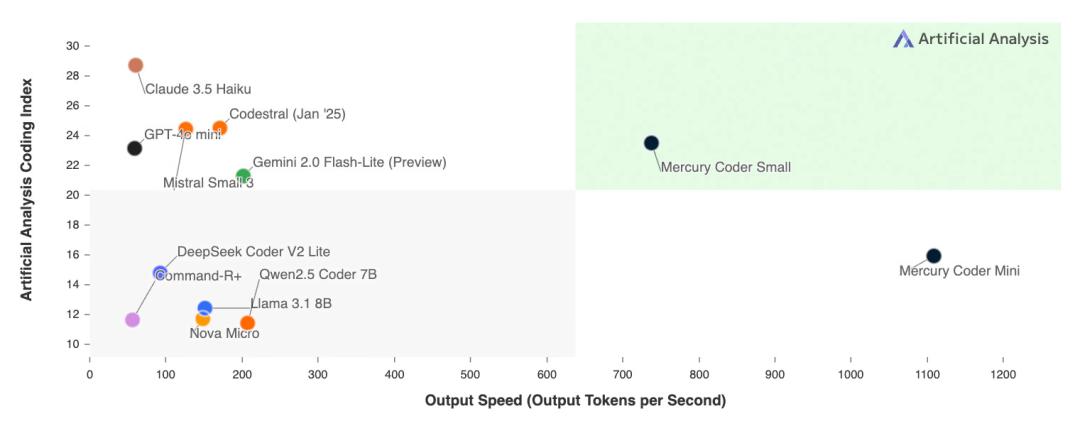

Mercury Coder 性能非常出色,在标准编码基准测试中,Mercury Coder 超越了像 GPT-4o Mini 和 Claude 3.5 Haiku 这样的自回归模型,而这些模型专为速度进行过优化,同时速度还提高了多达 10 倍。

dLLM 的突出特点在于其速度。

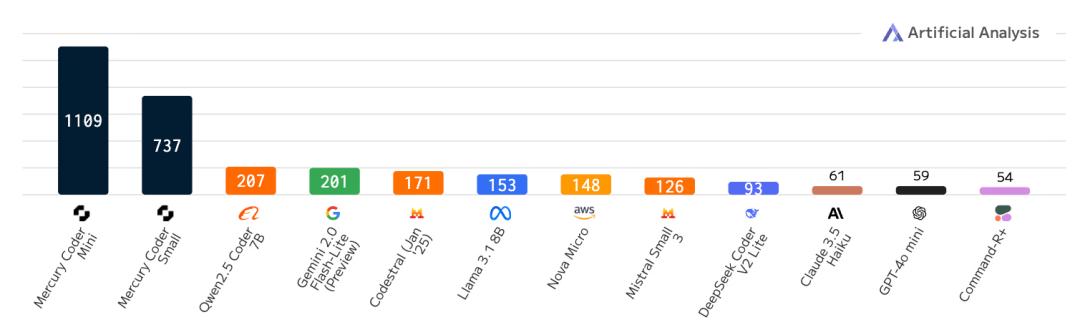

即使是经过速度优化的自回归模型最多也只能达到每秒 200 个 token,但是该研究可以在商用的 NVIDIA H100 上以每秒超过 1000 个 token 的速度提供服务。与一些前沿模型相比,这些模型的运行速度可能还不到每秒 50 个 token,dLLM 提供的加速超过了 20 倍。

dLLM 这样的高吞吐量以前只能使用专门的硬件来实现,比如 Groq、Cerebras 和 SambaNova。现在算法改进也跟上了硬件进步,并且在更快的芯片上,加速效果会更加显著。

下图为 Mercury Coder 在 NVIDIA H100 上实现了每秒超过 1000 个 token 的处理速度。这意味着即使在没有使用专用芯片的情况下,dLLM 也能达到极快的生成速度!

速度比较;每秒输出 token

Mercury Coder 能以极高的速度达到相当高的编程指数,注意这里仅有 Small 和 Mini 版的数据

除了速度,Mercury 的代码补全功能也非常出色。在 Copilot Arena 上进行基准测试时,Mercury Coder Mini 并列第二,超过了 GPT-4o Mini 和 Gemini-1.5-Flash 等模型性能,甚至超过了 GPT-4o 等更大的模型。同时,它也是速度最快的模型,比 GPT-4o Mini 快约 4 倍。

机器之心也做了一些简单的尝试,速度果真是超级快!

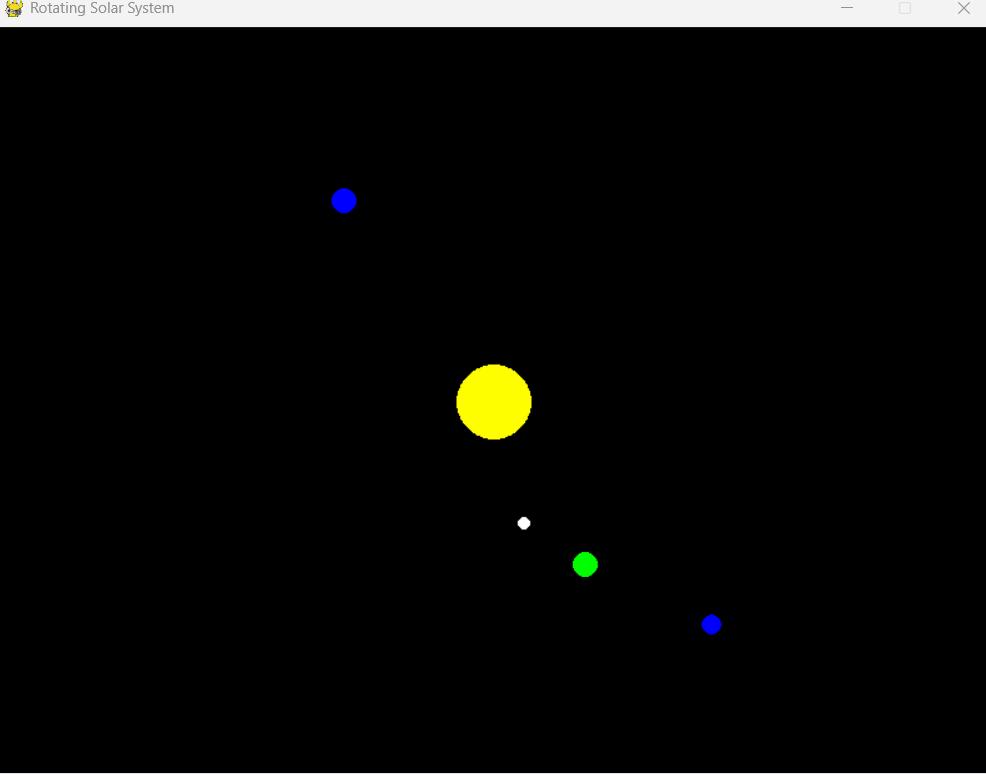

提示词:Write a solar system simulator that rotates(写一个旋转的太阳系模拟器)

可以看到,Mercury Coder 几乎眨眼之间就完成了所有代码的编写,并还附赠了相关说明。

未编辑的实测速度

运行看看效果,有一个 RED 参数未定义的报错,简单修正后即可运行。可以说是超出预料了。

虽然目前 Inception Labs 只发布了 Mercury Coder 模型,但着实让人开始期待起来了呢。

参考链接:

https://www.inceptionlabs.ai/news

https://x.com/karpathy/status/1894923254864978091

https://x.com/volokuleshov/status/1894852582075703509